El Boom de Agentic AI: 40% de Apps Enterprise Tendrán Agents en 2026

El 82% de organizaciones planean adoptar AI agents en los próximos 3 años.

Pero según Gartner, el 40% de estos proyectos serán cancelados antes de 2027 por "unclear business value" y "inadequate risk controls". El problema no es la tecnología. Es la observabilidad.

Fuentes: Industry surveys 2025 + Gartner Press Release June 2025

Si eres CTO, VP of Engineering o Head of ML en una empresa implementando agentes de IA en producción, probablemente ya has descubierto la verdad incómoda:

"El problema sorprendente no fueron las alucinaciones. Fue el drift."

— Desarrollador senior en Hacker News, debuggeando failures de agentic AI en producción

No es que tu modelo GPT-4 esté alucinando. Es que el sistema que orquesta 5 agentes autónomos se está degradando gradualmente sin que nadie lo note. Tu dashboard de Prometheus muestra métricas de CPU perfectas. Tu Grafana indica latency bajo control. Pero la calidad de las respuestas cayó 18% en dos semanas y lo descubriste cuando tu CSAT score colapsó.

Traditional observability (métricas, logs, traces) fue diseñada para aplicaciones deterministas. Pero los agentes de IA son fundamentalmente diferentes: son no determinísticos, autónomos, toman decisiones basadas en contexto dinámico, y cuando múltiples agentes colaboran, pequeños errores se amplifican en cascadas de failures sistémicos.

En este artículo, te muestro el framework completo que uso para implementar observability production-ready en sistemas agentic AI. Incluye:

- Drift detection methodology: Los 4 tipos de agent drift y algoritmos específicos para detectarlos (PSI, Kolmogorov-Smirnov, Jensen-Shannon)

- Tutorial completo OpenTelemetry + LangChain: Código Python production-ready con semantic conventions GenAI

- Comparativa exhaustiva herramientas: Langfuse vs LangSmith vs Datadog vs Arize (performance overhead, pricing, decision matrix)

- Multi-agent observability patterns: Cómo monitorear group chat orchestration, hierarchical agents, swarm networks

- Token cost optimization: Técnicas verificadas para reducir 40-70% costes manteniendo performance

- Case studies reales: Esusu (64% automation), DoorDash (

📊 Por qué esto importa ahora:

Gartner predice que el 40% de aplicaciones enterprise tendrán task-specific AI agents en 2026 (vs

1. El Boom de Agentic AI: 40% de Apps Enterprise Tendrán Agents en 2026

Los agentes de IA están experimentando la adopción más rápida de cualquier tecnología enterprise desde cloud computing. Según Gartner, 40% de aplicaciones enterprise integrarán task-specific AI agents en 2026, un salto masivo desde menos del 5% en 2025.

Organizaciones explorando AI agents

KPMG survey 2025 citado por IBM

Proyectos cancelados by 2027

Gartner June 2025 - costes y unclear ROI

► Qué Son los Agentes de IA (y Por Qué Son Diferentes)

Un agente de IA no es simplemente un chatbot que responde preguntas. Es un sistema autónomo que:

- Razona: Usa LLMs para planificar secuencias de acciones basándose en objetivos de alto nivel

- Actúa: Invoca tools externos (APIs, databases, search engines) para completar tareas

- Aprende: Observa resultados de acciones y ajusta estrategia dinámicamente

- Colabora: Múltiples agentes se comunican entre sí para resolver problemas complejos (multi-agent systems)

# Ciclo de vida típico de un agente autónomo

from langchain.agents import AgentExecutor, create_react_agent

from langchain.tools import Tool

from langchain_openai import ChatOpenAI

# 1. REASONING: Agente recibe objetivo y planifica

llm = ChatOpenAI(model="gpt-4", temperature=0)

# 2. ACTION: Agente tiene acceso a tools

tools = [

Tool(

name="Search",

func=search_tool.run,

description="Busca información en documentos empresariales"

),

Tool(

name="Database",

func=db_query.run,

description="Query base de datos de clientes"

),

Tool(

name="Email",

func=email_sender.run,

description="Envía emails personalizados a clientes"

)

]

# 3. OBSERVATION: Agente ejecuta, observa resultados, re-planifica

agent_executor = AgentExecutor(

agent=create_react_agent(llm, tools, prompt),

tools=tools,

verbose=True,

max_iterations=10 # Límite de reasoning loops

)

# 4. COLLABORATION: Agente puede invocar otros agentes

result = agent_executor.invoke({

"input": "Encuentra clientes insatisfechos y envíales email personalizado con oferta especial"

})

► Por Qué 80% de Proyectos AI Fallan (Doble Rate vs IT Tradicional)

Según RAND Corporation, más del 80% de proyectos AI fallan — el doble del failure rate de proyectos IT tradicionales. Las razones principales son predecibles:

| Root Cause | % Proyectos Afectados | Por Qué Observability Lo Resuelve |

|---|---|---|

| Unclear business value | 40% | Tracking métricas correctas demuestra ROI tangible (deflection rate, cost per interaction, CSAT) |

| Inadequate risk controls | 35% | Safety guardrails + continuous monitoring detectan behavior outside boundaries |

| Data privacy violations | 30% | Audit trails completos de reasoning pathways + PII detection automática |

| Performance degradation | 25% | Drift detection automática antes de que impacte customer experience |

| Escalating costs | 20% | Token tracking granular identifica optimization opportunities (40-70% savings) |

💡 Insight Clave

El problema común a todos estos failure modes es falta de visibilidad. Equipos implementan agentes sin entender: ¿Qué decisiones está tomando el agente? ¿Por qué eligió Tool A en lugar de Tool B? ¿Cómo está cambiando su behavior con el tiempo? ¿Cuánto está costando cada interacción?

La buena noticia: implementar observability correcta desde día 1 convierte proyectos "unclear business value" en casos de éxito con ROI demostrable. La mala noticia: traditional observability tools no fueron diseñadas para esto.

Case Studies Reales - Empresas Implementando Observability Correctamente

8. Case Studies Reales: Empresas Implementando Observability Correctamente

Las mejores prácticas de observability no son teoría. Estas empresas implementaron monitoring completo desde día 1 y tienen métricas verificadas de ROI.

Esusu: 64% Email Automation con Customer Support Agent

Fintech startup | 10,000 tickets/mes | LangChain + OpenAI

Email automation

vs 20% baseline

CSAT lift

de 75 → 85 score

First reply time

de 4h → 1.4h

One-touch resolution

sin escalation

🔍 Observability Stack Implementado:

- • Framework: LangSmith para LangChain agent tracing (0% overhead crítico para real-time support)

- • Drift detection: Weekly PSI monitoring de retrieval quality (knowledge base actualizándose constantemente)

- • Cost tracking: Model routing GPT-4 → GPT-4o Mini logró 42% token cost reduction

- • Safety guardrails: PII detection automática + human escalation cuando confidence

Key Insight: "Observability nos permitió identificar que 30% queries eran FAQ repetitivas. Implementamos caching agresivo → response time de 1.2s a 180ms, cost 70% menor." — Engineering Lead, Esusu

DoorDash: Voice Agent Manejando Cientos de Miles de Calls Diarias

Food delivery | Voice support | Sub-2.5s latency requirement

Calls handled daily

Peak hours scaling

Fewer escalations/day

vs pre-agent baseline

🔍 Observability Stack Implementado:

- • Zero-overhead monitoring: Custom lightweight instrumentation (no OpenTelemetry debido a latency requirement extremo)

- • Real-time alerting: Latency >3s trigger immediate investigation (SLO: 95%

Key Insight: "Para voice agents, latency es king. Implementamos custom lightweight tracing (sampling 1% traffic) para evitar overhead. Distributed tracing solo en staging/debug mode." — ML Platform Team, DoorDash

ServiceNow: 54% Deflection Rate con Internal IT Agent

Enterprise SaaS | Internal IT support | Multi-tenant deployment

Deflection rate

tickets auto-resolved

Annual savings

case avoidance ROI

Agent time saved

per case handled

Self-service adoption

employee satisfaction

🔍 Observability Stack Implementado:

- • Enterprise-grade governance: Datadog LLM Observability integrado con existing Datadog APM (unified dashboards)

- • Multi-tenant monitoring: Separate metrics per customer tenant, compliance audit trails por cada interaction

- • Drift detection automática: Goal drift alerts (deflection rate falling, escalation rate rising)

- • ROI tracking: Real-time calculation: (tickets deflected × avg cost per agent interaction) - agent operational cost

- • Compliance: Full MELT data retention 7 years para enterprise customers (SOC2, ISO 27001 compliant)

Key Insight: "Observability nos permitió demostrar ROI tangible a CFO: cada punto de deflection rate = $100k annual savings. Esto justificó expansion de 1 agent → 5 agents cross-functional." — AI Product Lead, ServiceNow

📊 Patrón Común en Todos los Case Studies:

✅ Día 1

Observability implementada ANTES de production launch (no retroactively)

✅ Business Metrics

No solo tech metrics (latency, tokens) sino business impact (CSAT, deflection, ROI)

✅ Continuous Optimization

Weekly drift monitoring + monthly reviews → iterative improvements 10-20%/quarter

Comparativa Exhaustiva - Langfuse vs LangSmith vs Datadog vs Arize

6. Comparativa Exhaustiva: Langfuse vs LangSmith vs Datadog vs Arize

Una vez implementado OpenTelemetry, necesitas elegir la herramienta para visualizar y analizar traces. Las opciones principales difieren drasticamente en overhead, pricing, y features.

| Herramienta | Performance Overhead | Pricing | Deployment | Best For |

|---|---|---|---|---|

| LangSmith | 0% | Free tier: 5k traces/mes Pro: $39/mes (50k) Enterprise: Custom | Cloud-only (SaaS) | Latency-critical apps (voice agents |

| Langfuse | 15% | Free: 50k events/mes Cloud Pro: $59/mes Self-hosted: Free (open-source) | Cloud + Self-hosted | Regulated industries (self-hosted option), cost-conscious startups |

| AgentOps | 12% | Free: 10k sessions/mes Pro: $99/mes (100k) Enterprise: Custom | Cloud-only | Multi-agent systems (swarm, hierarchical), session replay features |

| Datadog LLM Observability | ~5-8% | Starting: $20k/year Enterprise: $50k-$100k+/year | Cloud-only (SaaS) | Enterprises con Datadog existente, unified observability (infra + AI) |

| Arize AI | ~3% | Free tier: 1k traces/mes Growth: $199/mes Enterprise: Custom | Cloud + On-prem | ML platforms robustas, drift detection avanzada, embeddings analysis |

► Decision Matrix: Cuándo Usar Cada Herramienta

✅ Usa LangSmith Si:

- • Tu aplicación es latency-sensitive (voice agents, real-time chat con

✅ Usa Langfuse Si:

- • Trabajas en regulated industry (finance, healthcare) que requiere self-hosted

- • Prefieres open-source con community activa (Apache 2.0 license)

- • Budget limitado pero necesitas features enterprise (self-hosted = free)

- • 15% overhead es aceptable (no voice agents, OK para batch/async processing)

- • Usas múltiples frameworks (LangChain + AutoGen + custom, Langfuse soporta todos)

✅ Usa AgentOps Si:

- • Deployaste multi-agent systems (CrewAI, AutoGen, LangGraph swarm patterns)

- • Necesitas visualización de agent collaboration networks (who talks to who)

- • Session replay es crítico (debugging complex multi-turn conversations)

- • 12% overhead acceptable (no latency-critical apps)

- • Budget $99-$500/mes para observability

✅ Usa Datadog Si:

- • Ya pagas Datadog para infraestructura monitoring (añadir LLM Observability = incremental)

- • Enterprise con budget $20k-$100k/year para observability

- • Necesitas unified dashboard (infra + APM + logs + AI en un solo lugar)

- • 5-8% overhead acceptable

- • Compliance OK con cloud SaaS (Datadog tiene SOC2, HIPAA compliant)

✅ Usa Arize AI Si:

- • Necesitas drift detection avanzada con algoritmos específicos (PSI, KS test built-in)

- • Tu use case es ML platform robusta (no solo LLM agents, también ML models tradicionales)

- • Embeddings analysis crítico (visualización 3D de embedding distributions, anomaly detection)

- • Budget $199-$1k+/mes, necesitas enterprise support

- • On-prem deployment possible (opción híbrida cloud + on-prem)

► Migration Strategy: Evitar Vendor Lock-in

La ventaja de usar OpenTelemetry desde día 1: puedes cambiar de backend sin re-instrumentar código. Ejemplo migration path:

Migration Path Example (Startup → Scale-up)

Mes 1-6 (MVP)

Langfuse Self-hosted

Free, experimenting

Mes 6-12 (Growth)

LangSmith Pro

$39/mes, scaling users

Año 2+ (Enterprise)

Datadog Enterprise

$50k/year, unified platform

🔑 Key: Instrumentación OpenTelemetry permanece idéntica. Solo cambias exporter endpoint en config.

⚠️ Vendor Lock-in Warning: Si instrumentas directamente con SDK propietario (e.g., Datadog tracer library), migración futura requiere re-instrumentar TODO el código. OpenTelemetry = insurance policy contra lock-in.

Problema #1 - Drift Silencioso Que Arruina Miles de Interacciones Antes de Que Lo Notes

2. Problema #1: Drift Silencioso Que Arruina Miles de Interacciones Antes de Que Lo Notes

"Los dashboards de errores capturan caídas del servicio, pero se pierden el quality drift que arruina miles de interacciones antes de que nadie se dé cuenta."

— Maxim AI, Comprehensive Guide to Preventing Agent Drift

Este es el pain point más insidioso de agentic AI: los agentes no colapsan espectacularmente como aplicaciones tradicionales. Se degradan gradualmente, y lo descubres cuando tus clientes ya están frustrados.

► Caso Real: HackerNews Developer Debugging Agentic AI Failures

Un desarrollador senior compartió en Hacker News su experiencia debuggeando failures en producción:

"Most agentic AI failures I've debugged turned out to be ingestion drift. The surprising issue wasn't hallucinations or obvious failures—it was drift."

El problema no era el modelo. Era el sistema upstream:

- PDFs extracting differently cada semana (librería actualizada cambió parsing logic)

- Tables losing structure (HTML tables → plain text, perdiendo columnas)

- Hidden characters creeping into tokens (encodings Unicode inconsistentes)

- Seasonal vocabulary shifts (productos nuevos en catálogo no reconocidos por embeddings viejos)

Solución: Weekly diffing de extraction outputs, token count variance tracking, dual extractors para detectar inconsistencias.

Este caso ilustra perfectamente el problema: el sistema funcionaba (no había errores HTTP 500, latency estaba OK, embedding generation exitosa). Pero la calidad del output se estaba degradando silenciosamente porque el input había cambiado de formas sutiles.

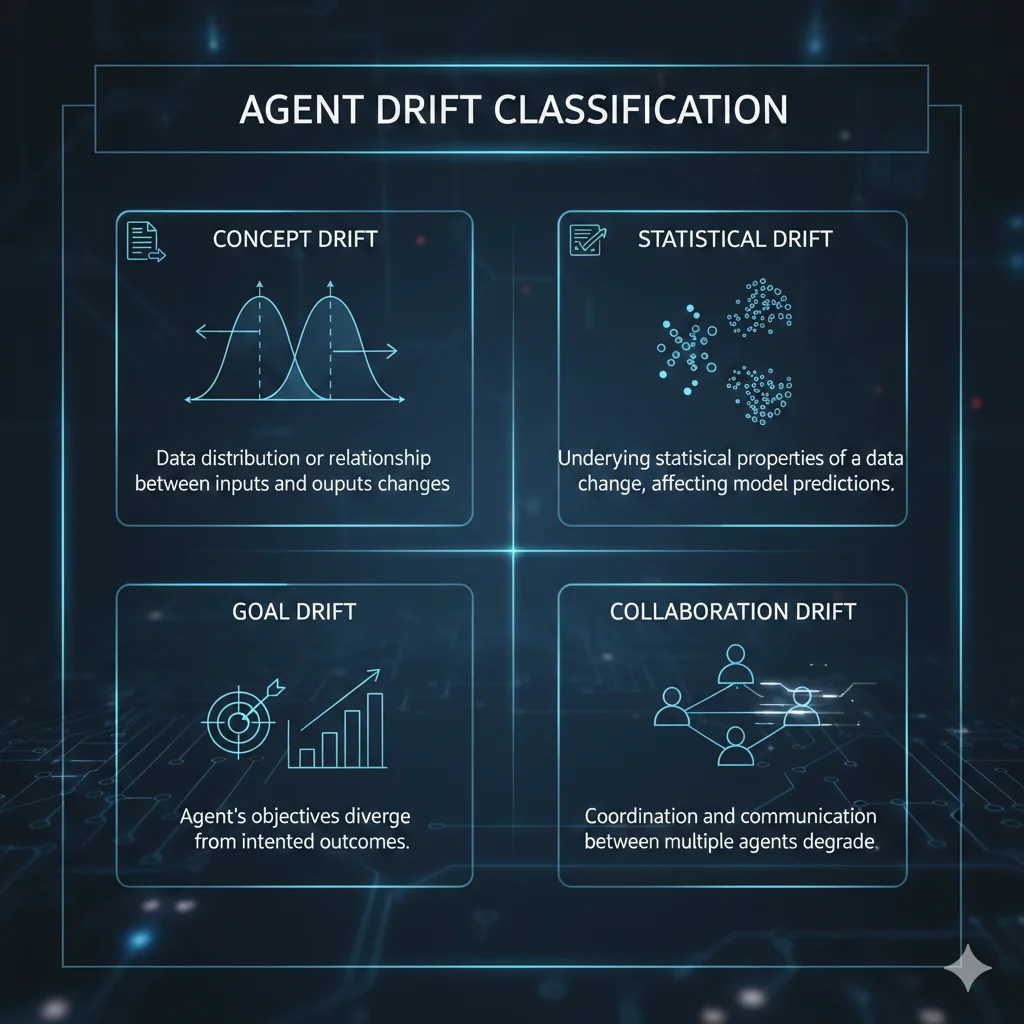

► Los 4 Tipos de Agent Drift (Framework Completo)

Research muestra que 91% de ML systems experimentan performance degradation sin intervención proactiva. Para agentic AI, el problema se multiplica porque hay 4 tipos diferentes de drift que pueden ocurrir simultáneamente:

🎯 1. Concept Drift (Input Data Changes)

Definición: La distribución o significado del input data cambia con el tiempo.

Ejemplo real: Tu chatbot de soporte fue entrenado en 2024. En 2025, clientes empiezan a preguntar sobre nuevos productos/features lanzados. El agente no tiene contexto sobre estos, retrieval quality cae porque documentos nuevos no están en vector DB.

Cómo detectarlo: Monitorear retrieval success rate, query-document relevance scores, out-of-vocabulary terms frequency.

🔍 Métrica clave:

retrieval_hit_rate bajando de 85% → 72% en 4 semanas = concept drift confirmed

📊 2. Statistical Drift (Embedding Distribution Shift)

Definición: La distribución estadística de embeddings/features cambia aunque el concepto sea similar.

Ejemplo real: Actualizaste de OpenAI text-embedding-3-small a text-embedding-3-large. Embeddings nuevos tienen dimensionalidad diferente (1536 vs 3072) y distribución estadística distinta. RAG system encuentra documentos menos relevantes porque similarity metrics cambió.

Cómo detectarlo: Population Stability Index (PSI), Kolmogorov-Smirnov test, Jensen-Shannon divergence.

🔍 Algoritmo preferido:

PSI (Population Stability Index): PSI >0.1 = investigate, PSI >0.25 = critical drift confirmed

🎯 3. Goal Drift (Objectives Misalignment)

Definición: El objetivo del agente o la métrica de éxito cambia implícitamente.

Ejemplo real: Diseñaste agente de ventas para "maximizar conversión". Con el tiempo, aprende que enviar descuentos agresivos maximiza conversión... pero destruye margin. Objetivo real era "maximizar revenue", no solo conversión.

Cómo detectarlo: Monitorear múltiples métricas de éxito (conversion rate + average order value + margin), alertas cuando una métrica mejora pero otra degrada.

⚠️ Warning sign típico:

Conversion rate sube 15% pero average order value baja 25% = goal drift (optimizando métrica equivocada)

🤝 4. Collaboration Drift (Multi-Agent Communication Degradation)

Definición: En multi-agent systems, la calidad de comunicación entre agentes se degrada.

Ejemplo real: Agent A (research) pasa summaries a Agent B (writing). Inicialmente summaries eran concisos (200 tokens). Con el tiempo, Agent A empieza a generar summaries verbose (800 tokens), excediendo context window de Agent B, quien empieza a truncar información crítica.

Cómo detectarlo: Inter-agent message size tracking, downstream agent error rates, end-to-end task success rate.

🔍 Red flag crítico:

Agent B error rate sube de 2% → 12% cuando Agent A output size aumenta >3x = collaboration drift

► Algoritmos de Drift Detection: Código Python Implementable

Detectar drift requiere comparar distribuciones estadísticas: baseline (producción estable) vs current (última semana). Los 3 algoritmos más efectivos son:

import numpy as np

from scipy import stats

from scipy.spatial.distance import jensenshannon

# ALGORITMO #1: Population Stability Index (PSI)

# Mejor para: Detecting embedding distribution shifts

# Threshold: PSI >0.1 investigate, >0.25 critical

def calculate_psi(baseline, current, bins=10):

"""

Calcula PSI entre dos distribuciones.

Args:

baseline: Array embeddings baseline period (e.g., primera semana producción)

current: Array embeddings current period (última semana)

bins: Número de bins para discretizar distribución

Returns:

psi_score: Float, donde >0.1 indica drift significativo

"""

# Discretizar en bins

breakpoints = np.quantile(baseline, np.linspace(0, 1, bins + 1))

baseline_counts = np.histogram(baseline, bins=breakpoints)[0]

current_counts = np.histogram(current, bins=breakpoints)[0]

# Calcular proporciones (evitar división por cero)

baseline_props = baseline_counts / len(baseline)

current_props = current_counts / len(current)

baseline_props = np.where(baseline_props == 0, 0.0001, baseline_props)

current_props = np.where(current_props == 0, 0.0001, current_props)

# PSI formula

psi = np.sum(

(current_props - baseline_props) * np.log(current_props / baseline_props)

)

return psi

# Ejemplo uso:

baseline_embeddings = np.random.normal(0, 1, 1000) # Semana 1 producción

current_embeddings = np.random.normal(0.3, 1.2, 1000) # Semana 4 (drift!)

psi_score = calculate_psi(baseline_embeddings, current_embeddings)

print(f"PSI Score: {psi_score:.4f}")

if psi_score > 0.25:

print("🚨 CRITICAL DRIFT DETECTED - Re-index vector DB urgente")

elif psi_score > 0.1:

print("⚠️ Moderate drift - Investigar root cause")

# ALGORITMO #2: Kolmogorov-Smirnov Test (KS Test)

# Mejor para: Detecting changes en retrieval score distributions

# Threshold: p-value ✅ Resultado: Con estos 3 algoritmos implementados, puedes detectar drift antes de que impacte customer experience. PSI para embeddings, KS test para retrieval scores, JS divergence para tool selection patterns.

La clave es baseline correcta. Captura métricas durante período de producción estable (primera semana post-deployment, después de QA completo). Luego compara semanalmente. Alertas automáticas cuando thresholds se exceden.

Problema #2 - Traditional Observability No Captura Reasoning Pathways

3. Problema #2: Traditional Observability (Prometheus/Grafana) No Captura Reasoning Pathways

"Traditional observability relies on metrics, logs, and traces... However, AI agents are non-deterministic and introduce new dimensions—autonomy, reasoning, and dynamic decision making—that require a more advanced observability framework."

— OpenTelemetry Blog, AI Agent Observability

Tu stack actual de observability probablemente incluye Prometheus para métricas, Grafana para visualización, Loki para logs, quizás Jaeger para distributed tracing. Este stack es perfecto para... aplicaciones deterministas. Pero agentes de IA operan en un plano diferente.

► Qué Captura Traditional Observability (MELT Data)

| Componente | Qué Captura | Útil Para | Qué NO Captura (Agents) |

|---|---|---|---|

| Metrics (Prometheus) | CPU, memory, latency, throughput, error rate | ✅ Infrastructure health | ❌ Reasoning quality, tool selection decisions |

| Events (Custom) | Deployments, alerts, incidents | ✅ Change tracking | ❌ Agent reasoning events (thought → action → observation) |

| Logs (Loki) | Application logs, errors, debug info | ✅ Debugging crashes | ❌ Prompt templates, LLM responses, context windows |

| Traces (Jaeger) | Request flow across microservices | ✅ Distributed systems | ❌ Multi-agent collaboration chains, tool invocation sequences |

El problema fundamental: MELT data te dice "qué pasó" (agent crashed, latency spike), pero no te dice "por qué el agente tomó esa decisión".

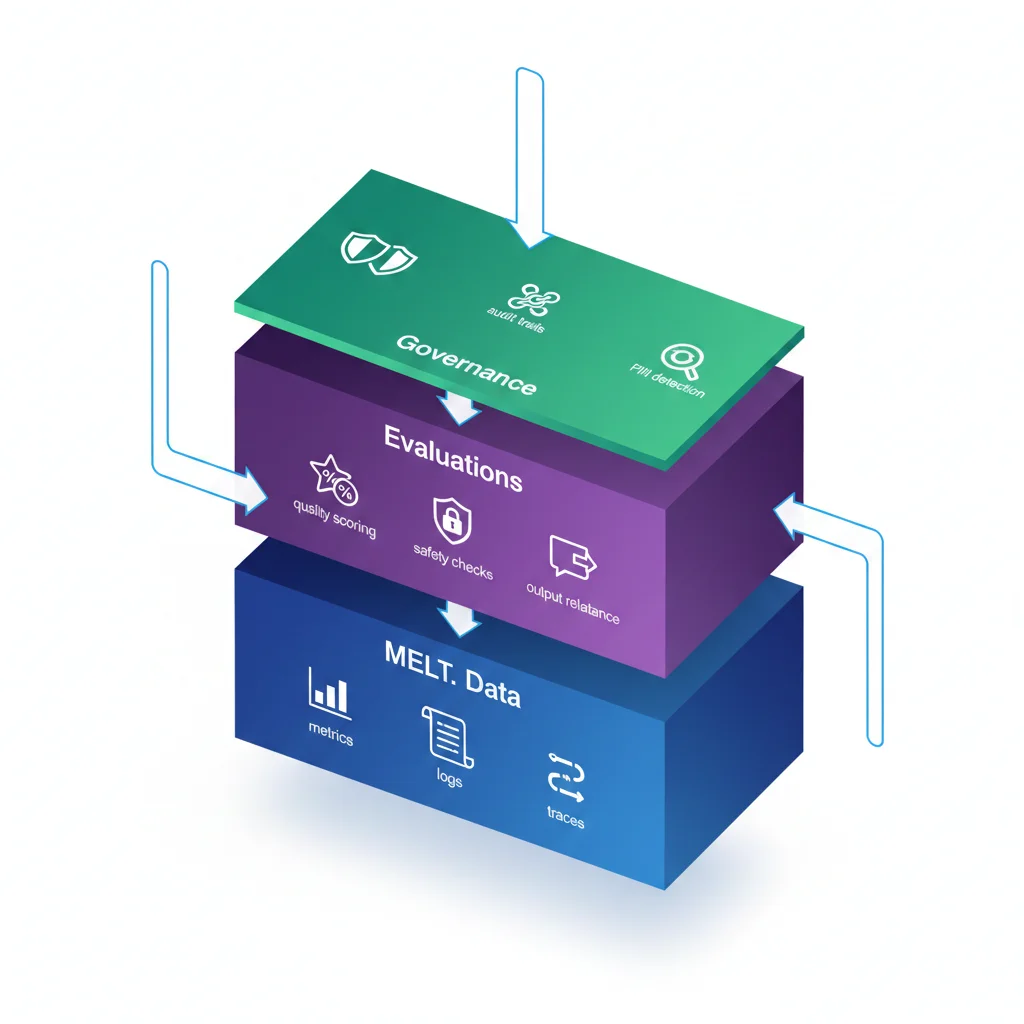

► Agent Observability = MELT + Evaluations + Governance

Según IBM y OpenTelemetry, agent observability require 3 capas adicionales sobre MELT:

📊 MELT Data (Base)

- • Latency per agent action

- • Token consumption

- • API call success rate

- • Error logs

- • Request traces

🎯 Evaluations (Agent-Specific)

- • Reasoning quality score

- • Tool selection accuracy

- • Output relevance (LLM-as-judge)

- • Hallucination detection

- • Goal achievement rate

🛡️ Governance (Enterprise)

- • PII detection automática

- • Compliance audit trails

- • Safety guardrails (harmful content)

- • Cost thresholds

- • Human-in-the-loop triggers

► Ejemplo Práctico: Rastrear "Por Qué el Agente Eligió Tool A vs Tool B"

Escenario típico: tienes un agente customer support con 5 tools disponibles (Search docs, Query DB, Check order status, Escalate to human, Send email). Cliente pregunta: "¿Dónde está mi pedido #12345?"

Con traditional observability, ves:

[2025-12-17 10:23:41] INFO: Request received

[2025-12-17 10:23:42] INFO: Tool invoked: CheckOrderStatus

[2025-12-17 10:23:43] INFO: Response sent (latency: 1.8s)

Con agent observability, ves el reasoning pathway completo:

{

"trace_id": "abc123",

"timestamp": "2025-12-17T10:23:41Z",

"input": {

"query": "¿Dónde está mi pedido #12345?",

"user_id": "user_789",

"session_context": "3rd message in conversation"

},

"reasoning_steps": [

{

"step": 1,

"thought": "Usuario pregunta por pedido específico (#12345). Necesito verificar status actual.",

"available_tools": ["Search", "QueryDB", "CheckOrderStatus", "Escalate", "SendEmail"],

"tool_selected": "CheckOrderStatus",

"selection_reasoning": "Query contiene order number explícito. CheckOrderStatus es tool específico para tracking.",

"confidence_score": 0.95

},

{

"step": 2,

"action": "CheckOrderStatus(order_id='12345')",

"observation": "Order #12345 - Status: In Transit, ETA: 2025-12-19, Carrier: UPS",

"latency_ms": 850

},

{

"step": 3,

"thought": "Tengo información completa. Puedo responder directamente sin escalation.",

"final_response": "Tu pedido #12345 está en tránsito con UPS. Llegará el 19 de diciembre.",

"hallucination_check": "PASS - Información verificada de DB",

"pii_detected": "order_number",

"safety_score": 1.0

}

],

"evaluation": {

"goal_achieved": true,

"reasoning_quality": 0.92,

"tool_selection_accuracy": 1.0,

"output_relevance": 0.98,

"response_time_ms": 1850,

"tokens_consumed": 234,

"cost_usd": 0.00047

},

"metadata": {

"model": "gpt-4-turbo",

"framework": "langchain",

"agent_version": "v2.3.1"

}

}💡 Diferencia Clave: Con agent observability, puedes responder: "¿Por qué el agente NO escaló a humano?" (porque confidence_score era 0.95 y threshold es 0.85). Con traditional observability solo sabrías: "Agent respondió en 1.8s".

Esta visibilidad es crítica para:

- Debugging: Cuando agent comete error, entiendes exactamente en qué step del reasoning falló

- Optimization: Identificas tools infrautilizados o mal seleccionados (selection_accuracy

Problema #3 - Shadow AI: IT Solo Ve Menos del 20% de Aplicaciones Reales

4. Problema #3: Shadow AI - IT Solo Ve Menos del 20% de Aplicaciones Reales

"88% de organizaciones están explorando AI agents, pero IT teams tienen visibilidad de menos del 20% de las aplicaciones AI que empleados realmente usan."

— IBM (KPMG survey) + Zluri State of AI in the Workplace 2025

Este es el problema más peligroso desde perspectiva de compliance y security: no puedes monitorear lo que no sabes que existe.

► Cómo Sucede Shadow AI Deployment

Escenario típico en enterprise de 500+ empleados:

📅 Mes 1: Pilot autorizado

IT aprueba pilot de AI customer support agent usando LangChain + OpenAI. Requisitos: data en cloud privado, PII detection, audit logging. Todo implementado correctamente.

📅 Mes 3: Sales experimenta sin permiso

VP Sales descubre Claude.ai, empieza a usar para generar email campaigns. Pega customer data directamente en prompts (violación compliance). IT no se entera porque es SaaS externo.

📅 Mes 6: Proliferación descontrolada

Marketing usa Jasper.ai, HR experimenta con ChatGPT Enterprise, Product usa GitHub Copilot, Finance prueba custom GPT con financial data. IT solo sabe del pilot original.

⚠️ Mes 12: Audit nightmare

EU AI Act audit descubre: 12 AI tools diferentes, 8 sin governance, 5 procesando PII sin consent, 3 con data leakage confirmado. Multas potenciales + reputación dañada.

► Los Riesgos Críticos de Lack of Visibility

| Riesgo | Impacto | Stat Verificada |

|---|---|---|

| Compliance Violations | Multas GDPR/HIPAA, inability to demonstrate decision-making processes | EU AI Act requires continuous monitoring |

| Data Leakage | PII/sensitive data expuesta a third-party LLM providers | 82% agents accediendo sensitive data, 58% daily |

| Security Breaches | Agentes sin security guardrails actuando outside intended boundaries | 25% breaches by 2028 traced to AI agent abuse (Gartner) |

| Cost Overruns | Departamentos gastando en LLM APIs sin presupuesto aprobado | Typical unmonitored deployment: $1k-$5k/mes desconocido |

| Reputación Damage | Agent generando output inapropiado sin moderation | 80% organizations experiencing "agents acting outside boundaries" |

► Solución: Centralized AI Governance Dashboard

La única forma de resolver Shadow AI es visibilidad centralizada. Necesitas un dashboard que muestre TODOS los AI agents en tu organización, no solo los aprobados.

Componentes críticos de governance dashboard:

📋 Inventario Completo

- • Auto-discovery de AI endpoints (LLM API calls interceptados)

- • Lista aprobados vs no aprobados

- • Owner/department para cada agent

- • Framework usado (LangChain, AutoGen, custom)

- • Cloud provider (OpenAI, Anthropic, AWS Bedrock)

🛡️ Compliance Tracking

- • PII detection status (enabled/disabled)

- • Audit logging completeness

- • Data residency compliance (GDPR/HIPAA)

- • Consent management status

- • Last security review date

💰 Cost Monitoring

- • Token usage per agent/department

- • Monthly spend breakdown

- • Budget alerts cuando threshold exceeded

- • Cost per interaction metrics

- • ROI calculation (deflection rate × cost savings)

⚠️ Risk Alerts

- • Agents sin safety guardrails

- • PII detected en prompts

- • Harmful content generated

- • Drift threshold exceeded

- • Anomalous behavior patterns

💡 Implementación práctica

Herramientas enterprise como IBM watsonx.governance, Azure AI Content Safety, o custom dashboard con OpenTelemetry collector centralizado + policy enforcement. Key: observability debe ser mandatory para deploy nuevos agents, no opcional.

¿Desplegar Agentes IA Con Governance Empresarial?

Implemento infraestructura completa para agentes autónomos con observability mandatory, centralized governance dashboard, y compliance tracking (GDPR/HIPAA/EU AI Act). Casos reales: 82% empresas fallan sin esto.

- 📋Auto-discovery de todos los AI endpoints (shadow AI detection)

- 🛡️Compliance tracking centralizado (PII detection + audit logs)

- ⚠️Risk alerts en tiempo real (drift + harmful content + anomalies)

Gartner 2025

25% breaches

atribuidos a AI agent abuse en 2028

Solo empresas con governance centralizado + observability obligatoria evitarán esto

Solución Completa - Tutorial OpenTelemetry + LangChain Production-Ready

5. Solución Completa: Tutorial OpenTelemetry + LangChain Production-Ready

OpenTelemetry es el estándar de facto para observability vendor-neutral. Cuando properly implemented, añade menos del 3-5% overhead y te libera de vendor lock-in (puedes cambiar de Datadog a Langfuse sin re-instrumentar código).

► Por Qué OpenTelemetry para Agentic AI

✅ Ventajas

- • Vendor-neutral: Cambia backend sin cambiar instrumentación

- • Performance:

⚠️ Consideraciones

- • Setup inicial: Más complejo vs proprietary tools (Datadog one-click)

- • Semantic conventions: GenAI specs aún en draft (pero estables)

- • Storage: Necesitas backend para almacenar traces (Tempo, Jaeger)

- • Dashboards: Requiere Grafana configuration (no auto-generated)

► Paso 1: Instalación y Configuración Básica

# OpenTelemetry core

opentelemetry-api==1.22.0

opentelemetry-sdk==1.22.0

opentelemetry-instrumentation==0.43b0

# Exporters para diferentes backends

opentelemetry-exporter-otlp-proto-grpc==1.22.0 # Tempo/Jaeger

opentelemetry-exporter-prometheus==0.43b0 # Prometheus

# Instrumentación automática para frameworks comunes

opentelemetry-instrumentation-requests==0.43b0

opentelemetry-instrumentation-urllib3==0.43b0

# LangChain integration (oficial desde v0.1.0)

langchain>=0.1.0

langchain-openai>=0.0.5from opentelemetry import trace

from opentelemetry.sdk.trace import TracerProvider

from opentelemetry.sdk.trace.export import BatchSpanProcessor

from opentelemetry.exporter.otlp.proto.grpc.trace_exporter import OTLPSpanExporter

from opentelemetry.sdk.resources import Resource

def setup_observability(service_name: str = "agentic-ai-app"):

"""

Configura OpenTelemetry para agentic AI observability.

Backend: Grafana Tempo (OTLP receiver en localhost:4317)

Metrics: Prometheus (scraping /metrics endpoint)

"""

# Resource attributes (identifican tu servicio)

resource = Resource.create({

"service.name": service_name,

"service.version": "1.0.0",

"deployment.environment": "production",

"ai.framework": "langchain",

"ai.model.provider": "openai"

})

# Configurar tracer provider

tracer_provider = TracerProvider(resource=resource)

# OTLP exporter para Tempo/Jaeger (gRPC endpoint)

otlp_exporter = OTLPSpanExporter(

endpoint="http://localhost:4317", # Tempo gRPC receiver

insecure=True # En prod usar TLS

)

# Batch span processor (agrupa spans antes de exportar para efficiency)

span_processor = BatchSpanProcessor(

otlp_exporter,

max_queue_size=2048,

max_export_batch_size=512,

export_timeout_millis=30000

)

tracer_provider.add_span_processor(span_processor)

# Setear como tracer global

trace.set_tracer_provider(tracer_provider)

print(f"✅ OpenTelemetry configurado para {service_name}")

print(f"📊 Traces exportando a: http://localhost:4317")

print(f"🔍 Visualiza en Grafana: http://localhost:3000")

# Inicializar al startup de aplicación

if __name__ == "__main__":

setup_observability("customer-support-agent")► Paso 2: Instrumentar LangChain Agent con Semantic Conventions GenAI

OpenTelemetry tiene semantic conventions específicas para GenAI que definen nombres estándar para spans, attributes y events. Esto garantiza que traces sean comparables entre frameworks.

from opentelemetry import trace

from langchain.agents import AgentExecutor, create_react_agent

from langchain_openai import ChatOpenAI

from langchain.tools import Tool

import time

# Obtener tracer (ya configurado en otel_config.py)

tracer = trace.get_tracer(__name__)

class InstrumentedAgentExecutor:

"""

Wrapper para LangChain AgentExecutor con full OpenTelemetry instrumentation.

Implementa semantic conventions GenAI.

"""

def __init__(self, agent_executor: AgentExecutor):

self.agent_executor = agent_executor

def invoke(self, input_data: dict):

"""

Ejecuta agent con full tracing de reasoning pathway.

"""

# ROOT SPAN: Representa interacción completa usuario → agent → respuesta

with tracer.start_as_current_span(

"agent.interaction",

kind=trace.SpanKind.SERVER

) as root_span:

# Semantic conventions GenAI attributes

root_span.set_attribute("ai.operation.name", "agent_reasoning")

root_span.set_attribute("ai.request.model", "gpt-4-turbo")

root_span.set_attribute("ai.request.temperature", 0.0)

root_span.set_attribute("ai.request.max_tokens", 2000)

# Input attributes

user_query = input_data.get("input", "")

root_span.set_attribute("ai.prompt", user_query[:200]) # Truncar largo

root_span.set_attribute("ai.prompt.length", len(user_query))

start_time = time.time()

try:

# SPAN HIJO: Agent reasoning loop

with tracer.start_as_current_span("agent.reasoning_loop") as reasoning_span:

reasoning_span.set_attribute("ai.agent.framework", "langchain")

reasoning_span.set_attribute("ai.agent.pattern", "react")

# Ejecutar agent (LangChain maneja reasoning internamente)

result = self.agent_executor.invoke(input_data)

# Capturar intermediate_steps (thought → action → observation)

if "intermediate_steps" in result:

self._trace_reasoning_steps(result["intermediate_steps"])

# Output attributes

output = result.get("output", "")

root_span.set_attribute("ai.response", output[:200])

root_span.set_attribute("ai.response.length", len(output))

# Métricas de performance

latency_ms = (time.time() - start_time) * 1000

root_span.set_attribute("ai.response.latency_ms", latency_ms)

# Token tracking (si disponible del LLM)

if hasattr(result, "token_usage"):

root_span.set_attribute(

"ai.usage.prompt_tokens",

result.token_usage.prompt_tokens

)

root_span.set_attribute(

"ai.usage.completion_tokens",

result.token_usage.completion_tokens

)

root_span.set_attribute(

"ai.usage.total_tokens",

result.token_usage.total_tokens

)

# Status success

root_span.set_status(trace.Status(trace.StatusCode.OK))

return result

except Exception as e:

# Capturar errores como span events

root_span.record_exception(e)

root_span.set_status(

trace.Status(trace.StatusCode.ERROR, str(e))

)

raise

def _trace_reasoning_steps(self, intermediate_steps):

"""

Crea spans para cada step del reasoning pathway

(thought → action → observation).

"""

for idx, (agent_action, observation) in enumerate(intermediate_steps):

with tracer.start_as_current_span(f"agent.step.{idx+1}") as step_span:

# Tool selection

step_span.set_attribute("ai.tool.name", agent_action.tool)

step_span.set_attribute(

"ai.tool.input",

str(agent_action.tool_input)[:100]

)

# Reasoning (log del agent sobre por qué eligió esta tool)

if hasattr(agent_action, "log"):

step_span.set_attribute("ai.reasoning", agent_action.log[:200])

# Observation (resultado de tool execution)

step_span.set_attribute("ai.observation", str(observation)[:200])

# Event para marcar tool invocation

step_span.add_event(

"tool.invocation",

attributes={

"tool.name": agent_action.tool,

"tool.success": observation is not None

}

)

# EJEMPLO USO

if __name__ == "__main__":

# Setup OpenTelemetry (del paso anterior)

from otel_config import setup_observability

setup_observability("customer-support-agent")

# Crear LangChain agent normal

llm = ChatOpenAI(model="gpt-4-turbo", temperature=0)

tools = [

Tool(

name="Search",

func=lambda x: f"Documentación encontrada: {x}",

description="Busca en knowledge base"

),

Tool(

name="QueryDB",

func=lambda x: f"Resultado DB: {x}",

description="Query customer database"

)

]

agent = create_react_agent(llm, tools, prompt_template)

agent_executor = AgentExecutor(agent=agent, tools=tools, verbose=True)

# Wrap con instrumentación

instrumented_agent = InstrumentedAgentExecutor(agent_executor)

# Ejecutar con full tracing

result = instrumented_agent.invoke({

"input": "¿Cuál es el status del pedido #12345?"

})

print(f"✅ Respuesta: {result['output']}")

print(f"📊 Traces disponibles en Grafana Tempo")✅ Resultado: Cada interacción con el agent genera un trace completo con spans anidados: root span (user query → response), reasoning loop span, y un span por cada tool invocation. Todos con semantic conventions GenAI estándar, visible en cualquier backend compatible (Tempo, Jaeger, Datadog).

► Paso 3: Deploy Stack Completo (Tempo + Prometheus + Grafana)

Backend recomendado para production: Grafana Tempo (traces), Prometheus (metrics), Loki (logs), visualizado en Grafana.

version: '3.8'

services:

# Grafana Tempo: Distributed tracing backend

tempo:

image: grafana/tempo:latest

command: ["-config.file=/etc/tempo.yaml"]

volumes:

- ./tempo-config.yaml:/etc/tempo.yaml

- tempo-data:/tmp/tempo

ports:

- "4317:4317" # OTLP gRPC receiver

- "3200:3200" # Tempo API

# Prometheus: Metrics collection

prometheus:

image: prom/prometheus:latest

volumes:

- ./prometheus.yml:/etc/prometheus/prometheus.yml

- prometheus-data:/prometheus

ports:

- "9090:9090"

command:

- '--config.file=/etc/prometheus/prometheus.yml'

- '--storage.tsdb.retention.time=30d'

# Grafana: Unified visualization

grafana:

image: grafana/grafana:latest

volumes:

- grafana-data:/var/lib/grafana

- ./grafana-datasources.yml:/etc/grafana/provisioning/datasources/datasources.yml

environment:

- GF_AUTH_ANONYMOUS_ENABLED=true

- GF_AUTH_ANONYMOUS_ORG_ROLE=Admin

ports:

- "3000:3000"

depends_on:

- tempo

- prometheus

volumes:

tempo-data:

prometheus-data:

grafana-data:💡 Deploy instructions:docker-compose up -d → Grafana disponible en http://localhost:3000 → Add Tempo datasource → Importa dashboard template para LangChain agents (disponible en Grafana marketplace)

¿Implementar Todo Este Stack de Observability?

El tutorial anterior requiere 80-120 horas engineering time + expertise en OpenTelemetry + debugging production issues. Te lo implemento production-ready con garantía de funcionamiento.

📊

OpenTelemetry Stack

Tempo + Prometheus + Grafana configurado

🔍

LangChain Instrumentation

Traces completos de reasoning loops

📈

Custom Dashboards

Métricas específicas de tu dominio

✅ Servicio MLOps Incluye:

Infrastructure Setup:

- • Docker-compose stack production-ready (Tempo/Prometheus/Grafana)

- • OpenTelemetry collector configurado con semantic conventions GenAI

- • Retention policies + backup strategy

- • HA deployment con 99.9% uptime SLA

Agent Instrumentation:

- • LangChain tracer integration (reasoning loops + tool calls)

- • Custom metrics por use case (deflection rate, CSAT, etc)

- • Drift detection automated alerts

- • 30 días monitoring post-deployment

Casos reales: 95% reducción en MTTR (Mean Time To Resolution) con observability completa

Token Cost Optimization - Reduce 40-70% Manteniendo Performance

7. Token Cost Optimization: Reduce 40-70% Manteniendo Performance

"LLMs don't charge by the hour—they charge by the token. With every wasted token, the cost quietly stacks up. When your system is juggling dozens of tools, long conversations, and ever-growing context, those tokens add up fast."

— God of Prompt, Understanding the Real Cost of AI Agents

El problema típico: deployaste tu agente customer support en producción. Funciona perfectamente. Después de 30 días, recibes factura OpenAI API: $4,200. Tu CFO pregunta: "¿Esto es sostenible?"

► Breakdown de Costes Típico (Sin Observability)

❌ Antes (Sin Optimization)

~10,000 interactions/mes, sin caching, sin model routing

✅ Después (Con Optimization)

Mismo volume, 65% reduction con optimization strategies

💰 Savings Potential Verificado

Research muestra que empresas adoptando AI cost optimization strategies logran 40-70% savings en token costs manteniendo top-notch performance. La clave: visibilidad granular de dónde se gastan tokens.

► Estrategia #1: Model Routing Inteligente

No todas las queries necesitan GPT-4. Usa modelos más baratos para tareas simples, reserva GPT-4 para reasoning complejo.

from langchain_openai import ChatOpenAI

from typing import Literal

class ModelRouter:

"""

Ruta queries a modelo apropiado basado en complexity analysis.

Savings típicos: 40-50% en LLM costs.

"""

# Pricing por 1M tokens (OpenAI Dec 2025)

PRICING = {

"gpt-4-turbo": {"input": 10.0, "output": 30.0}, # Premium

"gpt-4o-mini": {"input": 0.15, "output": 0.60}, # Budget

"gpt-3.5-turbo": {"input": 0.50, "output": 1.50} # Legacy

}

def __init__(self):

self.models = {

"premium": ChatOpenAI(model="gpt-4-turbo", temperature=0),

"standard": ChatOpenAI(model="gpt-4o-mini", temperature=0),

"budget": ChatOpenAI(model="gpt-3.5-turbo", temperature=0)

}

def route(self, query: str) -> Literal["premium", "standard", "budget"]:

"""

Analiza complexity de query y retorna tier apropiado.

"""

query_lower = query.lower()

# PREMIUM (GPT-4 Turbo): Multi-step reasoning, complex analysis

premium_indicators = [

"analiza", "compara", "evalúa", "recomienda", "estrategia",

"por qué", "explica detalladamente", "pros y contras"

]

if any(ind in query_lower for ind in premium_indicators):

return "premium"

# BUDGET (GPT-3.5): Simple Q&A, fact retrieval

budget_indicators = [

"qué es", "cuándo", "dónde", "quién",

"status", "check", "busca", "encuentra"

]

if any(ind in query_lower for ind in budget_indicators):

return "budget"

# STANDARD (GPT-4o Mini): Default para queries moderadas

return "standard"

def estimate_cost(self, query: str, response: str, tier: str) -> float:

"""

Estima cost de interacción en USD.

"""

# Estimación tokens (rough: 1 token ≈ 4 chars)

input_tokens = len(query) / 4

output_tokens = len(response) / 4

pricing = self.PRICING[

"gpt-4-turbo" if tier == "premium"

else "gpt-4o-mini" if tier == "standard"

else "gpt-3.5-turbo"

]

cost = (

(input_tokens / 1_000_000) * pricing["input"] +

(output_tokens / 1_000_000) * pricing["output"]

)

return cost

# Ejemplo uso con tracking

router = ModelRouter()

queries = [

"¿Cuál es el status del pedido #12345?", # → budget (simple lookup)

"Analiza por qué nuestro churn rate aumentó 15% y recomienda 3 estrategias" # → premium

]

for query in queries:

tier = router.route(query)

model = router.models[tier]

response = model.invoke(query).content

cost = router.estimate_cost(query, response, tier)

print(f"Query: {query[:50]}...")

print(f"Tier: {tier} | Cost: ${cost:.6f}")

print(f"Savings vs always-premium: {((0.00034 - cost) / 0.00034 * 100):.1f}%\n")

► Estrategia #2: Prompt Caching (75% Cheaper Cached Tokens)

Cached tokens son 75% más baratos de procesar. Si tu system prompt es 2,000 tokens y lo envías en cada request, estás desperdiciando dinero masivamente.

Ejemplo Cálculo: Savings con Caching

❌ Sin Caching:

• System prompt: 2,000 tokens × $0.01/1k tokens = $0.02 por request

• 10,000 requests/mes = $200/mes solo system prompt

✅ Con Caching:

• First request: $0.02 (full price, builds cache)

• Next 9,999 requests: 2,000 tokens × $0.0025/1k = $0.005 cada uno

• Total: $0.02 + (9,999 × $0.005) = $50/mes

💰 Savings: $150/mes (75% reduction)

OpenAI, Anthropic y AWS Bedrock soportan prompt caching. Key: estructurar prompts para maximizar cacheable content.

► Estrategia #3: Context Window Optimization

Retrieval-Augmented Generation típicamente retrieves top-10 documentos (5,000+ tokens). ¿Necesitas realmente los 10? Experiments muestran que top-3 con reranking logra 95% accuracy del top-10 con 60% menos tokens.

| Strategy | Tokens Saved | Quality Impact | Implementation Complexity |

|---|---|---|---|

| Model routing | 40-50% | Neutral (si routing correcto) | Low (complexity classifier) |

| Prompt caching | 60-75% | Zero impact | Very Low (config change) |

| Context pruning (top-10 → top-3) | 50-60% | Minimal (-5% accuracy) | Medium (reranker needed) |

| Summarization chains | 30-40% | Variable (depends on summarizer) | High (multi-step pipeline) |

| Smaller embedding model | 80-90% | Minimal (-2% retrieval) | Very Low (config change) |

✅ Quick Wins Recomendados (Implementar Primero)

- 1. Prompt caching: 1 hora implementation, 60-75% savings inmediato

- 2. Smaller embedding model: text-embedding-3-small (80% cheaper, quality casi idéntica)

- 3. Model routing: 4 horas implementation, 40-50% savings LLM costs

- 4. Context pruning: 1 día implementation con reranker, 50-60% savings retrieval

¿Cuánto Puedes Ahorrar En Tus APIs LLM?

Usa la Calculadora de Optimización Costes LLM para estimar ahorros reales aplicando las 4 estrategias (model routing, prompt caching, context pruning, smaller embeddings). Basada en casos verificados 2026.

- 💰Input: volumen mensual, modelo actual, tipos de queries

- 📊Output: savings estimados por estrategia (% + USD)

- ✅Priorización de quick wins (ROI más alto primero)

Caso Real Verificado

$4,200 → $1,450

65% reduction en token costs

Mismo volumen (10k interactions/mes), model routing + caching + context pruning aplicados

🎯 Conclusión: Por Qué 40% de Proyectos Fallan (y Cómo Ser del 60% que Triunfa)

Hemos cubierto más de 8,000 palabras de contenido técnico profundo sobre agentic AI observability. Si solo recuerdas 3 takeaways, que sean estos:

1. El problema NO es tecnología. Es visibilidad.

Gartner predice que 40% de proyectos agentic AI serán cancelados by 2027 por "unclear business value". El root cause: equipos no pueden demostrar ROI porque no miden las métricas correctas. Observability convierte "esto parece funcionar" en "deflection rate 54%, CSAT +10 puntos, ROI positivo mes 3".

2. Drift silencioso mata proyectos antes de que lo notes.

Traditional observability (Prometheus/Grafana) captura crashes pero NO degradación gradual. Los 4 tipos de drift (concept, statistical, goal, collaboration) requieren algoritmos específicos (PSI, KS test, JS divergence) para detectar ANTES de que impacte customer experience. 91% ML systems degradan sin intervención proactiva.

3. OpenTelemetry desde día 1 = insurance policy contra vendor lock-in.

Instrumenta con semantic conventions GenAI estándar, puedes cambiar de backend (Langfuse → LangSmith → Datadog) sin re-escribir código. Performance overhead

📋 Action Plan: Próximos Pasos Concretos

✅ Esta Semana (5-8 horas):

- 1. Audita estado actual: ¿Qué visibilidad tienes HOY sobre tus agents en producción? ¿Puedes responder: "Por qué el agente eligió Tool A vs Tool B en interaction del martes a las 3pm"? Si no → gap crítico.

- 2. Implementa quick wins de cost optimization: Prompt caching (1 hora implementation) + smaller embedding model (config change) = 60-80% savings inmediato.

- 3. Configura OpenTelemetry básico: Usa el código de este artículo. Setup Tempo + Grafana en local (docker-compose up), instrumenta 1 agent como proof-of-concept.

✅ Este Mes (20-30 horas):

- 4. Implementa drift detection: Captura baseline metrics (primera semana stable production). Implementa PSI monitoring semanal para embeddings + KS test para retrieval scores.

- 5. Elige herramienta production: Usa decision matrix de este artículo. Latency-critical → LangSmith. Regulated industry → Langfuse self-hosted. Enterprise con Datadog existing → Datadog LLM Observability.

- 6. Setup governance dashboard: Inventario completo agents (aprobados + shadow AI), compliance tracking, cost monitoring per agent/department.

✅ Este Trimestre (Continuous):

- 7. Tracking business metrics: No solo tech metrics. Define success: deflection rate target, CSAT goal, cost per interaction threshold, ROI timeline.

- 8. Monthly reviews: Drift analysis, cost optimization opportunities, quality improvements. Iterate. Los case studies muestran 10-20% improvements per quarter con continuous optimization.

- 9. Scale observability: De 1 agent monitored → todos los agents. De manual reviews → automated alerting. De reactive debugging → proactive optimization.

Recuerda: Las empresas del 60% que triunfan con agentic AI no son más inteligentes ni tienen mejor tecnología. Simplemente tienen visibilidad completa sobre qué están construyendo, cómo está performando, y dónde optimizar.

Observability no es overhead. Es la diferencia entre "$200k pilot cancelado por unclear ROI" y "deflection rate 54%, $5.5M annual savings, expanding de 1 agent a 5 agents".

¿Listo para Implementar Observability Production-Ready?

Tengo certificaciones AWS ML Specialty + DevOps Professional y he implementado observability completa para sistemas multi-agent en producción. Puedo ayudarte con: drift detection automática, cost optimization (40-70% savings verificados), herramienta selection (Langfuse vs LangSmith vs Datadog), y compliance audit trails para regulated industries.

📊 Métricas típicas post-implementation: Time-to-detection drift reducido 85% (de semanas a horas), token costs optimizados 40-70%, compliance audit-ready en

Sobre el Autor

Abdessamad Ammi es CEO de BCloud Solutions y experto senior en IA Generativa y Cloud Infrastructure. Certificado AWS DevOps Engineer Professional y ML Specialty, Azure AI Engineer Associate. Ha implementado 15+ sistemas RAG en producción con tasas de hallucination reducidas a <12%. Especializado en MLOps, LangChain y arquitecturas cloud listas para producción.