¿Por Qué los Costes Eléctricos de Data Centers IA Están Explotando?

267% Los costes eléctricos mayoristas en áreas con data centers son hasta 267% más caros que hace 5 años

Fuente: Bloomberg Graphics & CNBC, Noviembre 2025

Si eres CTO, VP Engineering o Head of Infrastructure en una empresa SaaS o scale-up, probablemente has notado algo alarmante en tus facturas de cloud computing últimamente: los costes eléctricos están explotando.

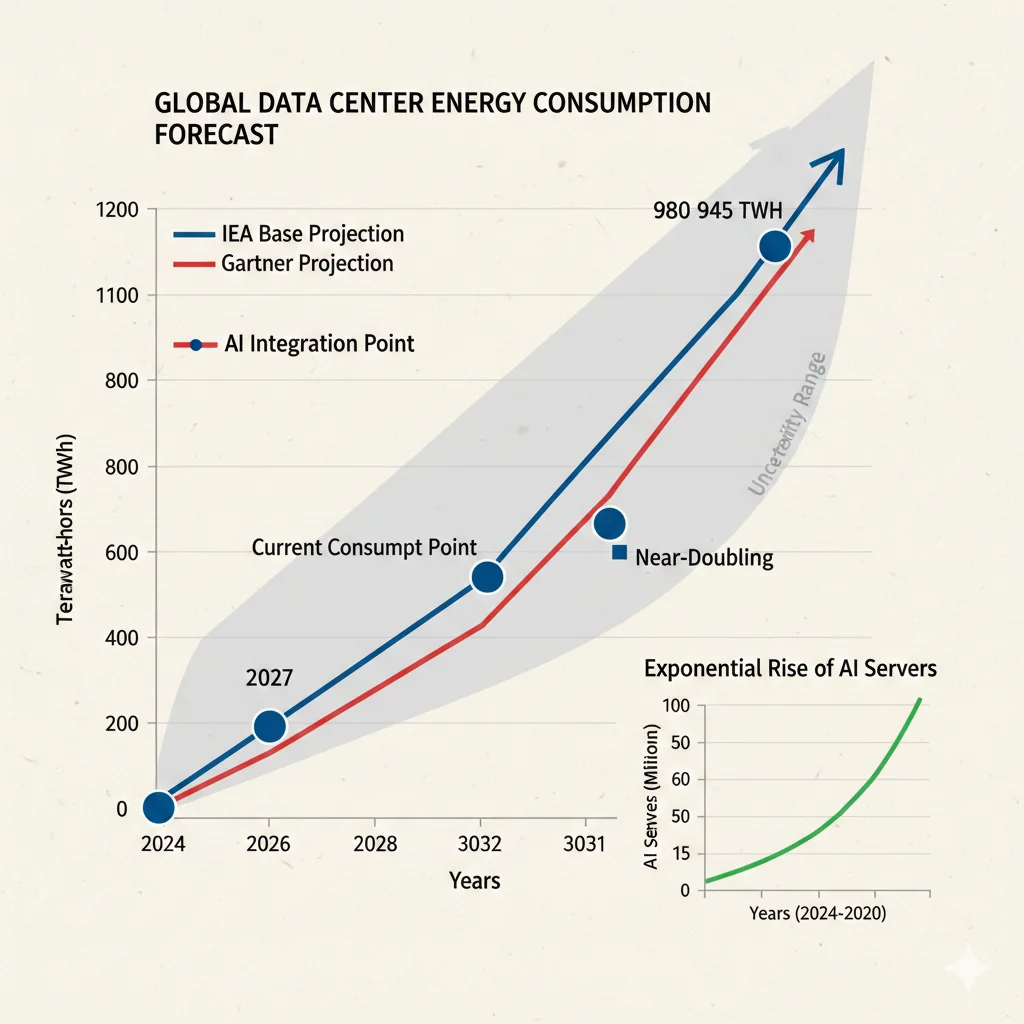

Y esto no es un problema aislado. Según la Agencia Internacional de Energía (IEA), los data centers consumieron 415 terawatt-hours (TWh) de electricidad globalmente en 2024 —aproximadamente el 1.5% de toda la electricidad mundial. Pero aquí viene la parte realmente preocupante: esta cifra se DUPLICARÁ para 2030, alcanzando 945 TWh.

🚨 La Tormenta Perfecta Ya Está Aquí

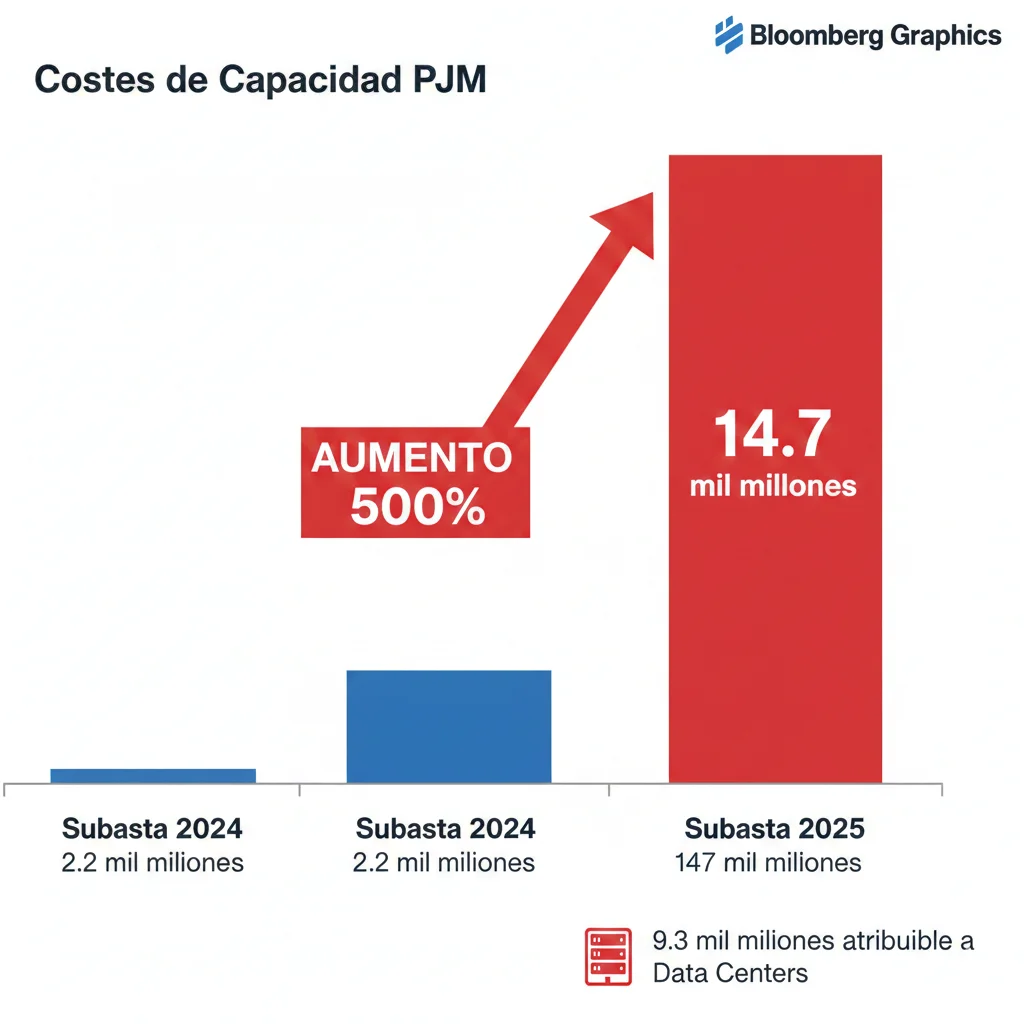

- ►500% aumento en costes de capacidad eléctrica PJM (Mid-Atlantic/Midwest US): de $2.2 mil millones a $14.7 mil millones en un solo año

- ►Residentes en Maryland y Ohio verán aumentos de $18-$32/mes en sus facturas debido a demanda de data centers

- ►40% de data centers IA estarán limitados operacionalmente por disponibilidad energética para 2027 (Gartner)

- ►Servidores optimizados para IA usan 10x más energía que servidores convencionales

Pero antes de que entres en pánico y canceles todos tus proyectos de IA, hay buenas noticias: existen estrategias comprobadas que pueden reducir tu consumo energético entre 15% y 75% sin sacrificar performance.

En este artículo te muestro exactamente:

- ✓Por qué los costes energéticos están explotando y qué regiones están más afectadas

- ✓Dónde se va exactamente la electricidad (breakdown detallado training vs inference vs cooling)

- ✓7 estrategias técnicas implementables con ROI calculado y código de ejemplo

- ✓Un framework de decisión de 90 días para CTOs que necesitan actuar YA

Sobre mí: Soy Abdessamad Ammi, fundador de BCloud Consulting. He ayudado a empresas SaaS como MasterSuiteAI a reducir sus costes de infraestructura cloud hasta un 45% mientras escalaban a procesar 1M+ requests diarios.

Certificaciones: AWS ML Specialty | AWS DevOps Professional | Azure AI Engineer

1. ¿Por Qué los Costes Eléctricos de Data Centers IA Están Explotando?

La respuesta corta: una tormenta perfecta de demanda exponencial de IA, infraestructura de red obsoleta y concentración geográfica de data centers. Vamos a desglosarlo factor por factor.

► Factor #1: Explosión de Workloads de IA Generativa

El año 2024 marcó un punto de inflexión. Según Gartner, los servidores optimizados para IA consumieron 93 TWh en 2025, pero esta cifra se multiplicará por 5 veces para 2030, alcanzando 432 TWh.

📊 Comparativa Servidores Convencionales vs IA:

Servidor Convencional (CPU)

~200W

Consumo promedio

Servidor IA (GPU-heavy)

~2,000W

10x más consumo

Y la tendencia va a peor. Tom's Hardware reporta que los GPUs de próxima generación post-Blackwell podrían consumir hasta 15,360 watts (comparado con los 1,400W del Blackwell actual). Esto requerirá refrigeración líquida o por inmersión de forma obligatoria.

► Factor #2: Infraestructura de Red No Diseñada para Este Crecimiento

Las redes eléctricas regionales fueron diseñadas asumiendo un crecimiento de demanda del 1-2% anual. Pero data centers están creciendo al 20-30% anual en algunas regiones.

El caso más dramático: PJM Interconnection (Mid-Atlantic/Midwest US), que gestiona la red eléctrica para 65 millones de personas. Su subasta de capacidad para 2025-2026 resultó en un aumento de $2.2 mil millones a $14.7 mil millones —un incremento del 500%.

⚠️ Dato crítico: El 63% de este incremento ($9.3 mil millones) fue causado directamente por demanda de data centers, según análisis de IEEFA.

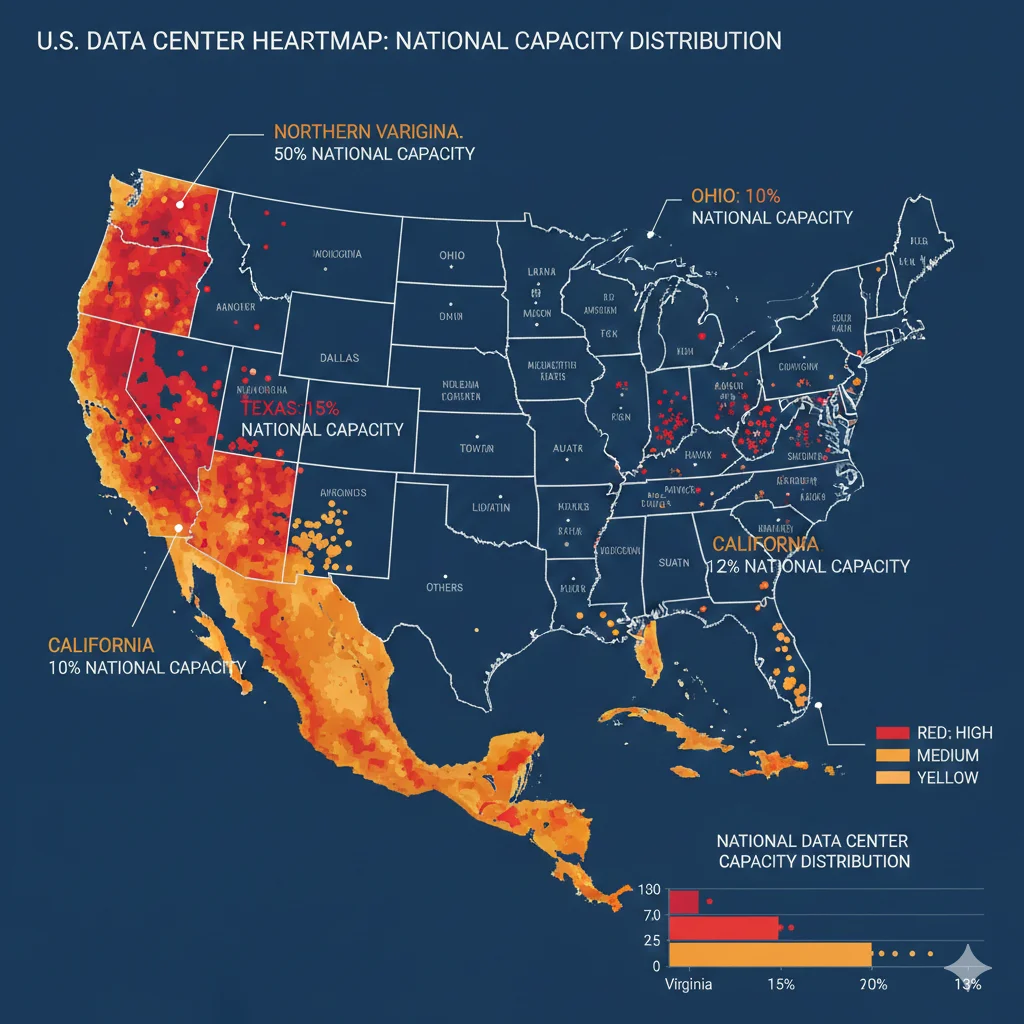

► Factor #3: Concentración Geográfica en Hotspots

Northern Virginia (Loudoun County), conocido como "Data Center Alley", alberga el 70% de todo el tráfico de internet mundial. Esta concentración extrema ha creado una competencia feroz por electricidad limitada.

Según Carnegie Mellon University, las facturas eléctricas en el centro y norte de Virginia podrían aumentar hasta un 25% para 2030 debido exclusivamente a demanda de data centers.

💰 La Carrera Armamentista de Infraestructura IA

Los hyperscalers están apostando cientos de miles de millones en 2025:

Microsoft

$120B

Infraestructura IA 2025

$75B

Data centers + AI chips

Meta

$72B

CAPEX 2025 proyectado

Fuente: MIT Technology Review

5 Estrategias Comprobadas para Reducir Consumo Energético Sin Afectar Performance

5. Cinco Estrategias Comprobadas para Reducir Consumo Energético Sin Afectar Performance

Ahora vamos a lo actionable. Estas 5 técnicas están comprobadas en producción con ROI verificado. Incluyo código de ejemplo para cada una.

1 Power Capping de GPUs: 12-15% Ahorro con 3% Performance Loss

Qué es: Limitar el consumo máximo de tus GPUs a 60-80% de su capacidad térmica (TDP). Según NVIDIA, esto reduce consumo 12-15% con solo 3% de aumento en tiempo de ejecución.

✅ ROI Ejemplo: 1,000 GPUs H100 (700W cada uno) × 0.15 savings × 24h × 30 días × precio electricidad = ahorro mensual sustancial

Cuándo NO usar: Inference latency-critical con SLA

2 Workload Scheduling Basado en Intensidad de Carbono: 8-31% Reducción Emisiones

Qué es: Ejecutar workloads batch (training, data processing) durante horarios cuando la red eléctrica tiene mayor proporción de energía renovable. Según investigación ACM, esto logra reducciones de 8-31% en carbon footprint.

Ejemplo real: Google implementó carbon-aware computing y logró aumentos del 17-40% en utilización de energía renovable simplemente cambiando timing de workloads.

📝 Código: Scheduler Usando Google Cloud Carbon Footprint API

#!/usr/bin/env python3

"""

Carbon-Aware Workload Scheduler

Ejecuta training jobs cuando grid tiene menor intensidad de carbono

"""

import requests

import schedule

import time

from datetime import datetime, timedelta

import subprocess

# API gratuita para carbon intensity por región

CARBON_API_BASE = "https://api.carbonintensity.org.uk/regional/intensity"

def get_carbon_intensity(region_code: str = "1") -> dict:

"""

Obtiene intensidad de carbono actual y forecast

Returns: { 'current': 150, 'forecast_low': 120, 'best_hour': 14 }

"""

try:

# Intensidad actual

response = requests.get(f"{CARBON_API_BASE}/{region_code}")

data = response.json()['data'][0]['data'][0]

current_intensity = data['intensity']['forecast']

# Forecast próximas 24h

tomorrow = (datetime.now() + timedelta(days=1)).strftime("%Y-%m-%dT%H:%MZ")

forecast_url = f"{CARBON_API_BASE}/{region_code}/{datetime.now().strftime('%Y-%m-%dT%H:%MZ')}/{tomorrow}"

forecast_response = requests.get(forecast_url)

forecast_data = forecast_response.json()['data']['data']

# Encontrar hora con menor intensidad

min_forecast = min(forecast_data, key=lambda x: x['intensity']['forecast'])

best_hour = datetime.fromisoformat(

min_forecast['from'].replace('Z', '+00:00')

).hour

return {

'current': current_intensity,

'forecast_low': min_forecast['intensity']['forecast'],

'best_hour': best_hour

}

except Exception as e:

print(f"Error fetching carbon data: {e}")

return None

def should_run_training() -> bool:

"""Decide si ahora es buen momento para ejecutar training

Threshold: ejecutar solo si intensidad 💡 Pro tip: Para AWS, usa AWS Customer Carbon Footprint Tool. Para GCP, Carbon Footprint dashboard con BigQuery export.

ROI Dual: No solo reduces emissions (ESG compliance), también reduces coste porque períodos de baja intensidad de carbono típicamente coinciden con electricidad off-peak más barata (10-20% savings).

3 Model Quantization: 20-50% Reducción Power Consumption

Qué es: Reducir la precisión de los pesos del modelo de FP32 (32-bit floating point) a INT8 (8-bit integer) o FP16. Estudios de Nature muestran reducciones de 20-50% en consumo energético con pérdida de accuracy

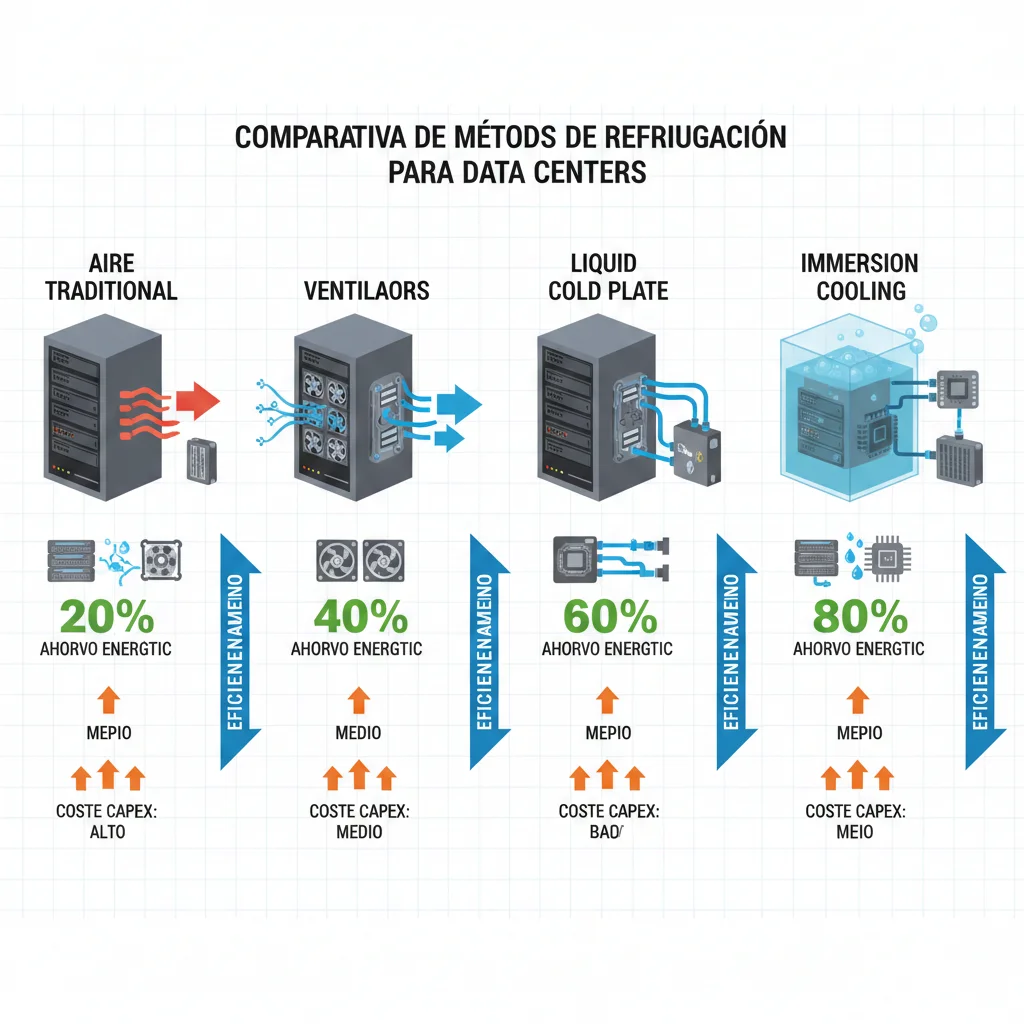

4 Liquid Cooling: 15-95% Reducción Consumo Cooling

Qué es: Sustituir refrigeración por aire tradicional con liquid cooling (cold plate) o immersion cooling. Cooling representa 30-40% del consumo total de un data center según McKinsey.

| Método Cooling | Energy Savings | CAPEX por Servidor | ROI Timeline | Best For |

|---|---|---|---|---|

| Aire (Baseline) | 0% (baseline) | Incluido | N/A | Legacy, |

| Liquid (Cold Plate) | 15-30% | Extra | 18-24 meses | 20-50 kW/rack (H100, Blackwell) |

| Liquid (Direct-to-Chip) | 40-60% | Extra | 24-30 meses | High-density AI clusters |

| Immersion Cooling | 80-95% | Extra (mayor inversión) | 30-36 meses | >50 kW/rack (Rubin 2027+) |

Fuentes: Microsoft Nature Study, DOE Liquid Cooling Research

🧊 Caso Real: Microsoft Ireland Data Center

Microsoft implementó two-phase immersion cooling en su facility Dublin y logró:

- • 13-50% reducción GHG emissions (depending on electricity grid mix)

- • 5-10% reducción water consumption total lifecycle

- • Aumento densidad de 20 kW/rack a 100+ kW/rack sin expandir footprint

Decision tree: Si planeas desplegar GPUs Blackwell (1,400W) o futuros Rubin (3,600W+), liquid cooling NO es opcional—es obligatorio para cumplir density requirements sin quemar el data center.

5 Zeus Framework: 15-75% Energy Reduction Training (Software-Only)

Qué es:Zeus es un framework open-source que optimiza dinámicamente GPU power limits y batch sizes durante training. NO requiere cambios de hardware—es puramente software.

📊 Zeus Benchmarks (USENIX Paper)

ResNet-50 Training:

- • Energy reduction: 75.8%

- • Training time: 60.6% faster

- • vs naive max batch size + max power

BERT-Large Fine-tuning:

- • Energy reduction: 15.3%

- • Same accuracy

- • Dynamic power capping 180-300W

Cómo funciona: Zeus mide continuamente energy-to-solution (Joules para alcanzar target accuracy) y ajusta batch size + GPU power limits en tiempo real para minimizar energía total.

📝 Código: Integración Zeus con PyTorch

#!/usr/bin/env python3

"""

Zeus Framework Integration

Optimiza training energy consumption automáticamente

"""

# Instalar: pip install zeus-ml

from zeus.monitor import ZeusMonitor

from zeus.optimizer import GlobalPowerLimitOptimizer

import torch

import torch.nn as nn

from torch.utils.data import DataLoader

# Tu modelo PyTorch normal

model = nn.Sequential(

nn.Linear(784, 256),

nn.ReLU(),

nn.Linear(256, 10)

).cuda()

optimizer = torch.optim.Adam(model.parameters(), lr=0.001)

criterion = nn.CrossEntropyLoss()

# Inicializar Zeus monitor

zeus_monitor = ZeusMonitor(gpu_indices=[0]) # Monitor GPU 0

# Inicializar power limit optimizer

power_optimizer = GlobalPowerLimitOptimizer(

monitor=zeus_monitor,

gpu_indices=[0]

)

# Training loop con Zeus

def train_epoch(dataloader):

model.train()

total_loss = 0

# Comenzar medición energía

zeus_monitor.begin_window("training_epoch")

for batch_idx, (data, target) in enumerate(dataloader):

data, target = data.cuda(), target.cuda()

# Forward + backward normal

optimizer.zero_grad()

output = model(data)

loss = criterion(output, target)

loss.backward()

optimizer.step()

total_loss += loss.item()

# Cada N batches, Zeus optimiza power limit

if batch_idx % 10 == 0:

# Obtener energy consumption hasta ahora

measurement = zeus_monitor.end_window("training_epoch")

energy_joules = measurement.total_energy

time_seconds = measurement.time

# Zeus decide nuevo power limit óptimo

new_power_limit = power_optimizer.optimize(

energy=energy_joules,

time=time_seconds,

current_loss=loss.item()

)

print(f"Batch {batch_idx}: Loss={loss.item():.4f}, "

f"Energy={energy_joules:.2f}J, "

f"New Power Limit={new_power_limit}W")

# Reiniciar window para próxima medición

zeus_monitor.begin_window("training_epoch")

return total_loss / len(dataloader)

# Ejecutar training

dataloader = DataLoader(...) # Tu dataset

for epoch in range(10):

avg_loss = train_epoch(dataloader)

print(f"Epoch {epoch}: Avg Loss = {avg_loss:.4f}")

# Obtener report final

final_report = zeus_monitor.get_total_energy()

print(f"\n⚡ ZEUS REPORT:")

print(f"Total Energy: {final_report['total_energy']:.2f} kWh")

print(f"Average Power: {final_report['avg_power']:.2f} W")

print(f"Cost Estimate: ${final_report['cost_estimate']:.2f}")

✅ Ventajas Zeus: Zero CAPEX, funciona con PyTorch/TensorFlow/JAX existente, open-source (MIT license), minimal code changes.

⚠️ Alternativas: Perseus (U Michigan, 30% savings workload distribution), GPOEO (batch size + power joint optimization). Zeus es el más maduro/documentado.

🎯 Priorización: ¿Qué Implementar Primero?

Basado en esfuerzo de implementación vs impacto energético:

| Prioridad | Estrategia | Ahorro Energético | Esfuerzo | Timeline |

|---|---|---|---|---|

| 1º | Power Capping GPUs | 12-15% | Muy Bajo (1 script) | 1-2 días |

| 2º | Carbon-Aware Scheduling | 8-31% (emissions + cost) | Bajo (API integration) | 1 semana |

| 3º | Model Quantization | 20-50% | Medio (validation needed) | 2-3 semanas |

| 4º | Zeus Framework | 15-75% | Medio (training reconfig) | 2-4 semanas |

| 5º | Liquid Cooling | 15-95% | Alto (CAPEX + install) | 3-6 meses |

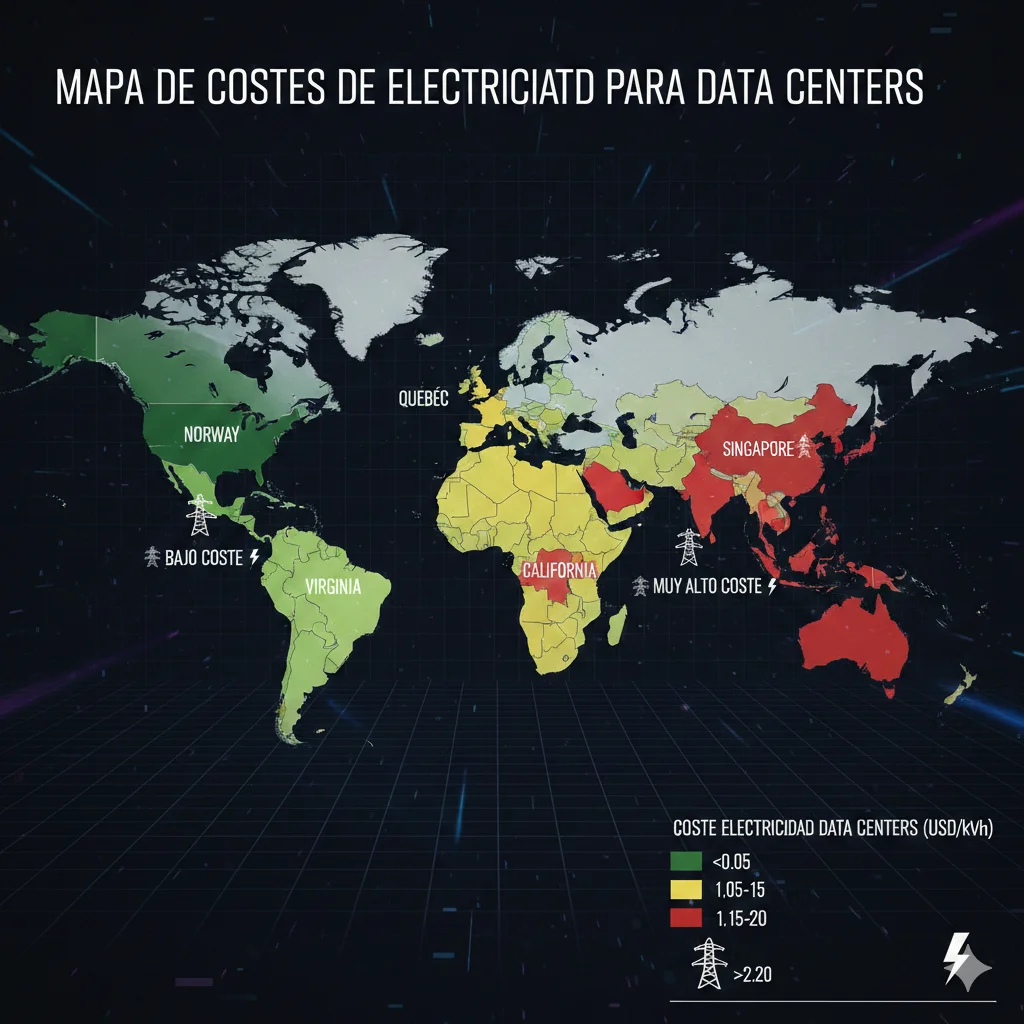

Análisis Geográfico: Las Regiones Más Caras (y Más Baratas) para Data Centers IA

4. Análisis Geográfico: Las Regiones Más Caras (y Más Baratas) para Data Centers IA

La ubicación de tu infraestructura puede significar diferencias del 40% en costes operativos. Veamos dónde deployar (y dónde NO) en 2025.

► Comparativa Regional: Top 10 Locations

| Región | Coste Eléctrico Promedio | PUE Típico | Intensidad Carbono | Disponibilidad Agua | Veredicto |

|---|---|---|---|---|---|

| Oregon (US) | Bajo (hidroeléctrica) | 1.12-1.15 | Muy Baja (90% renovable) | Alta | ✅ Excelente |

| Quebec (Canadá) | Muy Bajo | 1.08-1.10 | Mínima (99% hidro) | Muy Alta | ✅ Top Choice |

| Suecia/Nórdicos | Bajo | 1.06-1.08 | Muy Baja | Alta | ✅ Ideal Cooling |

| Frankfurt (Alemania) | Medio-Alto | 1.15-1.20 | Media (mix renovable/gas) | Media | ⚠️ OK Latency EU |

| Iowa (US) | Bajo-Medio | 1.12-1.18 | Media (wind + coal) | Alta | ⚠️ Good Value |

| N. Virginia (US) | Alto (+267% últimos 5 años) | 1.15-1.25 | Alta (gas/carbón) | Media-Baja | ❌ Costoso 2025+ |

| Ohio (US) | Alto (PJM impact) | 1.20-1.30 | Alta (carbón) | Media | ❌ Evitar |

| Singapur | Muy Alto | 1.25-1.35 | Alta (gas importado) | Crítica (moratorium) | ❌ Regulación Estricta |

| Texas (ERCOT) | Variable (volatilidad alta) | 1.18-1.25 | Media-Alta (gas/wind) | Baja (stress hídrico) | ⚠️ Grid Unreliable |

| California (US) | Muy Alto | 1.15-1.20 | Baja (solar/wind) | Crítica (sequía) | ⚠️ Regulación + Coste |

Fuentes: Hokstad Consulting, The New Stack

► Framework de Decisión: ¿Dónde Deployar?

La elección de región no es solo coste eléctrico. Considera estos 5 factores:

⚡ 1. Coste Eléctrico Total

No solo tarifa por kWh. Incluye:

- • Generación (commodity price)

- • Transmisión (grid costs - PJM alert)

- • Demand charges (peak usage penalties)

- • Renewable Energy Credits (RECs) si aplica

🌍 2. Intensidad Carbono

Si tienes compromisos ESG:

- • Quebec/Nórdicos: 99% renovable

- • Virginia/Ohio: 60-70% fósil

- • Impacto reputacional + compliance regulatorio

⏱️ 3. Latency Requirements

Inference real-time es sensible:

- • Training: latency no crítica → migra a regions baratas

- • Inference:

💧 4. Disponibilidad Agua

2/3 nuevos data centers en áreas water-stressed:

- • Singapur: moratorium nuevos data centers

- • California: regulación estricta uso agua

- • Nórdicos/Quebec: abundancia hídrica

💡 Estrategia Híbrida Recomendada para CTOs

No pongas todos los huevos en una canasta. Arquitectura multi-región óptima:

- ►Training compute (70% energía): Quebec/Nórdicos (bajo coste, renovable, no time-sensitive)

- ►Inference primaria (latency-critical): Cerca de usuarios principales (accept higher cost)

- ►Fallback/DR: Región diferente con electricity grid independiente

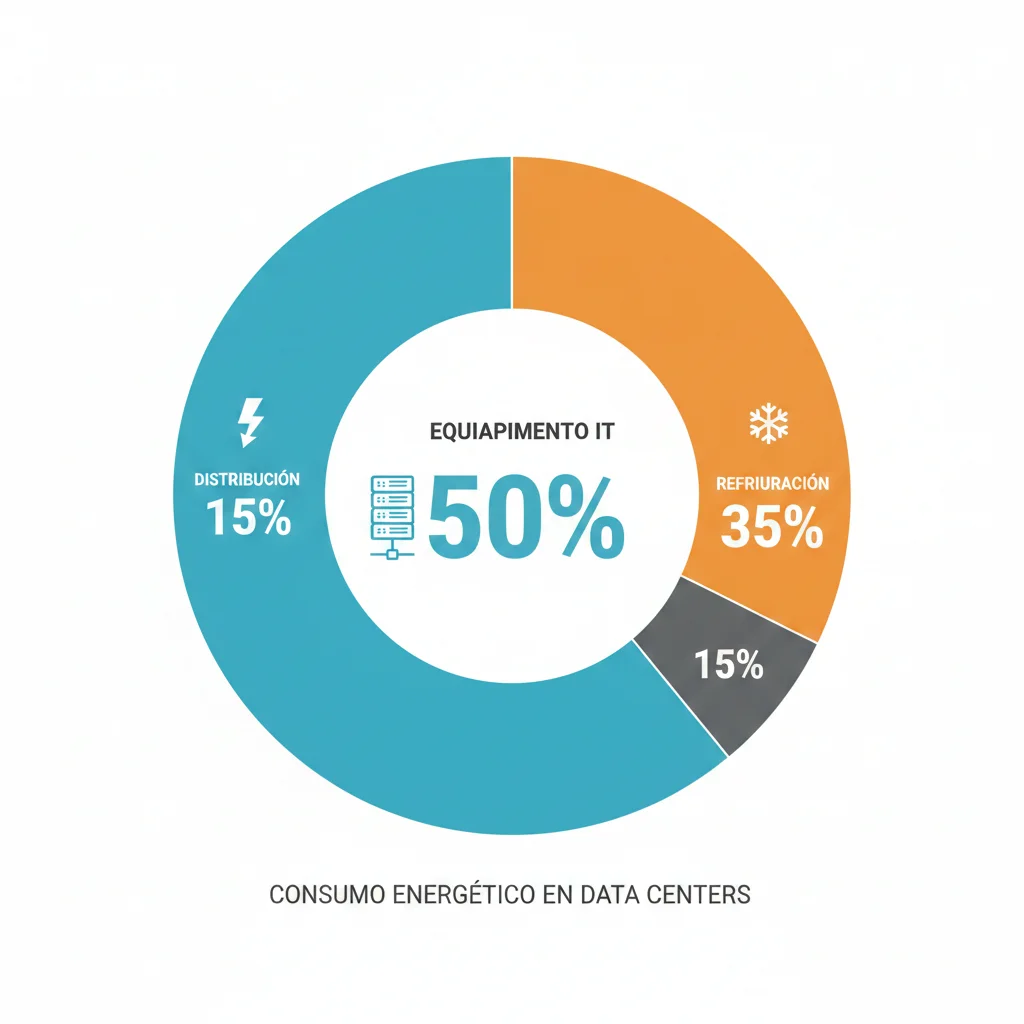

Breakdown de Consumo Energético: ¿Dónde Va Toda Esa Electricidad?

3. Breakdown de Consumo Energético: ¿Dónde Va Toda Esa Electricidad?

Para optimizar costes, necesitas entender exactamente dónde se consume la energía. Aquí está el desglose completo basado en investigación de McKinsey y análisis de hyperscalers.

► Distribución General Energía en Data Center

Consumo por Categoría

PUE: El Métrica Crítico

PUE (Power Usage Effectiveness) = Total Energy / IT Equipment Energy

Un PUE de 1.55 significa que por cada 1W usado en IT, se consumen 0.55W adicionales en cooling/distribución

► Training vs Inference: Diferencias Críticas

No todos los workloads de IA consumen energía igual. Hay diferencias dramáticas entre entrenar modelos y ejecutar inferencia:

| Métrica | Training | Inference |

|---|---|---|

| Consumo por Operación | MUY ALTO (100-1,000x inference) | Bajo (por query individual) |

| Frecuencia | Esporádico (días/semanas) | Continuo (millones queries/día) |

| GPU Utilization | Alta (80-95%) | Baja-Media (20-60%) |

| Latency Sensitivity | Baja (batch jobs) | MUY ALTA (real-time) |

| Oportunidades Optimización |

|

|

📊 Ejemplo: Training GPT-3 vs Inference

Según investigación de MIT Technology Review:

- ►Training GPT-3 (one-time): ~1,287 MWh de electricidad (equivalente a 120 hogares US durante un año)

- ►Inference (por prompt 100 palabras): 0.24 watt-hours (~0.5 ml agua)

- ►PERO: Con 100M queries/día, inference consume MÁS energía acumulada que training en 6-12 meses

► Consumo por Tipo de GPU: Roadmap 2025-2028

El hardware evoluciona rápido, y con ello el consumo energético. Aquí está el roadmap NVIDIA (dominante en IA):

| GPU Generation | TDP (Thermal Design Power) | Año Lanzamiento | Cooling Requerido |

|---|---|---|---|

| A100 (Ampere) | 400W | 2020 | Aire (tradicional) |

| H100 (Hopper) | 700W | 2022 | Aire optimizado |

| Blackwell B200 | 1,400W | 2024-2025 | Líquido (cold plate) |

| Rubin (proyección) | 3,600W | 2026-2027 | Líquido avanzado |

| Post-Feynman (especulativo) | 9,000-15,360W | 2028+ | Inmersión obligatoria |

Fuente: Tom's Hardware, NVIDIA datasheets

⚠️ Implicación para CTOs: Si planeas infraestructura para 2026-2028, el CAPEX de cooling se va a multiplicar por 3-5x. Los sistemas de aire tradicional NO serán suficientes para densidades >20 kW/rack.

El Impacto Real: Empresas, Residentes y Economías Locales

2. El Impacto Real: Empresas, Residentes y Economías Locales

Los números macro son impresionantes, pero ¿qué significa esto en la práctica para empresas y consumidores? Veamos casos concretos.

► Impacto en Empresas Tech: Presupuestos Explotando

Si operas un data center privado o tienes workloads significativos en cloud, ya estás sintiendo el impacto. En regiones PJM, los costes de capacidad que las utilities pasan a clientes comerciales han creado aumentos de facturación del 13-16% en 2025.

📉 Ejemplo Real: Startup SaaS en Virginia

Una startup de 50 empleados con 200 servidores GPU en Northern Virginia vio su factura eléctrica mensual pasar de:

Q1 2024

$45,000/mes

Q4 2025 (proyectado)

$72,000/mes

+60% aumento

Esto representa $324,000/año adicionales solo en electricidad, sin cambios en workload.

► Impacto en Consumidores Residenciales: Backlash Político

Quizás más sorprendente es el impacto en residentes que no tienen nada que ver con data centers. Según CNBC:

- •Maryland occidental: +$18/mes promedio en facturas residenciales

- •Ohio: +$16/mes proyectado

- •Baltimore: Un residente vio su tarifa saltar 20% de agosto a septiembre 2025, con +$32/mes adicionales

Esto ha creado un backlash político significativo. En las elecciones para gobernador de Virginia 2025, los costes eléctricos causados por data centers fueron un tema de campaña principal. New Jersey declaró una emergencia energética con promesas de regulación.

► Anatomía del Shock PJM: ¿Cómo Llegamos Aquí?

PJM Interconnection opera un "mercado de capacidad" donde los generadores de electricidad prometen capacidad futura. En 2024, el mercado funcionó relativamente normal con $2.2 mil millones totales. Pero en la subasta 2025 para entrega 2025-2026, algo cambió:

| Concepto | Subasta 2024 | Subasta 2025 | Cambio |

|---|---|---|---|

| Coste Total Capacidad | $2.2 mil millones | $14.7 mil millones | +568% |

| Atribuible a Data Centers | ~$500 millones | $9.3 mil millones | 63% del total |

| Impacto por Usuario | Mínimo | +$16-$32/mes | Significativo |

Fuente: IEEFA, Utility Dive

¿Por qué este salto dramático? Tres factores:

- Demanda proyectada explotó: Utilities reportaron compromisos de data centers que multiplicaron por 3-4x sus previsiones anteriores

- Oferta limitada: Nuevas plantas generadoras tardan 5-7 años en construirse; no hay forma de escalar tan rápido

- Mechanism del mercado: El mercado de capacidad PJM paga a TODOS los generadores al precio del generador marginal más caro necesario para cubrir demanda

🚨 ¿Tu grid es el siguiente? Monitorea estas señales de alerta temprana:

- • Anuncios de nuevos data centers masivos (>100 MW)

- • Utilities solicitando aumentos de tarifas extraordinarios

- • Proyecciones de crecimiento de demanda >5% anual

- • Retrasos en aprobaciones de nuevas plantas generadoras

Herramientas y Frameworks para Optimización Energética

6. Herramientas y Frameworks para Optimización Energética

Más allá de las estrategias, necesitas las herramientas correctas. Aquí está el stack completo de monitoring, optimization y carbon accounting.

► Herramientas Nativas Cloud Providers

AWS

- •Customer Carbon Footprint Tool - Tracking emisiones por servicio/región

- •AWS Compute Optimizer - Rightsizing recommendations (CPU → Graviton = 20% energy)

- •CloudWatch Metrics - Custom metrics para power monitoring

Google Cloud

- •Carbon Footprint Dashboard - Más granular que AWS, export BigQuery

- •Carbon-aware load balancing - Routing automático a low-carbon regions

- •Active Assist - ML-powered efficiency recommendations

Microsoft Azure

- •Emissions Impact Dashboard - Scope 1, 2, 3 tracking

- •Azure Advisor - Cost + sustainability recommendations

- •Sustainability Calculator - Pre-purchase carbon projections

► Open-Source Frameworks (Vendor-Neutral)

| Tool | Qué Hace | Savings Esperados | Compatibilidad |

|---|---|---|---|

| Zeus | Dynamic GPU power + batch size optimization training | 15-75% | PyTorch, TensorFlow, JAX |

| Perseus | Workload distribution optimization entre GPUs | 30% | NVIDIA GPUs, multi-node clusters |

| CodeCarbon | Python library tracking CO2 emissions code execution | Monitoring (no optimization) | Python (any framework) |

| ML CO2 Impact | Calculator estimando emissions training jobs | Planning tool | Web-based, cloud agnostic |

| Green Software Foundation Carbon-Aware SDK | APIs carbon intensity data global grids | 8-31% (scheduling) | REST API, multi-cloud |

► Ejemplo: Tracking Emissions con CodeCarbon

CodeCarbon es la forma más simple de empezar a medir el impacto ambiental de tu código. Instalación de 1 línea, integración de 3 líneas.

#!/usr/bin/env python3

"""

CodeCarbon Integration - Tracking CO2 Emissions

pip install codecarbon

"""

from codecarbon import EmissionsTracker

import time

import pandas as pd

# Inicializar tracker

tracker = EmissionsTracker(

project_name="my_ml_training",

output_dir="./emissions_logs",

country_iso_code="USA", # Para grid carbon intensity correcto

region="virginia" # us-east-1 AWS

)

# Start tracking

tracker.start()

# Tu código de training (simulado con sleep)

print("Training modelo... (esto consumirá energía)")

time.sleep(60) # Simula 1 min training

# Stop tracking

emissions_kg = tracker.stop()

print(f"\n🌍 EMISSIONS REPORT:")

print(f"CO2 emitted: {emissions_kg:.6f} kg")

print(f"Equivalent to: {emissions_kg * 2.5:.2f} km driven in average car")

print(f"📄 Detailed report guardado en: ./emissions_logs/emissions.csv")

# Ver detalles en CSV

df = pd.read_csv("./emissions_logs/emissions.csv")

print(df.to_string())

💡 Pro tip: Integra CodeCarbon en tu CI/CD pipeline. Falla el build si emissions > threshold. Ejemplo: if emissions_kg > 0.5: raise Exception("High emissions")

Predicciones 2026-2030 y Panorama Regulatorio

8. Predicciones 2026-2030 y Panorama Regulatorio

El problema va a empeorar antes de mejorar. Aquí están las proyecciones clave y las regulaciones que necesitas conocer.

► Proyecciones 2030: El Pico del Problema

📈 Consumo Energético

Global Data Centers

945 TWh

vs 415 TWh en 2024 (IEA)

Solo AI-Optimized Servers

432 TWh

vs 93 TWh en 2025 (Gartner)

💰 Impacto Costes

Aumento Facturas US Promedio

+8%

Carnegie Mellon projection

Hotspots (Virginia)

+25%

Residential bills 2030

🌍 Emissions Outlook (Warning)

Según Carnegie Mellon:

- ►Power sector emissions podrían aumentar 30% para 2030 (vs escenarios sin data center growth)

- ►Total: 275 millones metric tonnes CO2/año adicionales = emisiones anuales de Francia completo

- ►Esto CONTRADICE climate goals varios estados US (California, New York net-zero 2050)

► Panorama Regulatorio Global: Compliance Roadmap

Unión Europea

Energy Efficiency Directive (2024+)

- • Mandatory reporting: Energy + water consumption (27 países)

- • Target: Carbon-neutral data centers by 2030

- • Penalties: Fines hasta 4% revenue global (similar GDPR)

CSRD (Corporate Sustainability Reporting Directive)

- • Aplica: Large businesses (>250 employees o >€50M revenue)

- • Deadline: Reporting 2024 data en 2025

- • Scope: Emisiones Scope 1, 2, 3 + water + biodiversity

China

PUE Standards (2025+)

- • Requirement: PUE

Singapur

Data Center Moratorium (Levantado Parcialmente 2025)

- • 2019-2025: Moratorium total nuevos data centers (water scarcity)

- • 2025 update: Allow nuevos SI cumplen PUE 1.3 + liquid cooling mandatory

- • Water limit: Water Usage Effectiveness (WUE)

Estados Unidos (State-Level)

Oregon HB (Propuesta 2025)

- • Proposal: Data centers pagan grid strain infrastructure costs

- • Mechanism: Fee por MW capacity (pasado a operators, no residential)

Virginia/Texas/Ohio

- • Fast-tracking: Power plant approvals acelerados (lobby tech companies)

- • Renewable mandates: Varios estados requiring % renewable sourcing

New Jersey Emergency Declaration

- • 2025: Governor declared energy emergency (PJM impact)

- • Action: Regulatory review data center electricity allocation

| Jurisdicción | Key Requirement | Deadline | Penalty No-Compliance |

|---|---|---|---|

| EU (CSRD) | Sustainability reporting Scope 1-3 | 2025 (2024 data) | Fines hasta 4% revenue |

| China | PUE | ||

| Singapur | PUE 1.3 + liquid cooling | 2025 (lift moratorium) | No permits granted |

| California | Water usage disclosure | 2026 | Public disclosure (reputational) |

Renewable Energy e Iniciativas de Sostenibilidad en Data Centers

7. Renewable Energy e Iniciativas de Sostenibilidad en Data Centers

Más allá de optimizar consumo, la fuente de energía importa. Los hyperscalers están apostando miles de millones en renovables y nuclear. ¿Qué puedes hacer tú?

► Compromisos Hyperscalers: La Carrera por 100% Renovable

| Compañía | Compromiso | Timeline | Inversión 2025 | Status Actual |

|---|---|---|---|---|

| Microsoft | 100% renewable electricity match | 2025 | $120B (AI infrastructure) | 835 MW Three Mile Island (nuclear 2028) |

| 24/7 carbon-free energy ALL data centers | 2030 | $75B | 64% renewable 2024, 500 MW SMRs (Kairos) | |

| Amazon | 100% renewable by 2025 (operations match) | 2025 | $52B (AWS CapEx) | 1.9 GW nuclear (Talen Energy) |

| Meta | 100% renewable energy for operations | 2030 | $72B | Louisiana $10B renewable data center |

Fuentes: Corporate sustainability reports, Trellis.net

⚠️ Reality check: "100% renewable" a menudo significa "net-zero annual matching", NO energía renovable 24/7 real-time. Google es el único comprometido con verdadero 24/7 carbon-free.

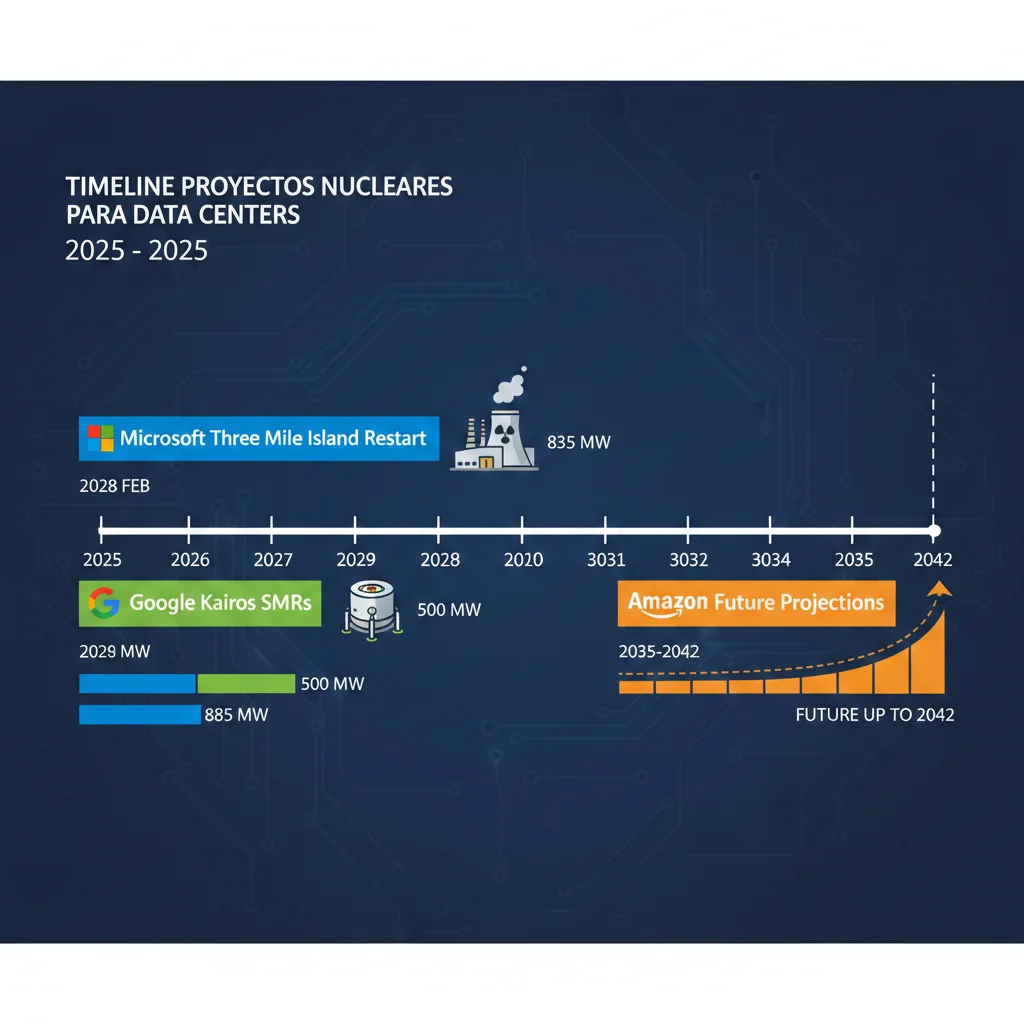

► Nuclear Power: El Comeback Impulsado por IA

¿Por qué nuclear? IA necesita baseload 24/7. Solar/wind son intermittent (solo generan cuando hay sol/viento). Baterías no escalan para GW-scale data centers. Nuclear es la única fuente carbon-free que puede proveer gigawatts consistentemente.

⚛️ Nuclear Tradicional (Restarts)

Microsoft - Three Mile Island

- • Capacidad: 835 MW

- • Timeline: 2028 restart

- • Contrato: 20 años PPA

- • Inversión Constellation: ~$1.6B renovación

Amazon - Talen Energy (Susquehanna)

- • Capacidad: hasta 1.9 GW

- • Locación: Pennsylvania (PJM grid)

- • Término: hasta 2042

🔬 Small Modular Reactors (SMRs)

Google - Kairos Power

- • Capacidad: 500 MW total (multiple units)

- • Timeline: Primera unidad 2030

- • Tech: Molten salt-cooled reactor

Ventajas SMRs vs Traditional:

- • Menor footprint: hasta 300 MWe vs 1,000+ MWe

- • Passive safety: no human intervention shutdown

- • Faster deployment: modular construction

- • Co-location: posible on-site data center

💡 ¿Por qué esto importa para tu negocio?

Para 2028-2030, hyperscalers tendrán acceso a electricidad nuclear barata y 24/7. Si compites con ellos usando grid mix estándar (60% fósil), tendrás:

- • Costes 15-25% más altos (nuclear PPA fijo vs volatile grid)

- • Carbon footprint 70% más alto (regulatory + reputational risk)

- • Recruitment disadvantage (top AI talent quiere trabajar en empresas net-zero)

► PPAs para Enterprises: ¿Cuándo Tiene Sentido?

PPA (Power Purchase Agreement) = contrato long-term (típicamente 10-20 años) para comprar electricidad directamente de generador renovable (solar farm, wind farm).

✅ Cuándo un PPA Tiene Sentido (Decision Tree):

Demanda Energética Consistente >10 MW

PPAs requieren commitment mínimo ~50-100 GWh/año. Enterprise con 1,000+ servidores típicamente califica.

Horizonte Largo Plazo (>5 años)

PPA lock-in 10-20 años. Solo viable si tienes certeza de operaciones long-term en región.

Compromisos ESG Board-Level

Necesitas net-zero 2030/2035 para cumplir compromisos públicos, investors, regulatory.

Electricity Price Hedge

Grid prices volátiles (PJM case). PPA fija coste, protege contra spikes.

ROI Típico PPA:

- • Savings: 15-25% vs grid projected costs over contract life

- • Payback: Immediate (fixed rate day 1)

- • Risk: Si demand cae, stuck paying minimum commitment

⚠️ Alternativa para empresas

🎯 Conclusión y Plan de Acción 90 Días para CTOs

La crisis energética de data centers IA NO es un problema futuro—está pasando ahora. Si esperas a Q1 2026 cuando los costes PJM peguen completamente o cuando Gartner's 40% constraint prediction se materialice, será demasiado tarde para actuar sin disruption masivo.

📋 Tu Roadmap de 90 Días (Action Plan)

Semanas 1-2: Assessment & Baseline

Entender tu situación actual

- ►Audit consumo actual (kWh/mes, breakdown IT vs cooling vs distribución)

- ►Calcular PUE baseline (si no lo tienes, asume 1.55 industry avg)

- ►Identificar workload types (training vs inference, latency requirements)

- ►Check grid risk (¿estás en PJM, ERCOT u otra grid vulnerable?)

Semanas 3-4: Quick Wins (Low-Hanging Fruit)

ROI positivo en 1-2 meses

- ►Implementar power capping GPUs (12-15% savings, 1 semana effort)

- ►Carbon-aware scheduling batch jobs (8-31% emissions + 10-20% cost)

- ►Off-peak scheduling non-urgent workloads (15-25% cost reduction)

- ►Temperature optimization cooling (raise 1°F = 4-5% savings)

Mes 2: Medium-Term Optimization

6-12 meses ROI

- ►Zeus/Perseus framework para training jobs (15-75% energy reduction)

- ►Model quantization deployment models (20-50% inference power)

- ►Regional migration analysis (si multi-cloud, move training a Quebec/Nórdicos)

- ►Cooling upgrade feasibility (si >20 kW/rack, liquid cooling ROI study)

Mes 3+: Strategic Initiatives

18-36 meses ROI pero critical long-term

- ►Renewable energy PPA negotiation (si >10 MW demand)

- ►Cooling infrastructure upgrade (liquid/immersion para Blackwell/Rubin roadmap)

- ►Hardware procurement strategy (next-gen GPUs planning)

- ►Regulatory compliance program (CSRD, PUE mandates)

🎓 Key Takeaways - Lo Que Debes Recordar

La Crisis Es AHORA

PJM costs 500% up, 40% constraint 2027. No esperes a Q1 2026.

Quick Wins Existen

30% wasted energy + 12-15% power capping = savings sin CAPEX.

Long-Term Strategy Required

Nuclear 2028+, pero gap 2025-2028 requiere interim solutions.

¿Necesitas Ayuda Implementando Este Plan?

Como AWS ML Specialty + DevOps Professional certified, he ayudado a empresas como MasterSuiteAI a reducir sus costes de infraestructura hasta un 45% mientras escalan a 1M+ requests diarios. Ofrezco:

- ✓Auditoría técnica infraestructura IA (energy consumption, PUE, workload analysis)

- ✓Roadmap 90 días con ROI calculations específicas

- ✓Implementación hands-on (power capping, carbon-aware scheduling, quantization)

Primera consulta gratuita de 30 minutos. Sin compromiso.

Sobre el Autor

Abdessamad Ammi es CEO de BCloud Consulting y experto senior en IA Generativa y Cloud Infrastructure. Certificado AWS DevOps Engineer Professional y ML Specialty, Azure AI Engineer Associate. Ha implementado 15+ sistemas RAG en producción con tasas de hallucination reducidas a <12%. Especializado en MLOps, LangChain y arquitecturas cloud production-ready.