¿Qué Es el EU AI Act? La Primera Regulación Comprehensiva de IA del Mundo

EU AI Act 2025: La Crisis de Compliance de €35 Millones

El 2 de agosto de 2025 entra en vigor el compliance obligatorio para modelos GPAI. ¿Está tu empresa preparada para multas de hasta €35 millones?

Si eres CTO, VP Engineering o Head of ML en una empresa que usa IA, probablemente has oído hablar del EU AI Act. Pero aquí está el problema: el 88% de las organizaciones usan IA regularmente (McKinsey 2025), pero solo el 25% tienen programas de gobernanza IA implementados.

Eso significa que 3 de cada 4 empresas están operando sistemas IA sin el framework de compliance necesario para cumplir con la regulación más completa del mundo sobre inteligencia artificial.

El EU AI Act no es GDPR 2.0. Es mucho más complejo. Con 5 deadlines diferentes entre febrero 2025 y agosto 2027, 4 niveles de riesgo, requisitos técnicos detallados, y multas que pueden destruir tu empresa, la mayoría de CTOs están completamente perdidos.

El problema se intensifica cuando descubres que:

- ✕Los standards armonizados están retrasados – originalmente previstos para agosto 2025, ahora no llegarán hasta finales de 2026 (20+ meses de retraso)

- ✕45 empresas líderes europeas pidieron una pausa de 2 años en julio 2025 – y la Comisión Europea la rechazó rotundamente

- ✕Las guidance oficiales se retrasaron – el documento esperado para mayo 2025 llegó tarde, dejando a las empresas sin claridad justo antes del deadline crítico

- ✕Solo el 12% de organizaciones tienen datos verdaderamente "AI-ready" (McKinsey 2025), crítico para gobernanza de datos y transparencia

Y aquí está la verdadera bomba: el deadline del 2 de agosto de 2025 para modelos GPAI (General Purpose AI) está ACTIVO AHORA. Si tu empresa usa o desarrolla modelos LLM como GPT-4, Claude, Llama, Mistral, o cualquier modelo foundation, tienes obligaciones de compliance inmediatas.

🎯 Lo Que Aprenderás en Esta Guía

- ✓Los 5 deadlines críticos 2025-2027 y cuál aplica a tu empresa específicamente

- ✓Decision tree completo para clasificar tus sistemas IA (high-risk vs low-risk)

- ✓Templates reales descargables: Annex IV documentation, copyright policy GPAI, training data summary

- ✓Calculator interactivo de multas (input: tu revenue → output: penalty máxima €35M)

- ✓Cómo integrar EU AI Act en tu MLOps pipeline existente (MLflow, LangSmith, Weights & Biases)

- ✓Roadmap de 90 días para compliance completo (sin necesitar $1.4B como EY)

Esta no es una guía legal genérica. Es una guía técnica de implementación escrita por ingenieros para ingenieros. Con código Python/JavaScript, arquitecturas de sistemas, integration workflows, y templates reales que puedes usar HOY.

Empecemos por entender qué diablos es exactamente el EU AI Act y por qué debería importarte.

1. ¿Qué Es el EU AI Act? La Primera Regulación Comprehensiva de IA del Mundo

El Reglamento de Inteligencia Artificial de la Unión Europea (EU AI Act) es la primera legislación comprehensiva del mundo sobre IA. Aprobado en marzo 2024 y en vigor desde agosto 2024, establece un marco regulatorio basado en riesgo para sistemas de inteligencia artificial operando en el mercado europeo.

📌 Dato clave: A diferencia de GDPR (que regula datos personales), el EU AI Act regula los sistemas IA completos – desde su diseño y entrenamiento hasta su deployment y monitorización post-market. Es mucho más amplio y técnicamente específico.

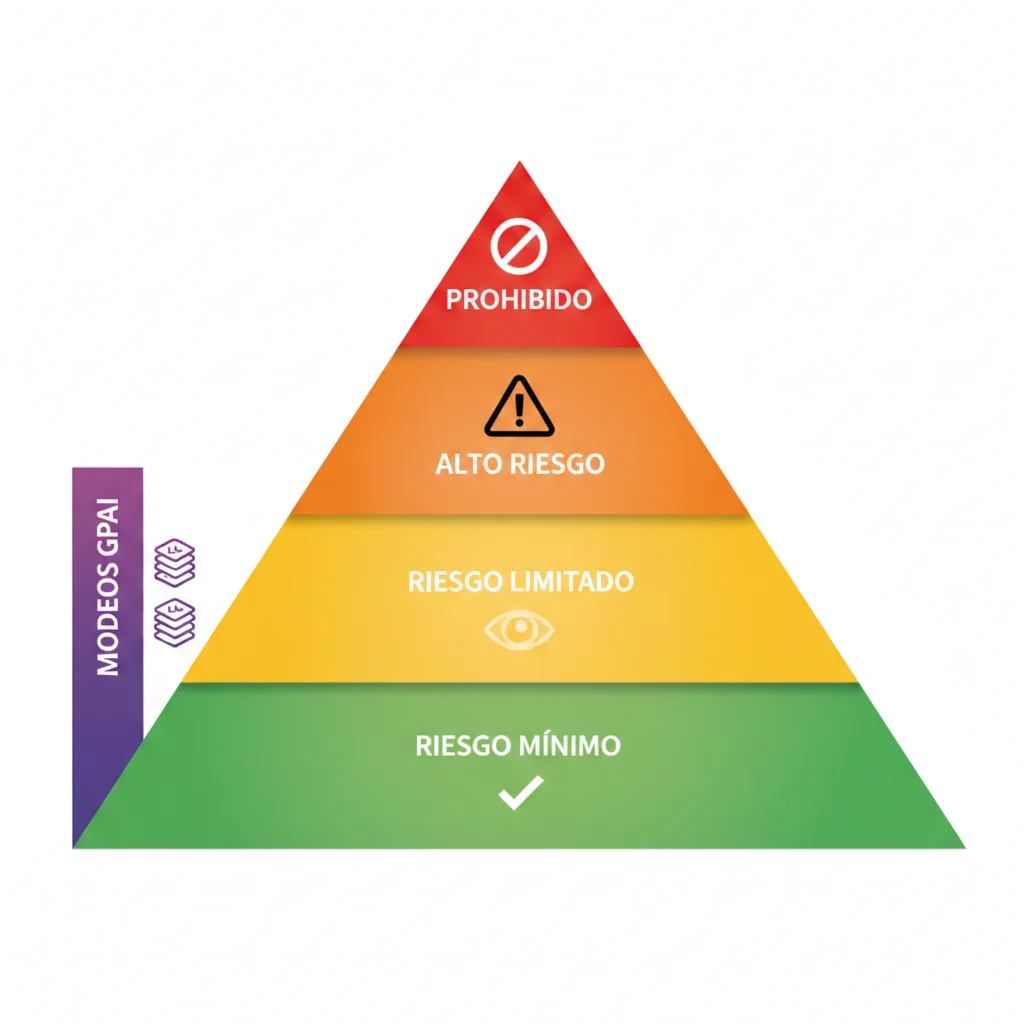

► Sistema de Clasificación por Riesgo: 4 Niveles

El corazón del EU AI Act es su enfoque basado en riesgo. Dependiendo del nivel de riesgo que tu sistema IA represente para derechos fundamentales, salud, seguridad o medio ambiente, tendrás obligaciones diferentes:

| Nivel Riesgo | Ejemplos | Obligaciones | Deadline |

|---|---|---|---|

| Prohibido | Manipulación subliminal, social scoring, explotación vulnerabilidades, biometría tiempo real pública | PROHIBICIÓN TOTAL (€35M multa) | Feb 2 2025 ✅ ACTIVO |

| Alto Riesgo | IA recruiting, scoring crediticio, diagnóstico médico, law enforcement, educación | Annex IV docs, conformity assessment, CE marking, EU database, QMS, risk mgmt | Ago 2 2026 |

| Riesgo Limitado | Chatbots customer service, generadores contenido, deepfakes | Transparencia (disclosure que es IA, watermarking generado-IA) | Ago 2 2026 |

| Riesgo Mínimo | Filtros spam, videojuegos IA, sistemas recomendación productos | Sin obligaciones legales (voluntary Code of Conduct) | N/A |

⚡ Categoría Especial: Modelos GPAI (General Purpose AI)

Además de los 4 niveles de riesgo, existe una categoría horizontal que afecta a modelos foundation/LLMs: los modelos GPAI. Estos son modelos entrenados con grandes cantidades de datos usando self-supervision a escala, capaces de competencia en tareas amplias (GPT-4, Claude, Llama 3, Mistral, Gemini, etc).

Threshold técnico: Modelos con capacidad computacional entrenamiento ≥ 1023 FLOPs (floating point operations). Si además superan 1025 FLOPs, se consideran "riesgo sistémico" con obligaciones adicionales.

🚨 CRÍTICO: El deadline para modelos GPAI es 2 agosto 2025 (6 meses antes que high-risk systems). Si tu empresa usa OpenAI API, Anthropic Claude, o entrena modelos propios foundation, esto te afecta YA.

► ¿Por Qué Importa? Las Multas Más Altas de la Historia Tech

El EU AI Act tiene el sistema de multas más severo jamás implementado en regulación tecnológica, superando incluso a GDPR:

⚠️ Comparación GDPR vs EU AI Act

GDPR máximo: €20M o 4% revenue global.

EU AI Act máximo: €35M o 7% revenue global (75% más alto).

Para una startup SaaS con €50M revenue, una violación de prácticas prohibidas = €3.5M de multa (7%). Eso puede destruir tu empresa.

► Scope Extraterritorial: ¿Te Afecta Aunque No Estés en EU?

Como GDPR, el EU AI Act tiene aplicación extraterritorial. Te afecta si:

- 1Tu empresa está establecida en la UE y desarrolla/despliega sistemas IA (obvio)

- 2Ofreces sistemas IA en el mercado EU (SaaS con clientes europeos, APIs accesibles desde EU)

- 3El output de tu sistema IA se usa en la UE (aunque el sistema esté en US/Asia)

En otras palabras: si tienes clientes europeos usando tu plataforma IA, estás dentro del scope. No hay escape geográfico.

Compliance GPAI (Agosto 2025 ACTIVO): Los 4 Requirements Obligatorios

5. Compliance GPAI (Agosto 2025 ACTIVO): Los 4 Requirements Obligatorios

DEADLINE ACTIVO: 2 Agosto 2025

Si eres provider de modelos GPAI (entrenas LLMs/foundation models ≥1023 FLOPs) o deployer usando APIs GPAI, tienes obligaciones ACTIVAS desde agosto 2 2025.

Esto afecta: OpenAI, Anthropic, Google, Meta, Mistral, Cohere, y CUALQUIER empresa entrenando modelos foundation propios. Deadline es 6 MESES ANTES que high-risk systems (ago 2026).

► ¿Qué Es Un Modelo GPAI? (Definición Técnica)

El EU AI Act define General Purpose AI (GPAI) model como:

Definición Oficial (Artículo 3):

"Un modelo IA entrenado con grandes cantidades de datos usando auto-supervisión a escala, que muestra competencia significativa en un amplio rango de tareas distintivas sin necesidad de fine-tuning específico para cada tarea, y que puede ser integrado en una variedad de downstream sistemas o aplicaciones."

En español simple: Modelos foundation/LLMs grandes como GPT-4, Claude, Llama 3, Mistral Large, Gemini Pro – entrenados a escala masiva, capaces de hacer múltiples tareas (text generation, code, analysis, translation, etc) sin reentrenamiento específico.

► Threshold Técnico: 10^23 FLOPs (¿Tu Modelo Califica?)

No todos los modelos IA son GPAI. Hay un threshold cuantitativo:

Criterio Computacional (Commission Guidelines July 2025):

Standard GPAI Model:

Capacidad computacional entrenamiento ≥ 1023 FLOPs (floating-point operations)

Obligaciones: 4 core requirements (technical docs, training data summary, copyright policy, downstream provider info)

Systemic Risk GPAI Model:

Capacidad computacional entrenamiento ≥ 1025 FLOPs (100x threshold standard)

Obligaciones: 4 core requirements + obligaciones adicionales (model evaluation, adversarial testing, systemic risk mitigation, serious incidents reporting, cybersecurity)

Ejemplos de modelos que califican GPAI:

✅ Definitivamente GPAI (≥1023 FLOPs):

- • GPT-4, GPT-4 Turbo, GPT-4o (OpenAI)

- • Claude 3 Opus, Claude 3.5 Sonnet (Anthropic)

- • Gemini Pro, Gemini Ultra (Google)

- • Llama 3 70B, Llama 3.1 405B (Meta)

- • Mistral Large, Mixtral 8x22B (Mistral AI)

- • Command R+, Command (Cohere)

❌ Probablemente NO GPAI (

- • Modelos pequeños (

⚠️ Zona Gris: Open-Source Models

El EU AI Act tiene exemptions limitadas para open-source GPAI models. Si tu modelo es:

- • Released bajo licencia open-source (MIT, Apache 2.0, etc)

- • Weights y training code públicamente disponibles

- • NO ofrecido como servicio comercial (solo descarga research/personal)

→ Exemption de algunas obligaciones (technical docs simplificadas), PERO copyright policy + training data summary SIGUEN SIENDO OBLIGATORIOS (Artículo 53). No hay escape completo.

► Los 4 Core Requirements GPAI (Artículo 53)

Todo provider de modelos GPAI debe cumplir estos 4 requirements ANTES de agosto 2 2025:

📄Requirement #1: Technical Documentation

Debes mantener documentación técnica up-to-date describiendo tu modelo GPAI.

Qué incluir (mínimo):

- •Model architecture: Tipo (transformer, diffusion, etc), número parámetros, layers, attention heads

- •Training process: Datasets usados, pre-processing, augmentation, training duration, compute resources (GPUs/TPUs), hyperparameters

- •Evaluation results: Benchmarks (MMLU, HumanEval, etc), accuracy/perplexity metrics, known limitations

- •Intended use: Purpose, target users, restrictions

- •Capabilities & limitations: What it can/cannot do, failure modes, bias testing results

💡 Template Recomendado:

Usa formato Model Card (Mitchell et al. 2019) + extensiones EU AI Act. BCloud ofrece template completo GPAI technical docs con ejemplo filled-in (Claude 3.5 Sonnet ficticio).

📊Requirement #2: Training Data Summary (Public)

Debes publicar un summary de los training datasets usando el template oficial de la Comisión Europea.

Template Commission (released July 2025) - campos obligatorios:

- •Data sources: Origen datos (web scraping, datasets públicos, synthetic, propietario)

- •Volume: Tamaño (tokens, documentos, imágenes, horas audio, etc)

- •Data curation: Filtering, deduplication, quality checks

- •Copyright compliance: Cómo respetaste opt-outs (robots.txt, etc) – link a copyright policy

- •Piracy sites exclusion: Confirmación que excluiste sitios en EU piracy list

🚨 CRÍTICO: Este summary debe ser PÚBLICO

No es internal documentation. Debe publicarse en tu website o via EU AI database (cuando esté operacional). Objetivo: transparencia para rightsholders verificar si su contenido fue usado.

{

"model_name": "MiLLM-70B",

"training_data_summary": {

"total_tokens": "2.5 trillion tokens",

"data_sources": [

{

"source_type": "Web scraping (Common Crawl)",

"volume": "1.8 trillion tokens",

"timeframe": "2018-2024",

"copyright_compliance": "Respetados opt-outs via robots.txt. Ver copyright policy: https://example.com/copyright"

},

{

"source_type": "Public datasets (Wikipedia, Stack Overflow, arXiv)",

"volume": "400 billion tokens",

"licenses": "CC-BY-SA, MIT, Apache 2.0"

},

{

"source_type": "Synthetic data (self-generated)",

"volume": "300 billion tokens",

"generation_method": "Paraphrasing + data augmentation"

}

],

"data_curation": "Deduplication (exact + fuzzy), quality filtering (perplexity thresholds), toxicity filtering (Perspective API), PII removal",

"piracy_sites_exclusion": "Verified exclusion of sites listed in EU piracy database (last updated: 2025-07-01)",

"languages": "80+ languages (English 40%, Spanish 8%, French 6%, German 5%, other 41%)",

"last_updated": "2025-07-15"

}

}

©️Requirement #3: Copyright Compliance Policy

Debes tener una política pública describiendo cómo cumples con el DSM Directive (EU Copyright Directive) respecto a Text and Data Mining (TDM).

Qué debe cubrir tu policy:

- 1.Respect for opt-outs: Cómo respetas la "reservation of rights" (DSM Directive Artículo 4) – típicamente via

robots.txto machine-readable protocols - 2.TDM exception compliance: Solo scraping permitido bajo Artículo 3-4 DSM (research purposes o commercial con opt-in)

- 3.Piracy sites exclusion: Proceso para excluir sitios en EU piracy database

- 4.Rightsholder contact: Email/form para copyright holders solicitar removal de sus obras

- 5.Update frequency: Cada cuánto auditas compliance (recomendado: quarterly)

⚠️ Riesgo Legal Alto

Copyright compliance es CRÍTICO. Rightsholders pueden demandar por copyright infringement ADEMÁS de EU AI Act violation. Penalty: €15M o 3% revenue (Tier 2) + damages copyright lawsuit separado. Ejemplo real: NY Times vs OpenAI lawsuit (ongoing, billions claimed).

💡 Copyright Policy Template (fragmento):

1. Respeto por Opt-Outs:

"Respetamos las reservations of rights expresadas por rightsholders via robots.txt (User-agent: GPTBot, CCBot, etc). Antes de cada training run, auditamos robots.txt de todos los dominios scrapeados. Dominios con 'Disallow' son excluidos automáticamente."

2. Exclusión Sitios Piratería:

"Mantenemos blacklist actualizada con sitios listados en EU piracy database. Cross-check mensual. Last update: [fecha]."

3. Contacto Rightsholders:

"Copyright holders pueden solicitar removal: copyright@example.com. Procesamos requests en 30 días. Si obra fue usada en training, ofrecemos opt-out para modelos futuros + documentation removal."

🔗Requirement #4: Downstream Provider Information

Debes proveer documentación suficiente para que downstream developers (users de tu modelo GPAI) puedan cumplir SUS obligaciones EU AI Act.

Qué información proveer:

- •API capabilities & limitations: Qué puede hacer tu modelo, qué NO puede hacer, edge cases

- •Known risks: Hallucinations, bias, toxicity, security vulnerabilities

- •Mitigation measures: Recommendations para deployers (content filtering, human review thresholds, monitoring)

- •Use case restrictions: Prohibited uses (e.g., "not for medical diagnosis", "not for hiring decisions without human review")

- •Performance benchmarks: Accuracy metrics, evaluation results (para que deployers puedan verificar si model es fit-for-purpose su use case)

💡 Ejemplo Real: OpenAI Model Spec

OpenAI publicó "Model Spec" (Mayo 2024) describiendo behavior guidelines GPT-4: objectives, rules, defaults. Esto es UN COMPONENTE de downstream provider info (falta agregar: evaluation metrics, limitations detalladas, prohibited uses específicos según EU AI Act).

► Grace Period Confuso: Modelos Pre-Market vs Post-Market

Aquí viene una de las partes más confusas del EU AI Act:

| Tipo Modelo GPAI | Deadline Compliance | Justificación |

|---|---|---|

| Modelos NUEVOS lanzados post Ago 2 2025 | INMEDIATO (al lanzar) | Sin grace period. Compliance obligatorio ANTES de market release. |

| Modelos EXISTENTES ya en market antes Ago 2 2025 | Ago 2 2027 (grace period 2 años) | Permiten tiempo para retrofitting compliance (docs, copyright policy, training summary). |

| Open-source models (research/personal only) | Ago 2027 (exemptions parciales) | Copyright + training summary SIGUEN siendo mandatory. Technical docs simplificadas. |

⚠️ Interpretación Conservadora Recomendada

Aunque modelos pre-market tienen grace period hasta 2027, RECOMIENDO compliance proactive antes. Por qué:

- • Rightsholders pueden demandar copyright infringement AHORA (independent of EU AI Act deadline)

- • Customer contracts B2B pueden requerir compliance antes 2027 (enterprise customers exigiendo warranties)

- • First-mover advantage: demostrar compliance early = competitive differentiator

- • Evitas rush 2026-2027 (resources compliance escasos, backlog consultoría)

Conclusión + Next Steps: Tu Roadmap de 90 Días

8. Conclusión + Next Steps: Tu Roadmap de 90 Días

Llegamos al final de esta guía masiva. Si leíste hasta aquí, ya sabes más sobre EU AI Act compliance que 95% de CTOs en Europa.

Pero conocimiento sin acción no vale nada. Aquí está tu roadmap práctico de 90 días para llegar a compliance:

MES 1: Discovery & Assessment (Semanas 1-4)

Entender QUÉ tienes y QUÉ obligaciones aplican

Semana 1-2: AI Inventory

- • Lista TODOS los sistemas IA en tu empresa (production + staging + prototypes)

- • Para cada sistema: nombre, purpose, users, data sources, deployment status

- • Tool: Spreadsheet simple suficiente (o script Python scanning codebase imports: langchain, openai, anthropic, tensorflow, etc)

- • Output: Inventory completo (típicamente 5-30 sistemas para SaaS mid-size)

Semana 3: Risk Classification

- • Usa decision tree Sección 4 para CADA sistema en inventory

- • Marca sistemas: PROHIBIDO / HIGH-RISK / LIMITED-RISK / MINIMAL-RISK / GPAI

- • Si 40% unclear (appliedAI stat) → consult legal/technical advisor €2k-5k

- • Output: Classified inventory (e.g., "3 high-risk, 1 GPAI, 12 minimal-risk")

Semana 4: Deadline Mapping

- • Para cada sistema: identificar deadlines aplicables (Feb 2025 prohibited, Ago 2025 GPAI, Ago 2026 high-risk)

- • Prioritize urgency: GPAI (6 meses) > high-risk (18 meses) > limited-risk (18 meses)

- • Create Gantt chart personalizado con milestones

- • Output: Timeline compliance por sistema (visual roadmap)

MES 2: Documentation & Quick Wins (Semanas 5-8)

Crear documentación técnica + eliminar violations obvias

Semana 5-6: GPAI Compliance (si applica)

- • Copyright policy: Draft policy respecting robots.txt + DSM Directive (usar template BCloud)

- • Training data summary: Fill Commission template con datasets info

- • Technical docs: Model card con architecture, training process, evaluation

- • Downstream provider info: API docs con capabilities, limitations, prohibited uses

- • Output: 4 documentos GPAI compliant → publicar antes Ago 2 2025

Semana 7-8: High-Risk Annex IV (start)

- • Para sistemas high-risk: start Annex IV documentation (9 secciones)

- • Usar template BCloud + ejemplo RAG (Sección 6)

- • Priorizar sections críticas: architecture (#2), risk management (#6), data governance (#7)

- • Output: Draft 50% Annex IV (iterarás en Mes 3)

Quick Win: Prohibited Practices Audit

- • Usar checklist Sección 7 para auditar las 8 categorías prohibidas

- • Si encuentras violación → remediate INMEDIATAMENTE (modify o descontinue system)

- • Document decisión reasoning (por si audit futuro)

- • Output: Zero prohibited practices violations (prerequisito básico)

MES 3: Governance & Prep Conformity (Semanas 9-12)

Setup frameworks permanentes + preparar assessment

Semana 9-10: AI Governance Framework

- • QMS basics: Policies (AI acceptable use, deployment approval, incident response)

- • Roles & responsibilities: Designar AI Officer (puede ser fractional/external), RACI matrix

- • Tools setup: Policy docs (Confluence/Notion), risk register (Jira/Airtable), monitoring dashboards (Grafana/LangSmith)

- • Output: Operational governance framework (no necesita ser perfecto, iterate)

Semana 11: Conformity Assessment Strategy (High-Risk)

- • Research notified bodies EU (lista oficial en EU AI Act website cuando publiquen)

- • Criteria selección: expertise sector, experience AI systems, timeline, pricing

- • Pre-engagement informal (muchos notified bodies ofrecen pre-assessment consultation €5k-10k)

- • Output: Shortlist 2-3 notified bodies + contact iniciado

Semana 12: Gap Analysis & Roadmap

- • Compare estado actual vs requirements completos (Annex IV 9 sections, GPAI 4 requirements, governance 7 elements)

- • Identificar gaps específicos (e.g., "falta bias testing data governance", "monitoring post-market no setup")

- • Priorizar por: urgency deadline + complexity + cost

- • Output: Gap analysis report + roadmap Mes 4-12 hasta Ago 2026 (high-risk deadline)

⏰ ¿No Tienes 90 Días? Fast-Track de 30 Días (Mínimo Viable Compliance)

Si estás ultra-presionado por deadlines, aquí está la versión SPRINT:

Semana 1 (40 horas):

- • AI inventory (16h) + risk classification (16h) + deadline mapping (8h)

- • Output: Classified inventory + timeline visual

Semana 2 (40 horas):

- • Prohibited practices audit (8h) + remediation si needed (variable)

- • GPAI compliance documents draft (32h usando templates BCloud)

- • Output: Zero violations + GPAI docs 80% complete

Semana 3 (40 horas):

- • High-risk Annex IV draft sections críticas (40h: architecture, risk mgmt, data governance)

- • Output: Annex IV 30% complete (suficiente para notified body pre-assessment)

Semana 4 (40 horas):

- • Governance basics (policies 16h, roles 8h, monitoring setup 16h)

- • Gap analysis + roadmap remaining work (8h)

- • Output: Operational governance + plan Mes 2-12

⚠️ Disclaimer: 30-day sprint NO es compliance completo, es minimum viable para demostrar good-faith effort. Usalo solo si deadline GPAI Ago 2025 está encima y necesitas algo urgente. Ideal: 90 días con proper implementation.

► Por Qué BCloud Para Tu Compliance EU AI Act

He implementado compliance EU AI Act para empresas SaaS desde que la regulación fue aprobada (Marzo 2024). Aquí está por qué clientes eligen BCloud:

🛠️Technical + Legal Integration

No soy solo legal consultant. Tengo AWS ML Specialty + DevOps Professional certifications. Entiendo tu stack técnico (LangChain, RAG, MLOps pipelines, vector DBs). Hablo tu idioma.

⚡Implementation, No Solo Assessment

Big 4 consultancies cobran €200k+ por assessment reports que no implementan nada. BCloud: implemento código, setup monitoring, creo docs técnicas, integro en tu MLOps pipeline existente.

💰Pricing SME-Friendly

€18k-50k compliance completo (vs €200k+ Big 4). Fractional services: AI Officer retainer €2k-5k/mes (vs €120k/year full-time hire). Pay-as-you-go milestones.

📦Templates & Tools Reales

Esta guía tiene templates descargables (Annex IV, copyright policy GPAI, risk classification decision tree, penalty calculator). Uso en proyectos reales, no theory.

🎯 Servicios BCloud EU AI Act Compliance

Compliance Roadmap Assessment

- ✓AI inventory completo

- ✓Risk classification todos sistemas

- ✓Deadline mapping personalizado

- ✓Gap analysis + action plan

- ✓Report 20-30 páginas

High-Risk Documentation Service

- ✓Todo en Starter +

- ✓Annex IV completo (9 secciones)

- ✓FRIA (risk assessment)

- ✓Conformity assessment prep

- ✓Notified body pre-engagement

Full Compliance Program

- ✓Todo en Professional +

- ✓GPAI compliance (4 requirements)

- ✓AI Governance Framework (QMS)

- ✓MLOps integration (automated compliance)

- ✓CE marking support

- ✓6 meses post-implementation support

Solo 3 proyectos nuevos/mes. Reserva tu plaza antes de que sea tarde.

🎁 Bonus: Recursos Descargables Gratuitos

Descarga estos templates y tools AHORA (sin email requerido, acceso directo):

🚀 Ready to Start?

El deadline GPAI es Agosto 2 2025 (6 meses). High-risk deadline Agosto 2 2026 (18 meses).

Cuanto antes empieces, más tiempo tienes para iterar y refinar. No esperes al rush de última hora.

Última actualización: 25 Diciembre 2025

¿Preguntas sobre tu caso específico? Email: sam@bcloud.consulting

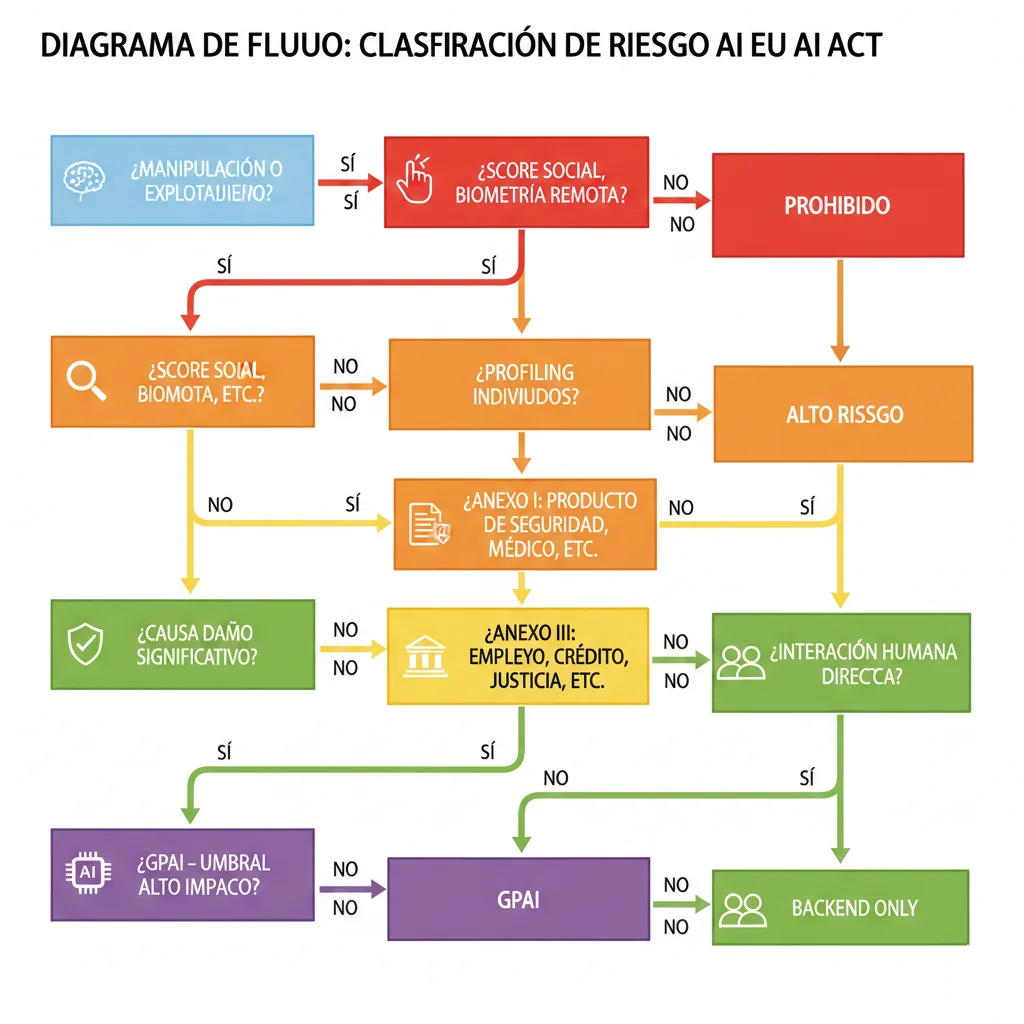

Decision Tree Clasificación de Riesgo: ¿Tu Sistema IA Es High-Risk?

4. Decision Tree Clasificación de Riesgo: ¿Tu Sistema IA Es High-Risk?

Esta es probablemente la pregunta más crítica para tu empresa: ¿Mi sistema IA es high-risk según el EU AI Act?

Y aquí está el problema masivo: el estudio appliedAI analizó 106 sistemas IA empresariales reales y encontró que 40% tienen clasificación UNCLEAR – no está claro si son high-risk o low-risk.

Por Qué Esto Importa CRÍTICO

Si clasificas incorrectamente tu sistema IA como low-risk cuando en realidad es high-risk, tendrás:

- • ❌ NO conformity assessment → sin CE marking → prohibition to market en EU

- • ❌ Missing technical documentation → €15M multa (Tier 2)

- • ❌ No QMS, no risk management → violations adicionales apiladas

- • ❌ Retrospective compliance = 10x más caro que proactive

► Los 4 Niveles de Riesgo (Explicados)

PROHIBIDO (Unacceptable Risk)

Sistemas IA que representan amenaza clara a derechos fundamentales, seguridad, o valores democráticos. Prohibition TOTAL de deployment en EU.

8 Categorías Prohibidas (Artículo 5):

ALTO RIESGO (High-Risk)

Sistemas IA que pueden causar impacto adverso significativo en salud, seguridad, derechos fundamentales, medio ambiente, democracia, o rule of law.

3 Pathways para High-Risk (Artículo 6):

RIESGO LIMITADO (Limited Risk)

Sistemas IA con riesgo específico de manipulación o falta de transparencia, pero no impacto adverso grave en derechos fundamentales.

Obligación: TRANSPARENCIA (Artículos 50-52):

RIESGO MÍNIMO (Minimal Risk)

Mayoría de sistemas IA caen aquí: sin obligaciones legales bajo EU AI Act. Voluntary Code of Conduct recomendado, pero no mandatory.

Ejemplos:

► Decision Tree Interactivo: Clasifica Tu Sistema IA en 8 Preguntas

Aquí está el decision tree completo. Responde honestamente estas 8 preguntas para tu sistema IA:

🌲 EU AI Act Risk Classification Decision Tree

1¿Tu sistema IA usa manipulación subliminal, explota vulnerabilidades, hace social scoring, o categorización biométrica sensible?

2¿Tu sistema IA hace profiling de personas naturales?

3¿Tu IA está embedded en un producto regulado por Union harmonisation legislation (Annex I)?

Annex I incluye: medical devices, toys, machinery, vehicles, aviation, lifts, pressure equipment, marine equipment, etc.

4¿Tu sistema IA cae en alguna de las 8 áreas de Annex III?

5Si respondiste SÍ a pregunta 4: ¿El uso de IA representa "significant harm" a salud, seguridad, o derechos fundamentales?

Artículo 6(3) permite excepciones si el uso específico NO causa significant harm (e.g., IA solo para spell-check en recruiting platform)

6¿Usas o desarrollas un modelo GPAI (General Purpose AI)?

GPAI = modelo foundation/LLM entrenado con ≥1023 FLOPs, capaz de competencia en tareas amplias (GPT-4, Claude, Llama 3, Mistral, Gemini, etc)

7¿Tu sistema IA interactúa directamente con personas (chatbot, virtual assistant, emotion recognition)?

8Si llegaste aquí: ¿Tu sistema IA es puramente back-end, sin interacción humana directa, sin decisiones críticas sobre personas?

¿Necesitas ayuda clasificando tus sistemas IA?

Solicitar Risk Assessment Gratuito (30 min) →► Casos de Uso Comunes: Clasificación Práctica

Veamos ejemplos reales de sistemas IA que construyen empresas SaaS/tech y cómo clasifican:

| Sistema IA | Use Case | Clasificación | Justificación |

|---|---|---|---|

| RAG Chatbot HR Recruiting | Screening CVs, scoring candidates, ranking aplicantes | HIGH-RISK | Annex III #4 Employment + toma decisiones impactando hiring |

| RAG Chatbot Customer Support | Responder preguntas productos, troubleshooting técnico | MINIMAL RISK | No Annex III, no decisiones críticas (salvo que haga credit decisions) |

| Content Generator (blog posts, ads) | Crear contenido marketing automatizado | LIMITED RISK | Genera contenido → watermarking obligation (Artículo 50) |

| Credit Scoring Algorithm | Evaluar creditworthiness para préstamos | HIGH-RISK | Annex III #5 Essential Services (acceso crédito) |

| Product Recommender (e-commerce) | Sugerir productos basado en historial compras | MINIMAL RISK | No Annex III, no profiling sensible, decisión comercial light |

| Medical Diagnosis Assistant | IA sugiere diagnósticos a doctores | HIGH-RISK | Annex I Medical Device + safety component salud |

| Deepfake Detector | Identificar imágenes/videos manipulados | LIMITED RISK | Procesa biometría pero para detection (no categorization) → transparency req |

| Social Scoring App | Puntuar usuarios basado en comportamiento social (estilo China) | PROHIBIDO | Artículo 5(1)(c) – prohibition TOTAL social scoring |

| Spam Filter (email) | Clasificar emails como spam/no-spam | MINIMAL RISK | Back-end, no decisiones sobre personas, low impact |

| LangGraph Multi-Agent (autonomous) | Agentes IA tomando decisiones autónomas en employment workflow | HIGH-RISK | Si workflow es Annex III (employment/credit/law enforcement) → high-risk |

💡 Regla práctica: Si tu sistema IA toma (o asiste en) decisiones que afectan employment, crédito, educación, salud, o law enforcement → muy probablemente HIGH-RISK. Si solo es backend automation o customer service informativo → probablemente LOW-RISK. Cuando dudes, consulta a un experto (€2k-5k legal assessment es MUCHO más barato que €15M multa por clasificación incorrecta).

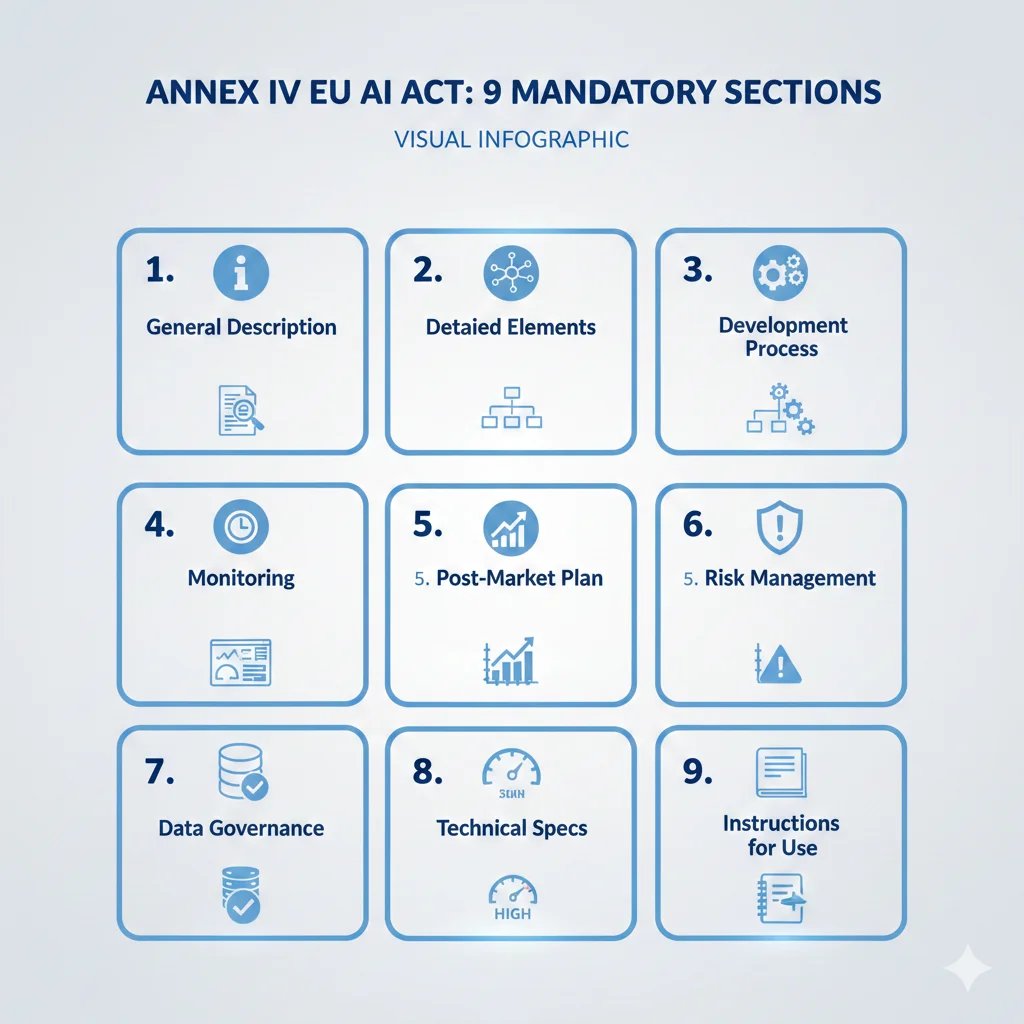

High-Risk AI Technical Documentation (Annex IV): La Guía Completa

6. High-Risk AI Technical Documentation (Annex IV): La Guía Completa

Si tu sistema IA es high-risk (clasificado vía decision tree sección 4), necesitas preparar technical documentation completa según Annex IV del EU AI Act.

Esto NO es documentación ligera tipo README. Es un dossier técnico exhaustivo que será revisado por notified bodies durante conformity assessment. Piensa en ello como el equivalente IA del "clinical trial documentation" de medical devices.

Sin Annex IV = Sin CE Marking = Sin Mercado EU

La technical documentation Annex IV es prerequisito absoluto para conformity assessment. Sin ella, notified body NO puede certificar tu sistema. Sin CE marking, prohibition to market en EU. Multa adicional: €15M o 3% revenue (Tier 2).

► Las 9 Secciones de Annex IV (Breakdown Completo)

Annex IV especifica 9 secciones obligatorias. Aquí está cada una con qué incluir EXACTAMENTE:

1General Description del AI System

Información básica identificando el sistema:

- • Nombre comercial + versión

- • Intended purpose (qué problema resuelve, para quién)

- • Provider identity (empresa, dirección, contacto)

- • Target users (perfiles personas que usarán el sistema)

- • Hardware requirements (si applica: GPUs, RAM, storage)

- • Conformity assessment procedure seguida (self-assessment o third-party)

2Detailed Description AI System Elements

Arquitectura técnica profunda:

- • Architecture diagrams: Visual representation componentes (data pipeline, model, inference, monitoring)

- • Algorithms & techniques: ML approach (supervised, unsupervised, reinforcement, neural network type, etc)

- • Dependencies: External APIs, libraries, frameworks (LangChain, OpenAI API, Pinecone, etc)

- • Computational resources: Training compute (GPUs, TPUs, cloud instances), inference compute

- • Pre-processing & post-processing: Data transformations, normalization, output formatting

- • Version control: Model registry approach (MLflow, Weights&Biases, manual)

3Development Process & Training

Cómo fue desarrollado y entrenado el sistema:

- • Training datasets: Sources, size, composition, licensing

- • Training methodology: Hyperparameters, optimization algorithm, epochs, batch size, learning rate

- • Validation approach: Train/val/test split ratios, cross-validation strategy

- • Feature engineering: Features selected/engineered, transformations

- • Development tools: IDEs, notebooks, experiment tracking (MLflow, W&B)

- • Versioning & reproducibility: Seed fixing, determinism measures, Git commits

4Monitoring, Functioning, Control

Cómo se monitorea y controla el sistema en producción:

- • Human oversight mechanisms: Dashboards, alerts, manual review workflows, override capabilities

- • Logging & tracing: Qué events se logean (requests, predictions, errors, user feedback)

- • Metrics tracked: Performance (latency, throughput), accuracy (precision, recall), business (user satisfaction)

- • Thresholds & alerts: Qué triggers alertas (accuracy drop, high error rate, bias drift)

- • Incident response: Proceso cuando algo falla (escalation, rollback procedure)

5Post-Market Monitoring Plan

Plan para continuous monitoring post-deployment:

- • Monitoring scope: Qué se monitorea (performance drift, data drift, concept drift, fairness metrics)

- • Frequency: Continuous (real-time dashboards), periodic (weekly/monthly reports)

- • Update procedures: Cuándo re-entrenar modelo, process approval updates

- • Serious incidents definition: Qué constituye incident reportable (Artículo 73: malfunctions causing death, serious injury, fundamental rights violations)

- • Reporting timeline: Notificación autoridades en cuánto tiempo (serious incidents: immediate)

6Risk Management System

FRIA (Fundamental Rights Impact Assessment) + risk mitigation:

- • Risk identification: Enumerar risks específicos (bias, hallucinations, security vulnerabilities, privacy leaks)

- • Risk assessment: Likelihood × Impact score para cada risk

- • Mitigation measures: Qué implementaste para reducir cada risk (bias: demographic parity testing; hallucinations: confidence thresholds)

- • Residual risk: Risks que quedan DESPUÉS de mitigation (acceptance criteria)

- • Iterative process: Cómo actualizas risk assessment (quarterly reviews, post-incidents)

7Data Governance

Training, validation, testing data quality:

- • Data quality criteria: Completeness, accuracy, consistency, timeliness

- • Bias testing: Demographic representation analysis, fairness metrics (demographic parity, equalized odds)

- • Data sources: Origin verification, licensing compliance

- • Data curation: Cleaning, filtering, augmentation processes

- • Representativeness: Coverage de edge cases, minority groups, geographic diversity

- • Update procedures: Cuándo actualizar datasets, retraining triggers

8Technical Specifications Accuracy, Robustness, Cybersecurity

Performance benchmarks y security measures:

- • Accuracy metrics: Precision, recall, F1, AUC-ROC, RMSE, perplexity (según tipo modelo)

- • Robustness testing: Adversarial examples testing, input perturbations, stress testing

- • Cybersecurity measures: Input validation, API rate limiting, authentication, encryption at rest/transit

- • Privacy protections: PII detection, anonymization, differential privacy (si applica)

- • Target performance levels: Minimum acceptable accuracy, maximum latency, uptime SLA

9Instructions for Use (Users)

Documentación para deployers/users del sistema:

- • Intended use description: Para qué sirve, qué problemas resuelve

- • Capabilities & limitations: Qué puede hacer WELL, qué NO puede hacer

- • Installation & setup: Technical requirements, deployment guide

- • Usage guidelines: Best practices, dos/don'ts

- • Human oversight requirements: Cuándo/cómo debe haber revisión humana

- • Known issues & troubleshooting: Common errors, workarounds

► Template REAL: Annex IV Completo para Sistema RAG

Aquí está un ejemplo FILLED-IN de Annex IV para un sistema RAG real (basado en arquitectura BCloud típica):

📋 Annex IV Example: RAG Customer Support System

SECTION 1: General Description

Nombre comercial: CustomSupportAI v2.1

Intended purpose: Asistir agentes customer support respondiendo preguntas técnicas sobre productos SaaS mediante retrieval-augmented generation

Provider: Acme SaaS Inc., 123 Tech Street, Madrid, España | contact@acme.com

Target users: Customer support agents (B2B SaaS company internal)

Hardware: Cloud-hosted (AWS), no special client requirements (web browser)

Conformity assessment: Internal (Annex VII) + post-market monitoring

SECTION 2: Detailed Architecture

Architecture: RAG pipeline con LangChain orchestration

Components:

- • User query → FastAPI endpoint

- • Query embedding → OpenAI text-embedding-3-large

- • Vector search → Pinecone index (1536 dimensions, cosine similarity)

- • Top-k retrieval (k=5 documents, threshold similarity >0.7)

- • Context + query → GPT-4 Turbo via OpenAI API

- • Response generation → streaming to frontend

- • Logging → LangSmith tracing + CloudWatch

Dependencies: LangChain 0.1.x, OpenAI API, Pinecone SDK, FastAPI, Pydantic

Compute: AWS ECS Fargate (4 vCPU, 8GB RAM) + OpenAI serverless

Ver architecture diagram: docs/architecture-v2.1.pdf

SECTION 3: Development & Training

Training data: 12,500 documentos knowledge base (product docs, troubleshooting guides, FAQs) → chunked 500 tokens, embedded con OpenAI

No model training: Sistema usa GPT-4 pre-trained via API (no fine-tuning local)

Development: Jupyter notebooks (prototyping) → production FastAPI app, Git version control

Validation: 200 test queries con golden answers, precision@5 = 0.89, recall@5 = 0.84

SECTION 4: Monitoring & Control

Human oversight: Dashboard Grafana mostrando queries/min, latency p95, user thumbs-up/down rate. Agents pueden override response, flagging incorrect answers triggers review.

Logging: LangSmith traces (query, retrieved docs, LLM response, latency), CloudWatch metrics (API errors, throughput)

Alerts: PagerDuty si error rate >5%, latency p95 >3s, thumbs-down rate >20%

SECTION 5: Post-Market Monitoring

Monitoring: Weekly reports (precision, user satisfaction), monthly knowledge base updates triggering re-embedding

Serious incidents: Definidos como: responses con info médica/legal incorrecta causando customer harm, data leakage PII, systemic failures >1 hour. Reporting: immediate notification CTO + legal, autoridades si fundamental rights impact.

SECTION 6: Risk Management

Identified risks:

| Risk | Likelihood | Impact | Mitigation |

|---|---|---|---|

| Hallucinations | Medium | Medium | Confidence threshold >0.7, disclaimer "AI-generated, verify critical info" |

| PII leakage | Low | High | PII detection pre-embedding, anonymization, access controls |

| Outdated info | High | Low | Monthly knowledge base updates, versioning docs |

SECTION 7: Data Governance

Data quality: Knowledge base curated quarterly, reviewed by product experts, version controlled Git

Bias testing: N/A (no demographic decisions). Language bias tested (English 90%, Spanish 10% docs - matches customer base)

Representativeness: Covers 95%+ common customer queries (validated via historical ticket analysis)

SECTION 8: Performance Specifications

Accuracy: Precision@5 = 0.89, Recall@5 = 0.84 (test set 200 queries)

Latency: p50 = 1.2s, p95 = 2.8s, p99 = 4.1s

Uptime: Target 99.5% (measured monthly)

Security: HTTPS only, API key authentication, rate limiting 100 req/min per agent, no PII storage

SECTION 9: Instructions for Use

Intended use: Assist customer support agents ONLY. Not for: medical advice, legal advice, autonomous decisions.

Limitations: May hallucinate details. Cannot access real-time data. Requires human verification for critical info.

Setup: Web browser, login credentials, training (2-hour onboarding session).

Human oversight: Agents must review responses before sending to customers. Thumbs-down if incorrect triggers review queue.

💾 Descargar Template Completo

BCloud ofrece template Annex IV editable (Word + Markdown) con este ejemplo completo + campos blank para tu sistema.

La Pregunta de €35 Millones: Calculator de Multas + Risk Assessment

3. La Pregunta de €35 Millones: Calculator de Multas + Risk Assessment

Hablemos de dinero real. El EU AI Act tiene el sistema de multas más brutal de cualquier regulación tecnológica en historia. Para poner esto en perspectiva, vamos a comparar con GDPR:

| Regulación | Multa Máxima Tier 1 | Violación Típica | Ejemplo Real |

|---|---|---|---|

| GDPR | €20M o 4% revenue | Data breach, insufficient basis legal processing | Meta: €390M (2023), Amazon: €746M (2021) |

| EU AI Act | €35M o 7% revenue | Prohibited practices, manipulación subliminal, social scoring | No cases yet (regulation nueva), Clearview AI multada $33M en US por facial scraping similar |

Para una empresa con €100M revenue anual, una violación tier 1 EU AI Act = €7M multa (7%)

vs GDPR = €4M multa (4%). Diferencia: €3M adicionales.

► Sistema de 3 Tiers de Multas (Artículo 99 + 101)

El EU AI Act define 3 niveles de penalties dependiendo de la severidad de la violación:

Violaciones que activan Tier 1:

- • Non-compliance con prohibited practices (Artículo 5)

- • Violación requirements sistemas high-risk (datos, governance, human oversight, accuracy)

- • Non-compliance obligaciones modelos GPAI riesgo sistémico (≥1025 FLOPs)

Violaciones que activan Tier 2:

- • Non-compliance con obligaciones providers (Artículo 16 - QMS, docs, transparency)

- • Violación obligaciones authorised representatives (Artículo 22)

- • Non-compliance obligaciones importers/distributors (Artículos 23-24)

- • Violación requirements GPAI models (Artículo 53 - copyright, training data, docs)

Violaciones que activan Tier 3:

- • Suministro de información incorrecta, incompleta o misleading a autoridades notified bodies durante compliance assessment

- • Failure to cooperate con requests de información de autoridades competentes

📌 Nota SMEs: Para pequeñas y medianas empresas (SMEs), la multa es el menor entre el porcentaje de turnover O el monto absoluto. Ejemplo: startup €5M revenue, violación Tier 1 → 7% = €350k (vs €35M para enterprise). Protección SME parcial, pero €350k sigue siendo destructivo para una startup seed stage.

► Calculator Interactivo: ¿Cuál Es Tu Máxima Exposure?

Vamos a hacer esto práctico. Usa este calculator para entender tu riesgo financiero real:

🧮 EU AI Act Penalty Calculator

Ingresa tu facturación anual global en euros

⚠️ Real-World Impact: Casos GDPR Como Analogía

Aunque el EU AI Act es nuevo (no hay cases de multas aún), podemos mirar GDPR para entender enforcement real:

- • Meta (2023): €390M por processing Instagram data de menores sin consent adecuado

- • Amazon (2021): €746M por targeted advertising violando GDPR (la multa GDPR más alta en historia)

- • Google (2019): €50M por lack of transparency en data processing + insufficient legal basis

- • WhatsApp (2021): €225M por insufficient transparency sobre data sharing con Facebook

Lección: Las autoridades EU NO dudan en imponer multas gigantes. El EU AI Act tendrá enforcement igual de agresivo.

► Mitigación de Riesgo: Cómo Reducir Tu Exposure

La buena noticia: existen estrategias para reducir tu riesgo de penalties demostrando good-faith compliance efforts:

1. AI Regulatory Sandbox Participation

Cada Member State EU debe establecer un regulatory sandbox (Artículo 57) antes de agosto 2026. Participar te da: guidance regulatorio, supervised testing environment, y NO administrative fines durante sandbox period. Para SMEs es GRATIS.

2. AI Pact Voluntary Commitment

La Comisión Europea lanzó el AI Pact (iniciativa voluntary) donde empresas se comprometen a compliance anticipado. Aunque no evita multas legalmente, demuestra good faith y puede influir en severity de penalties si hay violación accidental.

3. Pre-Compliance Audit Documentado

Contratar audit externo (legal + técnico) ANTES de deadlines y documentar findings + remediation plan. Si hay violación posterior, puedes demostrar diligence razonable, potencialmente reduciendo multa (las autoridades tienen discreción en severity).

4. Early Conformity Assessment (High-Risk)

Para sistemas high-risk, NO esperar hasta agosto 2026. Engage notified body en 2025 para pre-assessment. Costes adelantados, pero evitas rush último minuto + demuestras proactive compliance (factor mitigante si hay issues).

💰 Cost-Benefit Reality Check

Coste de Compliance (proactive):

- • Legal assessment: €15k-40k

- • Technical documentation: €20k-60k

- • Conformity assessment: €30k-100k

- • Implementation (QMS, monitoring): €50k-150k

- TOTAL: €115k-€350k

Coste de Non-Compliance (reactive):

- • Multa Tier 1 (ejemplo €100M revenue): €7M

- • Legal defense costs: €200k-€500k

- • Reputational damage: incalculable

- • Prohibition to market EU: revenue loss

- TOTAL: €7M+ (20x compliance)

Conclusión: Invertir €115k-350k en compliance proactive es 20-60 veces más barato que arriesgar una multa €7M. Y eso sin contar daño reputacional, customer churn, o prohibition de operar en mercado EU (27 países, 450M consumidores).

Prácticas Prohibidas (Multas €35M): Audit Checklist

7. Prácticas Prohibidas (Multas €35M): Audit Checklist

El deadline para prácticas prohibidas fue 2 febrero 2025 – ya pasó. Enforcement está ACTIVO AHORA.

Si tu empresa está violando (incluso sin saberlo) cualquiera de las 8 categorías prohibidas, estás sujeto a multa inmediata de €35M o 7% revenue global.

Para una empresa con €200M revenue, violación de prácticas prohibidas = €14M multa.

Eso puede destruir una scale-up completa.

► Las 8 Categorías Prohibidas (Checklist)

Usa este checklist para auditar tu portfolio de sistemas IA:

Técnicas que distorsionan materialmente el comportamiento de una persona causando o siendo razonablemente probable causar daño físico o psicológico.

Ejemplos PROHIBIDOS:

- • Dark patterns IA extremos (manipulación compras mediante timing voice prompts subliminal)

- • Audio frequencies fuera rango audible humano pero procesadas subconscientemente

- • IA que explota vulnerabilidades psicológicas (addiction patterns, fear triggers)

✅ Acción: Audita user interfaces IA-driven buscando manipulation tactics. Consulta psicólogos UX si usas behavioral nudging agresivo.

IA que explota vulnerabilidades de personas debido a edad, discapacidad física/mental, o situación socioeconómica específica.

Ejemplos PROHIBIDOS:

- • Chatbots targeting niños para compras in-app sin parental consent

- • IA detectando ancianos con demencia para venderles productos innecesarios

- • Sistemas explotando personas en financial distress (predatory lending IA)

✅ Acción: Si target audience incluye menores, elderly, o economically vulnerable → legal review URGENTE. Age gates + parental controls obligatorios.

Evaluación o clasificación de personas basada en comportamiento social o características personales predichas/reales, resultando en tratamiento perjudicial en contextos NO relacionados al comportamiento original.

Ejemplo PROHIBIDO (China-style):

- • Score ciudadanos 0-1000 basado en comportamiento (compras, social media, asociaciones)

- • Restrictions según score: negar travel, educación, housing, employment

- • EU AI Act PROHÍBE totalmente este modelo

✅ Probablemente OK: Credit scoring para lending (contexto relacionado), employee performance reviews (dentro empresa), customer loyalty tiers (commercial relationship). La clave: uso debe estar relacionado al contexto original.

Evaluar riesgo de que una persona cometa delito basado SOLO en profiling o características personales (sin behavioral evidence).

Ejemplo PROHIBIDO (Minority Report-style):

- • IA predice "esta persona cometerá crimen" basado solo en: edad, raza, código postal, asociaciones

- • Pre-emptive arrests o surveillance targeting sin evidencia comportamental

✅ Permitido con restrictions: IA analizando CCTV para detectar comportamiento sospechoso ACTUAL (e.g., persona merodeando entry point 30 min). La clave: debe haber behavior evidence, no solo demographics.

Crear o expandir facial recognition databases mediante scraping indiscriminado de imágenes faciales de internet o CCTV footage.

Caso Real: Clearview AI

- • Clearview AI scrapeó 3B+ facial images de internet (Facebook, Instagram, websites públicos)

- • Vendió database a law enforcement, corporaciones

- • Multada $33M en US, prohibida operar en EU, Australia, Canada

- • EU AI Act haría esto ilegal con €35M penalty

✅ Acción: Si tienes facial recognition system → audita source de training data. Si incluye scraping público sin consent explícito → RIESGO MÁXIMO, descontinuar.

IA que infiere emociones de personas en contexto de trabajo o educación.

Ejemplos PROHIBIDOS:

- • Cámaras en oficina detectando "felicidad" empleados → performance reviews

- • Software monitoring facial expressions estudiantes durante exams → detección cheating vía "nerviosismo"

- • HR software scoring candidates entrevistas por microexpressions

⚠️ Excepciones limitadas: Medical/safety purposes OK (e.g., detectar fatigue conductor truck para prevenir accidentes). Pero workplace/education general → PROHIBIDO.

Inferir raza, opiniones políticas, trade union membership, orientación sexual, creencias religiosas de una persona a partir de datos biométricos.

Ejemplos PROHIBIDOS:

- • IA prediciendo orientación sexual de facial features (como controversial Stanford study 2017)

- • Sistema inferring political ideology de tone of voice, facial structure

- • Categorización racial automática para targeting ads/decisions

✅ Acción: Si tu IA procesa biometría (facial recognition, voice analysis, gait recognition) → asegura que NO infiere atributos sensibles. Document explícitamente prohibited inferences.

Identificación remota biométrica en tiempo real en espacios públicamente accesibles (excepciones MUY limitadas law enforcement).

Ejemplo PROHIBIDO (para empresas privadas):

- • Retail store con cámaras facial recognition identificando shoppers en tiempo real

- • Smart city deployment identificando ciudadanos en calles públicas

- • Event venue usando facial recognition para entry sin explicit opt-in

⚠️ Law enforcement exceptions: Police puede usar en casos específicos (missing children, terrorist threats, serious crime suspects) CON judicial authorization previa. Pero empresas privadas → PROHIBIDO totalmente.

🚨 Acción Inmediata Requerida

Si marcaste CUALQUIER checkbox arriba como "posible violación":

- 1. STOP deployment inmediatamente (si ya en producción)

- 2. Legal assessment URGENTE (consult abogado especializado EU AI Act + privacy)

- 3. Document decisión (si decides que NO es violación, documenta reasoning por escrito para defense futura)

- 4. Remediation plan (si es violación: modify system para eliminar prohibited practice, o descontinue completely)

- 5. Timeline: Actúa en DÍAS, no semanas (enforcement activo desde Feb 2 2025)

Timeline Crítico: 5 Deadlines Que Harán o Romperán Tu Negocio

2. Timeline Crítico: 5 Deadlines Que Harán o Romperán Tu Negocio

Una de las mayores confusiones del EU AI Act es su implementación escalonada. No es "un deadline y listo". Son 5 fechas críticas entre febrero 2025 y agosto 2027, cada una activando diferentes obligaciones.

🔥 El Problema del Timeline Múltiple

"La parte más compleja del AI Act es el timing" – CIO.com enterprise interviews.

"Las empresas expresaron incertidumbre sobre cómo cumplir con las reglas" – Reuters (vía BSR report).

45 empresas líderes europeas enviaron una carta abierta en julio 2025 pidiendo una pausa de 2 años. La Comisión Europea la rechazó – el timeline no cambiará.

► Deadline #1: 2 Febrero 2025 – Prácticas Prohibidas ✅ ACTIVO

DEADLINE PASADO – Enforcement Activo AHORA

Si tu empresa está violando prácticas prohibidas (Artículo 5), estás sujeto a multas de €35M o 7% revenue global desde el 2 de febrero 2025. Las autoridades nacionales pueden investigar y sancionar desde esta fecha.

¿Qué sistemas están prohibidos? (Artículo 5 – 8 categorías):

- 1. Manipulación subliminal: Técnicas que distorsionan comportamiento causando daño físico/psicológico (ej: dark patterns IA extremos)

- 2. Explotación vulnerabilidades: IA que explota edad, discapacidad, situación socioeconómica (ej: targeting predatorio)

- 3. Social scoring: Evaluación comportamiento social para tratamiento perjudicial (ej: China-style credit social)

- 4. Evaluación riesgo crimen predictivo: Basado solo en profiling/características personales (ej: Minority Report-style pre-crime)

- 5. Facial scraping: Recolección indiscriminada imágenes faciales de internet/CCTV (ej: Clearview AI – multada $33M)

- 6. Reconocimiento emociones workplace/educación: IA detectando emociones en trabajo o escuela (excepciones médicas/seguridad limitadas)

- 7. Categorización biométrica: Inferir raza, opiniones políticas, orientación sexual, creencias religiosas de biometría

- 8. Biometría tiempo real espacios públicos: Identificación remota biométrica (ej: facial recognition live en calles) – excepciones law enforcement MUY limitadas

✅ ACCIÓN REQUERIDA HOY: Audita tu portfolio de sistemas IA. Si alguno cae en las 8 categorías prohibidas, debes descontinuarlo INMEDIATAMENTE o modificarlo para que no viole. No hay período de gracia. Violación = €35M multa desde feb 2025.

► Deadline #2: 2 Agosto 2025 – GPAI + Governance 🚨 INMINENTE

DEADLINE ACTIVO EN 6 MESES

El 2 de agosto de 2025 entran en vigor las obligaciones para:

- • Proveedores de modelos GPAI (OpenAI, Anthropic, Mistral, Meta, Google, y cualquier empresa entrenando LLMs ≥1023 FLOPs)

- • AI Office operacional (European AI Office comienza enforcement)

- • Autoridades nacionales designadas (cada país EU asigna competent authority)

Obligaciones GPAI (4 core requirements – Artículo 53):

Arquitectura modelo, proceso entrenamiento, computational resources, datasets, evaluation results, capabilities, limitations.

Publicación summary usando template Comisión: fuentes datos, volumen, técnicas curation, copyright compliance (robots.txt).

Política respetando DSM Directive: opt-outs via robots.txt, exclusión sitios piratería (EU list), TDM exception compliance.

Documentación para developers: API capabilities, use case restrictions, known risks, mitigation measures, performance benchmarks.

🎯 ¿Te afecta GPAI? Si usas OpenAI API, Claude API, Gemini API, Llama, Mistral, o cualquier LLM foundation → SÍ (eres downstream provider, debes conocer compliance upstream). Si entrenas modelos propios ≥1023 FLOPs → SÍ CRITICAL (eres provider GPAI, 4 obligaciones completas).

► Deadline #3: 2 Agosto 2026 – High-Risk Systems (18 meses countdown)

El 2 de agosto de 2026 es el big one para la mayoría de empresas tech. Aquí entran en vigor las obligaciones completas para sistemas IA de alto riesgo (Annex III use cases: empleo, educación, law enforcement, infraestructura crítica, crédito, healthcare, etc).

Obligaciones high-risk (Artículo 16 – provider obligations):

- ✓ Quality Management System (QMS completo según Artículo 17)

- ✓ Technical Documentation (Annex IV – 9 secciones detalladas)

- ✓ Automatic Logging (event logs para auditabilidad)

- ✓ Transparency & User Information (instructions for use)

- ✓ Human Oversight (measures efectivas para supervisión humana)

- ✓ Accuracy, Robustness, Cybersecurity (niveles apropiados según intended purpose)

- ✓ Conformity Assessment (third-party notified body o internal según tipo)

- ✓ CE Marking (certificación antes de market)

- ✓ EU Database Registration (registration en database público antes deployment)

- ✓ Post-Market Monitoring (continuous monitoring + incident reporting)

⚠️ Reality check: El estudio appliedAI de 106 sistemas IA empresariales encontró que 40% tienen clasificación UNCLEAR (no está claro si son high-risk o no). Si tu clasificación es incorrecta y tratas un sistema high-risk como low-risk → no CE marking, no conformity assessment = €15M multa + prohibition to market.

► Deadline #4: 2 Agosto 2027 – Productos Embedded + Grace Period GPAI

El 2 de agosto de 2027 (3 años desde entry into force) afecta a dos grupos específicos:

Productos con IA Embedded

Productos que caen bajo Union harmonisation legislation (Annex I del AI Act: medical devices, toys, machinery, vehicles, aviation, etc) tienen 1 año extra.

Ejemplo: Un dispositivo médico con IA diagnóstica debe cumplir EU AI Act + Medical Device Regulation. Deadline: ago 2027.

Grace Period GPAI Pre-Market

Modelos GPAI ya en el mercado antes de 2 ago 2025 tienen grace period hasta 2 ago 2027 para compliance completo.

Pero: modelos GPAI nuevos lanzados post 2 ago 2025 deben cumplir INMEDIATAMENTE (sin grace period).

► Deadline #5: 2 Agosto 2026 – Enforcement Powers de la Comisión

A partir del 2 de agosto de 2026, la Comisión Europea adquiere poderes de enforcement directos para:

- • Investigar violaciones de proveedores GPAI (especialmente riesgo sistémico ≥1025 FLOPs)

- • Imponer multas directamente (no solo autoridades nacionales)

- • Requerir audits e inspections de modelos GPAI

- • Ordenar medidas correctivas o prohibiciones

📅 Tu Timeline Personalizado: ¿Qué Deadlines Te Afectan?

💡 No estás seguro qué deadlines aplican? Usa nuestra herramienta de assessment:

8. Conclusión + Next Steps: Tu Roadmap de 90 Días

Llegamos al final de esta guía masiva. Si leíste hasta aquí, ya sabes más sobre EU AI Act compliance que 95% de CTOs en Europa.

Pero conocimiento sin acción no vale nada. Aquí está tu roadmap práctico de 90 días para llegar a compliance:

MES 1: Discovery & Assessment (Semanas 1-4)

Entender QUÉ tienes y QUÉ obligaciones aplican

Semana 1-2: AI Inventory

- • Lista TODOS los sistemas IA en tu empresa (production + staging + prototypes)

- • Para cada sistema: nombre, purpose, users, data sources, deployment status

- • Tool: Spreadsheet simple suficiente (o script Python scanning codebase imports: langchain, openai, anthropic, tensorflow, etc)

- • Output: Inventory completo (típicamente 5-30 sistemas para SaaS mid-size)

Semana 3: Risk Classification

- • Usa decision tree Sección 4 para CADA sistema en inventory

- • Marca sistemas: PROHIBIDO / HIGH-RISK / LIMITED-RISK / MINIMAL-RISK / GPAI

- • Si 40% unclear (appliedAI stat) → consult legal/technical advisor €2k-5k

- • Output: Classified inventory (e.g., "3 high-risk, 1 GPAI, 12 minimal-risk")

Semana 4: Deadline Mapping

- • Para cada sistema: identificar deadlines aplicables (Feb 2025 prohibited, Ago 2025 GPAI, Ago 2026 high-risk)

- • Prioritize urgency: GPAI (6 meses) > high-risk (18 meses) > limited-risk (18 meses)

- • Create Gantt chart personalizado con milestones

- • Output: Timeline compliance por sistema (visual roadmap)

MES 2: Documentation & Quick Wins (Semanas 5-8)

Crear documentación técnica + eliminar violations obvias

Semana 5-6: GPAI Compliance (si applica)

- • Copyright policy: Draft policy respecting robots.txt + DSM Directive (usar template BCloud)

- • Training data summary: Fill Commission template con datasets info

- • Technical docs: Model card con architecture, training process, evaluation

- • Downstream provider info: API docs con capabilities, limitations, prohibited uses

- • Output: 4 documentos GPAI compliant → publicar antes Ago 2 2025

Semana 7-8: High-Risk Annex IV (start)

- • Para sistemas high-risk: start Annex IV documentation (9 secciones)

- • Usar template BCloud + ejemplo RAG (Sección 6)

- • Priorizar sections críticas: architecture (#2), risk management (#6), data governance (#7)

- • Output: Draft 50% Annex IV (iterarás en Mes 3)

Quick Win: Prohibited Practices Audit

- • Usar checklist Sección 7 para auditar las 8 categorías prohibidas

- • Si encuentras violación → remediate INMEDIATAMENTE (modify o descontinue system)

- • Document decisión reasoning (por si audit futuro)

- • Output: Zero prohibited practices violations (prerequisito básico)

MES 3: Governance & Prep Conformity (Semanas 9-12)

Setup frameworks permanentes + preparar assessment

Semana 9-10: AI Governance Framework

- • QMS basics: Policies (AI acceptable use, deployment approval, incident response)

- • Roles & responsibilities: Designar AI Officer (puede ser fractional/external), RACI matrix

- • Tools setup: Policy docs (Confluence/Notion), risk register (Jira/Airtable), monitoring dashboards (Grafana/LangSmith)

- • Output: Operational governance framework (no necesita ser perfecto, iterate)

Semana 11: Conformity Assessment Strategy (High-Risk)

- • Research notified bodies EU (lista oficial en EU AI Act website cuando publiquen)

- • Criteria selección: expertise sector, experience AI systems, timeline, pricing

- • Pre-engagement informal (muchos notified bodies ofrecen pre-assessment consultation €5k-10k)

- • Output: Shortlist 2-3 notified bodies + contact iniciado

Semana 12: Gap Analysis & Roadmap

- • Compare estado actual vs requirements completos (Annex IV 9 sections, GPAI 4 requirements, governance 7 elements)

- • Identificar gaps específicos (e.g., "falta bias testing data governance", "monitoring post-market no setup")

- • Priorizar por: urgency deadline + complexity + cost

- • Output: Gap analysis report + roadmap Mes 4-12 hasta Ago 2026 (high-risk deadline)

⏰ ¿No Tienes 90 Días? Fast-Track de 30 Días (Mínimo Viable Compliance)

Si estás ultra-presionado por deadlines, aquí está la versión SPRINT:

Semana 1 (40 horas):

- • AI inventory (16h) + risk classification (16h) + deadline mapping (8h)

- • Output: Classified inventory + timeline visual

Semana 2 (40 horas):

- • Prohibited practices audit (8h) + remediation si needed (variable)

- • GPAI compliance documents draft (32h usando templates BCloud)

- • Output: Zero violations + GPAI docs 80% complete

Semana 3 (40 horas):

- • High-risk Annex IV draft sections críticas (40h: architecture, risk mgmt, data governance)

- • Output: Annex IV 30% complete (suficiente para notified body pre-assessment)

Semana 4 (40 horas):

- • Governance basics (policies 16h, roles 8h, monitoring setup 16h)

- • Gap analysis + roadmap remaining work (8h)

- • Output: Operational governance + plan Mes 2-12

⚠️ Disclaimer: 30-day sprint NO es compliance completo, es minimum viable para demostrar good-faith effort. Usalo solo si deadline GPAI Ago 2025 está encima y necesitas algo urgente. Ideal: 90 días con proper implementation.

► Por Qué BCloud Para Tu Compliance EU AI Act

He implementado compliance EU AI Act para empresas SaaS desde que la regulación fue aprobada (Marzo 2024). Aquí está por qué clientes eligen BCloud:

🛠️Technical + Legal Integration

No soy solo legal consultant. Tengo AWS ML Specialty + DevOps Professional certifications. Entiendo tu stack técnico (LangChain, RAG, MLOps pipelines, vector DBs). Hablo tu idioma.

⚡Implementation, No Solo Assessment

Big 4 consultancies cobran €200k+ por assessment reports que no implementan nada. BCloud: implemento código, setup monitoring, creo docs técnicas, integro en tu MLOps pipeline existente.

💰Pricing SME-Friendly

€18k-50k compliance completo (vs €200k+ Big 4). Fractional services: AI Officer retainer €2k-5k/mes (vs €120k/year full-time hire). Pay-as-you-go milestones.

📦Templates & Tools Reales

Esta guía tiene templates descargables (Annex IV, copyright policy GPAI, risk classification decision tree, penalty calculator). Uso en proyectos reales, no theory.

🎯 Servicios BCloud EU AI Act Compliance

Compliance Roadmap Assessment

- ✓AI inventory completo

- ✓Risk classification todos sistemas

- ✓Deadline mapping personalizado

- ✓Gap analysis + action plan

- ✓Report 20-30 páginas

High-Risk Documentation Service

- ✓Todo en Starter +

- ✓Annex IV completo (9 secciones)

- ✓FRIA (risk assessment)

- ✓Conformity assessment prep

- ✓Notified body pre-engagement

Full Compliance Program

- ✓Todo en Professional +

- ✓GPAI compliance (4 requirements)

- ✓AI Governance Framework (QMS)

- ✓MLOps integration (automated compliance)

- ✓CE marking support

- ✓6 meses post-implementation support

Solo 3 proyectos nuevos/mes. Reserva tu plaza antes de que sea tarde.

🎁 Bonus: Recursos Descargables Gratuitos

Descarga estos templates y tools AHORA (sin email requerido, acceso directo):

🚀 Ready to Start?

El deadline GPAI es Agosto 2 2025 (6 meses). High-risk deadline Agosto 2 2026 (18 meses).

Cuanto antes empieces, más tiempo tienes para iterar y refinar. No esperes al rush de última hora.

Última actualización: 25 Diciembre 2025

¿Preguntas sobre tu caso específico? Email: sam@bcloud.consulting

¿Listo para compliance EU AI Act production-ready?

Auditoría gratuita de tu portfolio AI - identificamos gaps y deadlines en 30 minutos

Solicitar Auditoría Gratuita →

Sobre el Autor

Abdessamad Ammi es CEO de BCloud Consulting y experto senior en IA Generativa y Cloud Infrastructure. Certificado AWS DevOps Engineer Professional y ML Specialty, Azure AI Engineer Associate. Ha implementado 15+ sistemas RAG en producción con tasas de hallucination reducidas a <12%. Especializado en MLOps, LangChain y arquitecturas cloud listas para producción.