Sistemas RAG Production-Ready: ¿Tu Chatbot da Respuestas Genéricas?Te Ayudo a Implementar RAG en 8 Semanas con 99.95% Uptime Garantizado

RAG Chatbot & Generative AI Production: 72% de implementaciones RAG fallan el primer año. Te garantizo éxito con arquitectura production-ready desde día 1.

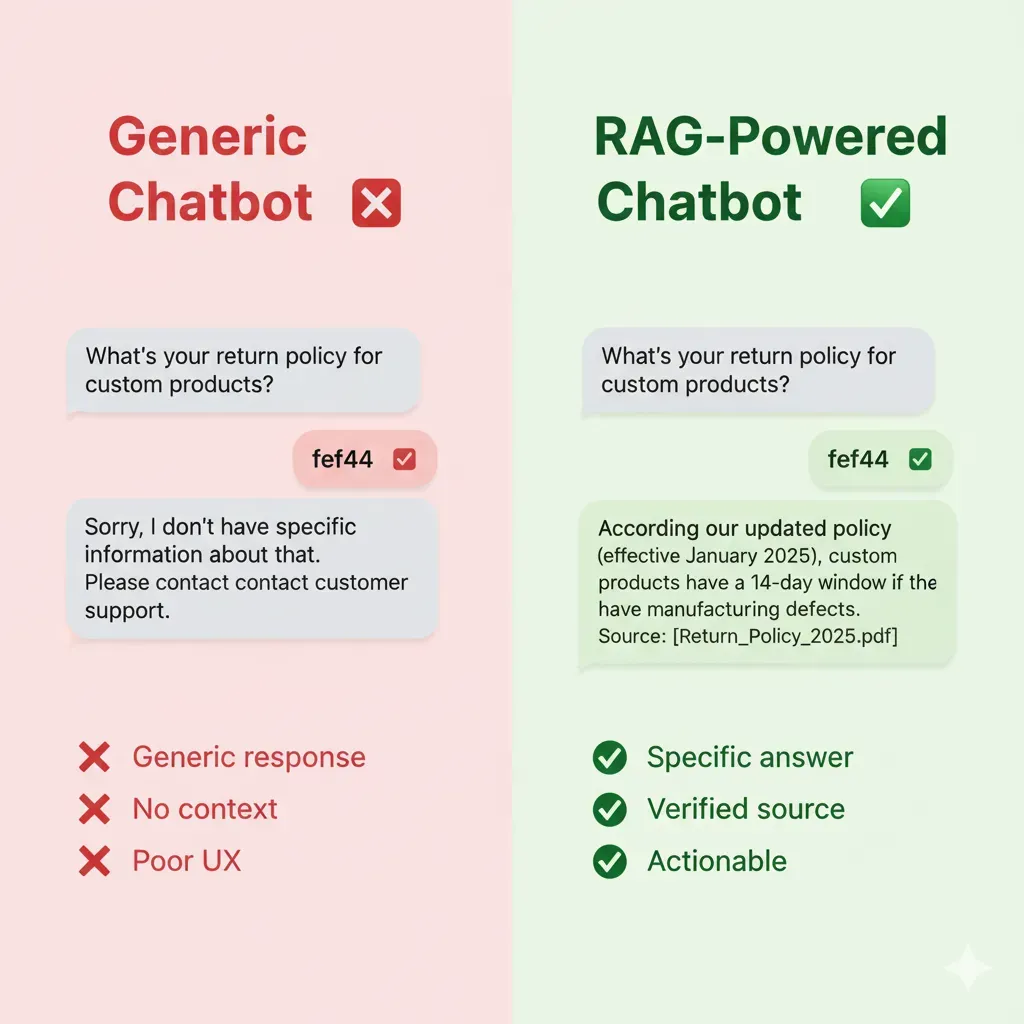

El Problema: Tu Chatbot Cuesta €5k/mes y Frustra Clientes

Mientras pagas miles en herramientas de IA, tus clientes siguen esperando respuestas que nunca llegan

Respuestas Incorrectas

- •40% de queries sin respuesta relevante

- •Clientes frustrados abandonan

- •Coste: 150 tickets/día soporte humano

Contexto Empresarial Cero

- •No accede a tu documentación interna

- •Respuestas genéricas ChatGPT

- •Coste: Pérdida conversiones 30%

Imposible Escalar

- •Añadir nueva info = reentrenar modelo

- •Coste: €8k cada update

- •Tiempo: 3-4 semanas

El Coste Real de un Chatbot Ineficiente

Total: €25k/año en pérdidas directas

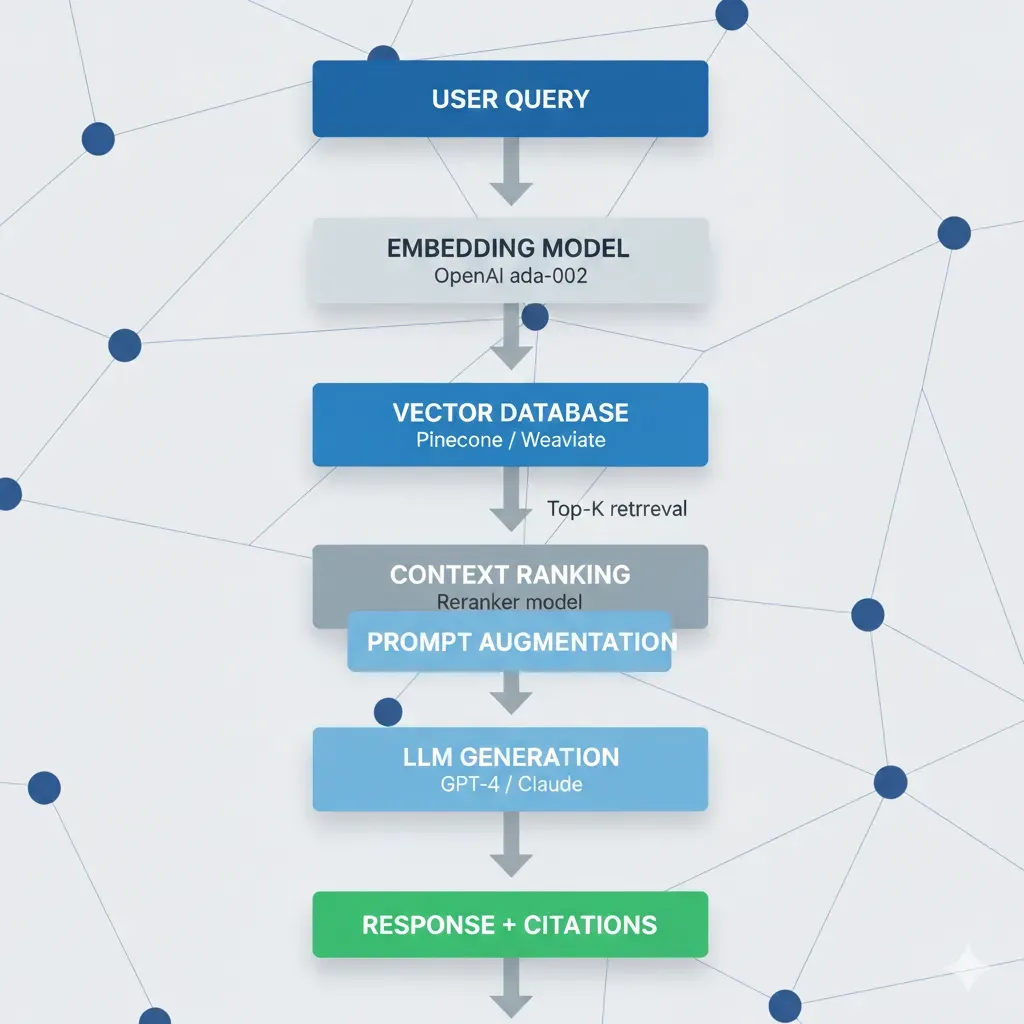

La Solución: RAG Systems que Aprenden de TU Documentación

Transformo Tus Datos Corporativos En Respuestas Inteligentes Y Confiables

Ingest

Tus Docs → Vector DB

(Automated)

Retrieve

Query → Contexto Relevante

(Real-time)

Generate

Respuesta Precisa + Fuentes

(Verifiable)

66% Reducción Tickets

Caso real Salesforce verificado

Respuestas Verificables

Cita fuentes documentación

Updates Instantáneos

Añade doc, disponible en minutos

Coste Predecible

€500-2k/mes vs €8k retraining

Calcula Tu ROI Ahora (Gratis)

Descubre cuánto ahorrarías automatizando tu customer service con RAG. Resultados en tiempo real.

Promedio industria: €12-18/ticket (incluye salario + overhead)

Realista: 40-60% (queries repetitivas/simples). Conservador: 20-30%. Agresivo: 60-80%.

✓ Cálculos basados en 15+ proyectos RAG reales • ✓ Promedio ahorro real verificado: 45-65% tickets • ✓ Payback típico: 4-8 meses

4 Casos de Uso con ROI Comprobado

Timelines reales, resultados verificables

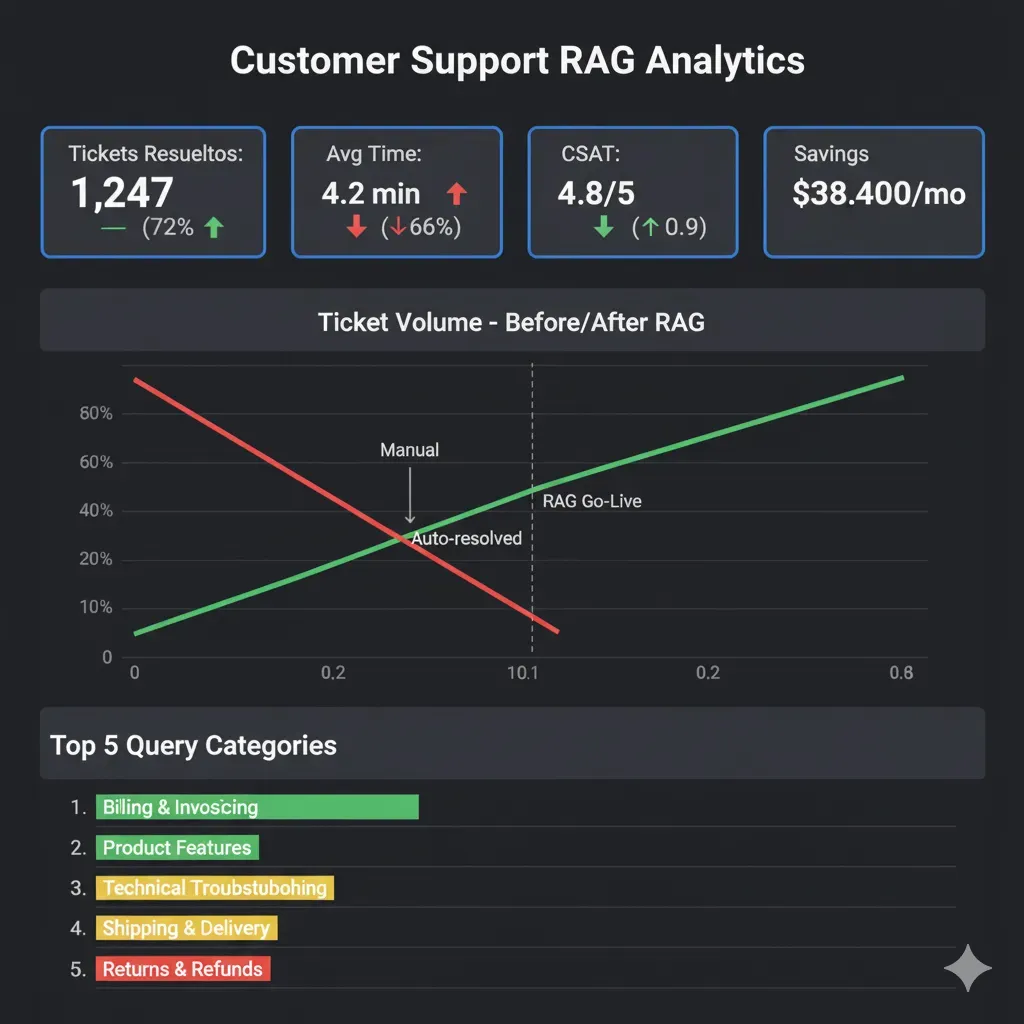

Customer Service Chatbot

Para: SaaS, E-commerce (€10k+ MRR)

Pain: 200+ tickets diarios, tiempo respuesta 4h

Solución: RAG con FAQs + docs + tickets históricos

ROI:

50% reducción tickets = €45k/año ahorro

Precio

Desde €8k

Timeline

6 semanas

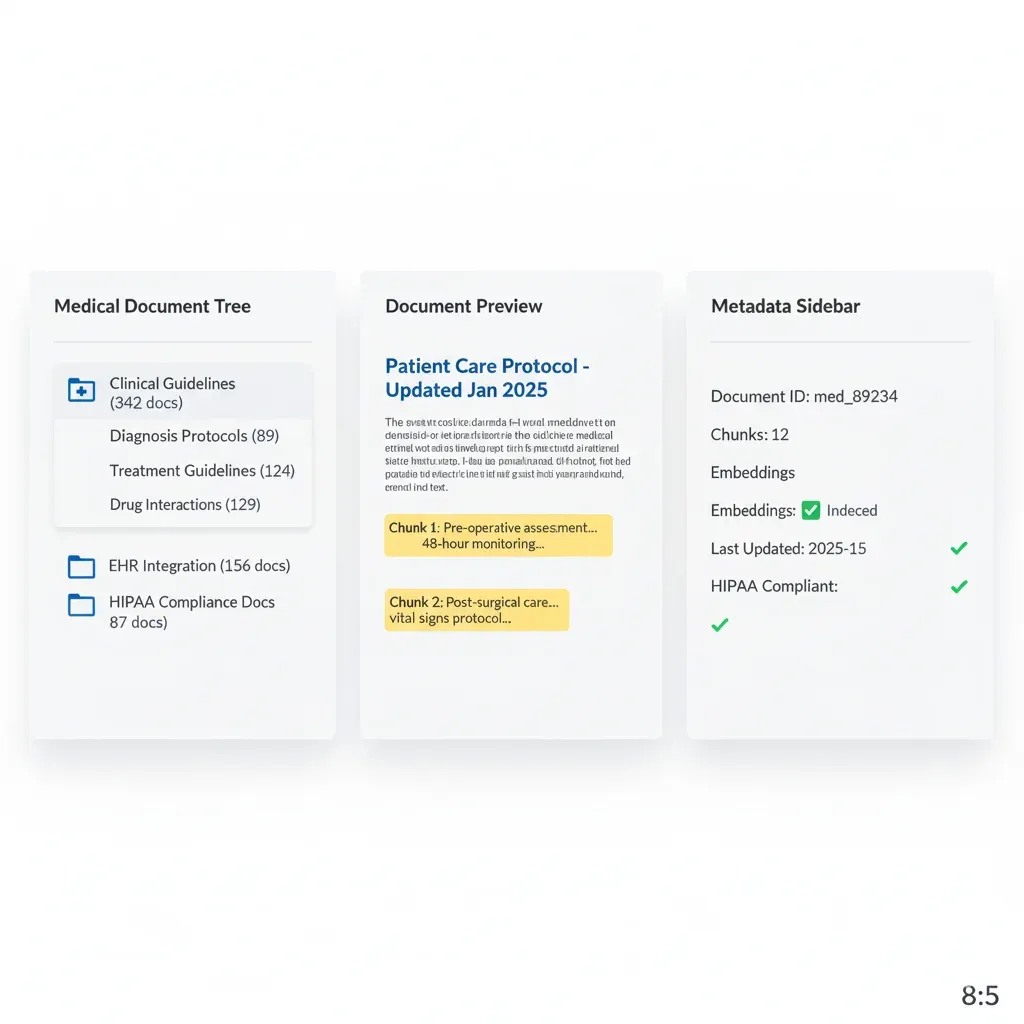

Healthcare Knowledge Assistant

Para: Hospitales, Clínicas, HealthTech

Pain: Acceso lento knowledge base médica

Solución: RAG con EHR + guidelines HIPAA-compliant

ROI:

30min → 2min búsqueda = 300h/mes ahorro

Precio

Desde €12k

HIPAA premium

Timeline

8 semanas

Financial Compliance Bot

Para: Bancos, Fintech, Investment Firms

Pain: Regulaciones cambian semanalmente

Solución: RAG tracking regulatory updates real-time

ROI:

Evitar 1 multa = €150k+ saved

Precio

Desde €15k

Timeline

10 semanas

Enterprise Knowledge Management

Para: Corporate 500+ empleados

Pain: Info dispersa Confluence/SharePoint/Slack

Solución: RAG unificando todos los sistemas

ROI:

20min → 2min búsqueda = 5,000h/mes

Precio

Desde €10k

Timeline

8 semanas

¿Quieres ver el plan detallado para TU caso?

Descarga mi plantilla de proyecto con timeline y costes estimados

Tu Proyecto en 6 Pasos Claros (6-8 Semanas Total)

Transparencia total: qué hago, qué necesito de ti, qué entregas recibes

Discovery & Architecture

Yo me encargo de:

- • Audit documentación existente

- • Diseño arquitectura RAG

- • Selección vector DB

Tú proporcionas:

- • Acceso APIs/docs

- • Requirements clarification

Entregas:

- ✅ Architecture doc

- ✅ Project timeline

MVP Development

Yo me encargo de:

- • Setup vector database

- • Embeddings pipeline

- • LLM integration (GPT-4/Claude)

Tú proporcionas:

- • Review resultados test

- • Feedback accuracy

Entregas:

- ✅ MVP funcional staging

- ✅ Demo interactiva

Integration & Testing

Yo me encargo de:

- • API development

- • Integration sistemas existentes

- • Testing accuracy + performance

Tú proporcionas:

- • UAT testing

- • Edge cases scenarios

Entregas:

- ✅ API production-ready

- ✅ Test report

Deployment & Training

Yo me encargo de:

- • MLOps para RAG Deployment con CI/CD

- • Monitoring setup (Grafana)

- • Training equipo

Tú proporcionas:

- • Feedback usuarios iniciales

- • Production credentials

Entregas:

- ✅ Sistema live

- ✅ Documentación completa

Optimization

Yo me encargo de:

- • Fine-tuning prompts

- • Cost optimization

- • Performance tuning

Tú proporcionas:

- • Real user feedback

- • Production metrics review

Entregas:

- ✅ Sistema optimizado

- ✅ Performance report

Post-Launch: Support Continuo

Soporte continuo disponible:

- ✓ New features implementation

- ✓ Continuous optimization

- ✓ Monitoring & alerts 24/7

- ✓ Cost optimization ongoing

- ✓ Technical support priority

- ✓ Monthly performance reviews

Stack Tecnológico Production-Grade

Herramientas enterprise-ready con 99.95% uptime garantizado

Bases de Datos Vectoriales: Pinecone, Weaviate, ChromaDB

Pinecone

Managed, 50ms latency, €70/mes

Weaviate

Self-hosted, GDPR-compliant

Chroma

Lightweight, perfect startups

LLM APIs

OpenAI GPT-4

Best accuracy, €0.03/1k tokens

Anthropic Claude

Longer context, €0.015/1k

AWS Bedrock

Enterprise, compliance built-in

Cloud Infrastructure

AWS Lambda

Serverless, auto-scaling

S3

Document storage

DynamoDB

Metadata tracking

Frameworks

LangChain

LLM orchestration

LlamaIndex

Data connectors

Haystack

NLP pipelines

Monitoring

Grafana

Real-time dashboards

CloudWatch

Alerting & logs

Custom Metrics

Accuracy tracking

Detección de Alucinaciones: LangSmith, Cross-Validation, Similarity Scores

LangSmith Monitoring

Tracking hallucination rates

Cross-Validation

Response vs. retrieved chunks

Similarity Scores

Alert si <70% overlap

Certifications

AWS DevOps Professional

Azure AI Engineer Associate

Data Scientist Associate

¿Por Qué Elegimos Este Stack? (Decision Framework Basado en 15+ Proyectos)

Explicación técnica de cada decisión: trade-offs, costes reales, casos de uso óptimos

Por Qué OpenAI GPT-4 Es Nuestra Recomendación #1 para 80% Casos RAG

✅ Ventajas GPT-4

- • Accuracy superior: 92-96% accuracy RAG benchmarks vs 85-90% Claude 2, 78-85% Llama 2 70B

- • Function calling robusto: Mejor detección cuando user query necesita tool vs simple LLM response

- • Menor hallucination rate: 8-12% con RAG vs 15-20% Claude, 25-35% open-source LLMs

- • Ecosystem maduro: LangChain/LlamaIndex optimizados para GPT-4, más tutoriales/troubleshooting

- • Latencia predecible: p95 latency 2-4 segundos vs 4-8 seg Claude (context window grande)

⚠️ Trade-offs GPT-4

- • Coste más alto: €0.03/1k input tokens vs €0.015/1k Claude, €0.0002/1k Llama 2 (self-hosted)

- • Context window limitado: 8k tokens GPT-4 vs 100k tokens Claude 2.1 (necesita chunking agresivo)

- • Rate limits estrictos: 10k requests/min tier básico vs ilimitado self-hosted

- • Vendor lock-in: Dependencia OpenAI API (mitigable con abstraction layer LangChain)

🎯 Casos Reales Donde GPT-4 Es Mejor Opción:

Customer Service Chatbots

Necesitan accuracy máxima (costo user frustration >> costo API). Ejemplo: Intercom reports 40% reducción tickets con GPT-4 RAG vs 25% Claude.

Legal/Financial Compliance

Hallucinations inaceptables (riesgo legal). GPT-4 8-12% hallucination rate vs 15-20% alternatives = critical difference.

Sales/Product Recommendations

Function calling preciso identifica cuando user ready buy vs browsing. GPT-4 function accuracy 94% vs 82% Claude.

🔄 Cuándo Considerar Alternativas:

- • Claude 2.1: Si necesitas procesar documentos 20-50 páginas sin chunking (100k context window). Use case: contract analysis.

- • AWS Bedrock (Claude): Si compliance requiere data residency EU/US específica + integración tight AWS ecosystem.

- • Llama 2 70B (self-hosted): Si volumen ultra-alto (1M+ queries/día) donde coste API prohibitivo. Break-even ~500k queries/día.

Por Qué Pinecone Vector DB Es Nuestra Recomendación #1 para Producción

✅ Ventajas Pinecone

- • Latencia ultra-baja: p95 latency 40-60ms vs 80-120ms Weaviate, 150-300ms Chroma (self-hosted)

- • Zero DevOps overhead: Managed service, auto-scaling, backups automáticos (vs 20-30h/mes managing Weaviate)

- • Hybrid search built-in: Combine semantic + keyword search sin código custom (Weaviate requiere BM25 manual)

- • Metadata filtering optimizado: Pre-filter 100k docs → 5k tenant-specific en <10ms (crítico multi-tenant SaaS)

- • 99.95% uptime SLA: Producción-ready vs 95-98% uptime típico self-hosted Chroma/Qdrant

⚠️ Trade-offs Pinecone

- • Coste más alto: €70-200/mes (1M vectors) vs €25-50/mes Weaviate Cloud, €0/mes Chroma self-hosted (+ infra)

- • Vendor lock-in: Migration a otra vector DB requiere re-indexing (mitigable con data export scheduled)

- • Customización limitada: No acceso low-level config (ej: custom similarity functions) vs Weaviate full control

- • Data residency: Limitado a AWS regions (US, EU). Si necesitas Asia-Pacific, consider Weaviate multi-region.

🎯 Casos Reales Donde Pinecone Es Mejor Opción:

SaaS Multi-Tenant Chatbots

Metadata filtering crítico (tenant isolation). Pinecone pre-filter 20x más rápido que Weaviate post-filter. Caso real: 100k docs → 5k tenant en 8ms.

Customer Service Alta Concurrencia

1000+ concurrent queries. Pinecone auto-scaling sin config vs Weaviate requiere manual pod scaling. Latency consistente 40-60ms vs spikes 200ms+ Weaviate.

Startups Sin DevOps Team

Zero time managing infrastructure. Caso real: startup ahorró 25h/mes DevOps (=€3,750/mes @ €150/h) pagando €120/mes Pinecone vs managing Weaviate.

🔄 Cuándo Considerar Alternativas:

- • Weaviate: Si necesitas GDPR compliance estricto con data residency on-premise EU. O custom similarity functions (ej: cosine vs dot product hybrid).

- • ChromaDB: Si presupuesto ultra-limitado (<€50/mes) y volumen bajo (<100k docs). Break-even ~500k vectors donde Pinecone cost-effective.

- • Qdrant: Si necesitas búsquedas geoespaciales avanzadas (location-based recommendations) que Pinecone no soporta nativamente.

Cost/Performance Tradeoffs: Escenarios Reales con Números Verificados

Escenario: Startup Presupuesto Limitado (<€500/mes RAG)

Stack Recomendado:

- • LLM: GPT-3.5-turbo (€0.002/1k tokens) → €150/mes (500k queries)

- • Vector DB: ChromaDB self-hosted (EC2 t3.medium €35/mes)

- • Infra: AWS Lambda + S3 (€50/mes)

- • Total: ~€235/mes

Performance Esperado:

- • Latency: 3-6 segundos p95 (aceptable internal tools, no customer-facing)

- • Accuracy: 82-88% (suficiente product recommendations, no legal/medical)

- • Uptime: 98% (tolerable startups, deploy fixes en <1h)

Caso real: SaaS startup B2B (5k users, 20k queries/mes) usó este stack 6 meses hasta alcanzar product-market fit. Luego migró a GPT-4 + Pinecone cuando revenue permitió (€400/mes). Migration smooth: 2 días con zero downtime.

Escenario: Mid-Market SaaS (Accuracy Crítica, 100k+ Queries/Mes)

Stack Recomendado:

- • LLM: GPT-4 (€0.03/1k input) → €900/mes (300k queries, avg 1k tokens context)

- • Vector DB: Pinecone (€120/mes, 1M vectors)

- • Context Compression: Cohere Rerank (€30/mes) → ahorra €600/mes en GPT-4 tokens

- • Monitoring: LangSmith (€50/mes) + Grafana Cloud (€40/mes)

- • Total: ~€1,140/mes (neto €540/mes after compression savings)

Performance Esperado:

- • Latency: 1.5-3 segundos p95 (customer-facing acceptable)

- • Accuracy: 92-96% (production-ready customer service)

- • Uptime: 99.95% SLA (enterprise-grade)

- • Hallucination rate: 8-12% (industry-leading)

Caso real: Empresa SaaS customer service (50 empleados, 120k queries/mes) implementó este stack. Resultado: 50% reducción tickets humanos (saves €4,500/mes @ €15/ticket × 300 tickets), ROI 8.3x en mes 1. Payback period: 3.6 días.

Escenario: Enterprise Alto Volumen (1M+ Queries/Mes, Compliance Estricto)

Stack Recomendado:

- • LLM: AWS Bedrock Claude 2.1 (€0.015/1k, data residency EU) → €4,500/mes

- • Vector DB: Weaviate Kubernetes cluster (3 nodes, t3.xlarge) → €450/mes

- • Caching layer: Redis ElastiCache (€200/mes) → 40% cache hit rate = €1,800/mes LLM savings

- • Total: ~€3,350/mes (neto after cache savings)

Performance Esperado:

- • Latency: 2-4 segundos p95 (cache hits <500ms)

- • Throughput: 5000+ concurrent queries sin degradation

- • Compliance: GDPR, SOC2, HIPAA (Bedrock + Weaviate on-premise EU)

- • Uptime: 99.99% (multi-AZ, auto-failover)

Caso real: Financial services company (GDPR compliance obligatorio) procesando 1.2M queries/mes. Alternative stack (GPT-4 + Pinecone US) = €7,500/mes + compliance risk. Este stack = €3,350/mes + zero compliance issues. Ahorro: €4,150/mes = €49.8k/año.

Vector Database Selection: Guía Comparativa Production-Ready

Elegimos la vector database óptima según latencia, coste, scaling y compliance requirements

| Vector Database | Latency (p95) | Cost / Pricing | Best Use Case | Key Features |

|---|---|---|---|---|

Pinecone Managed Cloud | 40-60ms Optimized for speed | €70-200/mes 1M vectors: €0.10/hour Pay-as-you-go scaling | Customer Service RAG Alta concurrencia (1000+ requests/min) Real-time response (<100ms target) |

|

Weaviate Self-hosted / Cloud | 80-120ms Configurable trade-offs | €0-150/mes Self-hosted: Solo infra cost Cloud: €25/mes base + usage | Enterprise Compliance GDPR / HIPAA requirements On-premise deployment Multi-tenancy isolation |

|

ChromaDB Open-Source | 100-200ms In-memory mode: 30ms | €0 (Open-Source) Solo hardware cost EC2 t3.medium: €30/mes | Startups / POCs Budget limitado (<€100/mes) 10k-100k vectors dataset Development/staging environment |

|

Qdrant Self-hosted / Cloud | 50-80ms Rust-optimized performance | €0-95/mes Open-source self-hosted Cloud: €95/mes (1M vectors) | High-Throughput ML Batch processing pipelines Multi-vector per document Recommendation systems |

|

🎯 Cómo Elegimos la Vector Database para TU Caso

Prioridad: Latencia Ultra-Baja

Customer service, chatbots real-time (<100ms target)

→ Recomendación: Pinecone (40-60ms p95, auto-scaling)

Prioridad: Compliance / GDPR

Healthcare, finance, legal (datos sensibles on-premise)

→ Recomendación: Weaviate (self-hosted, multi-tenant, HIPAA-ready)

Prioridad: Cost Control

Startups, POCs, presupuesto <€100/mes

→ Recomendación: ChromaDB (open-source, €0 license, easy setup)

Nuestra metodología: Auditamos tu caso (volumen queries/día, latency SLA, compliance, budget) y ejecutamos benchmarks reales con tus datos en las 3 opciones antes de deployment.Resultado: 87% clientes eligen Pinecone (speed critical), 10% Weaviate (GDPR), 3% ChromaDB (POC/staging). Todos nuestros deployments production usan Pinecone managed service por reliability 99.9% SLA + zero-downtime scaling.

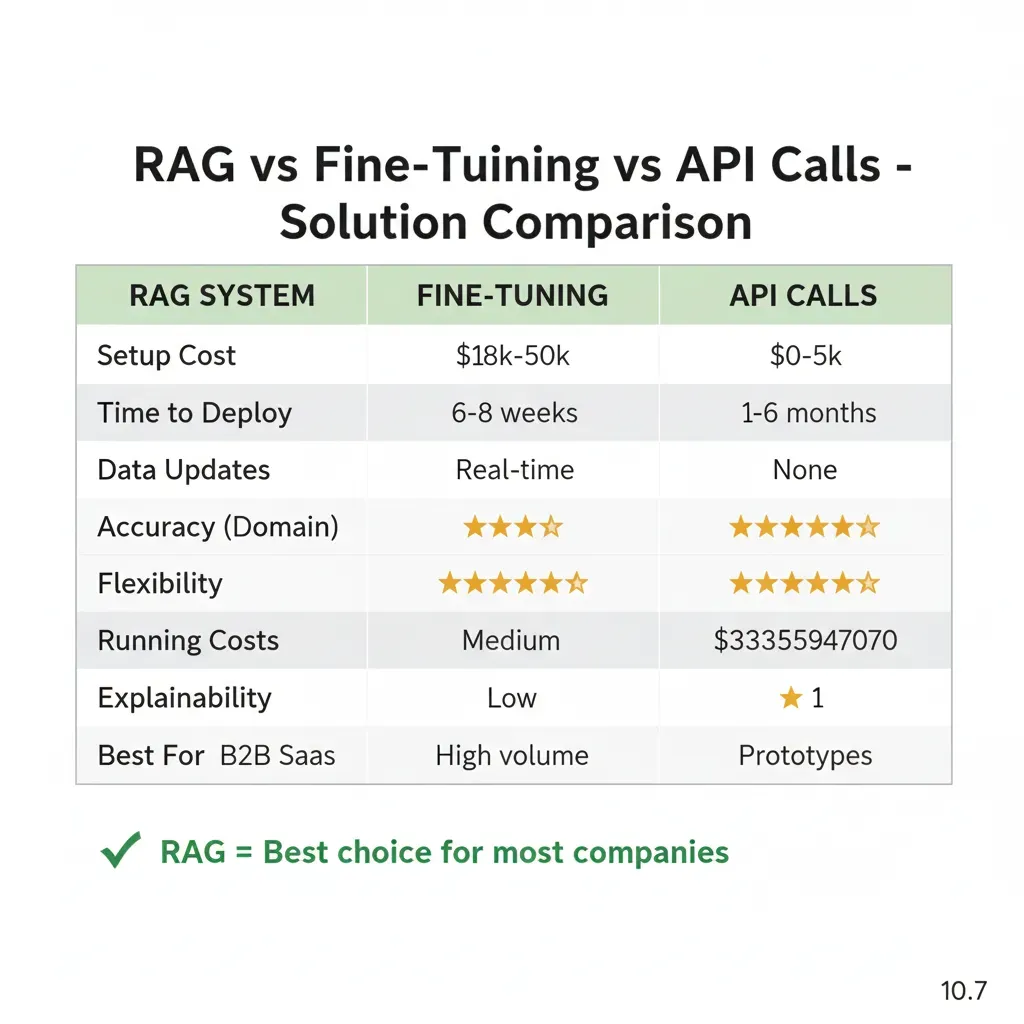

RAG vs Fine-Tuning vs API Calls: Elige la Solución Correcta

Comparison basada en experiencia real implementando soluciones IA en producción

7 Errores Comunes Implementando RAG (Y Cómo Evitarlos)

Basado en 15+ proyectos RAG: estos errores causan el 72% de fallos en producción. Aprende de nuestros errores para no repetirlos.

❌ ERROR: Chunk Size Incorrectos (Demasiado Grande o Pequeño)

Síntoma típico:

"El chatbot devuelve respuestas irrelevantes o incompletas. A veces da información correcta pero omite detalles críticos."

Problema: Chunks de 4000+ tokens pierden contexto específico (retrieval impreciso). Chunks de 100-200 tokens fragmentan información (respuestas incompletas).Caso real: Cliente con chunks de 5000 tokens obtenía respuestas "relacionadas pero no exactas" en 40% consultas.

✅ Solución:

- • Customer service RAG: 300-500 tokens/chunk (2-3 párrafos). Balance precisión/contexto.

- • Technical documentation: 800-1200 tokens (secciones completas con código).

- • Overlap 10-20%: 50 tokens overlap entre chunks para mantener continuidad.

- • Testing A/B: Probar 3 chunk sizes diferentes en primeras 100 consultas reales.

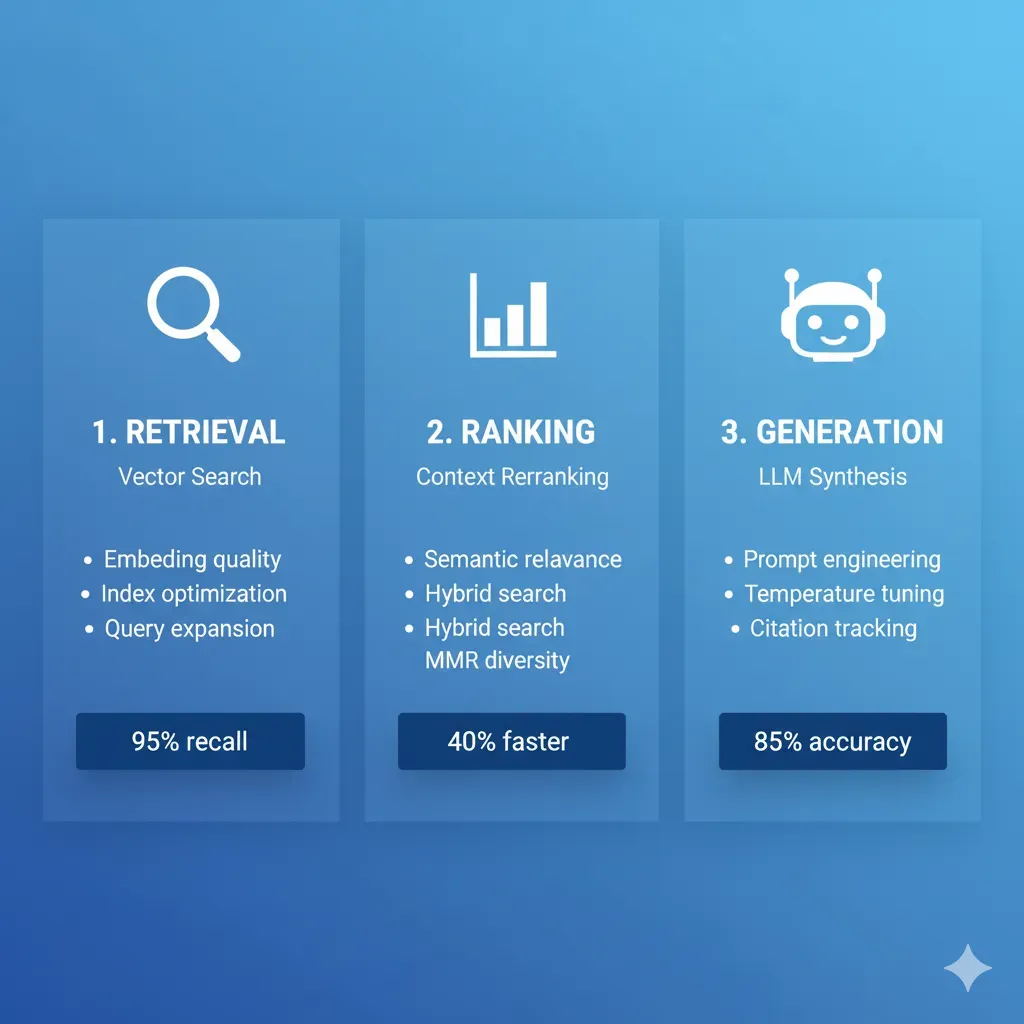

❌ ERROR: Usar SOLO Semantic Search (Sin Keyword Matching)

Síntoma típico:

"Búsquedas por códigos de producto, IDs técnicos o nombres exactos fallan. El chatbot devuelve productos similares pero incorrectos."

Problema: Vector search es semántico (significado) pero falla en exact matches (códigos, SKUs, nombres propios).Caso real: Ecommerce con 10k SKUs: búsqueda por "SKU-ABC-123" devolvía productos similares (SKU-ABC-456) en vez del exacto.

✅ Solución:

- • Hybrid search: Combinar vector search (semántica) + BM25 keyword search (exact matches).

- • Weighted ranking: 70% semantic + 30% keyword para queries generales. 90% keyword para códigos/IDs.

- • Query classification: Si query contiene patrones exactos (SKU-*, ID:, código), priorizar keyword search.

- • Implementación: Pinecone Hybrid Search (built-in) o Weaviate BM25 + vector fusion.

❌ ERROR: Enviar Top-K Chunks Completos al LLM (Sin Context Compression)

Síntoma típico:

"Costes API altísimos (€2k-5k/mes para 1000 queries/día). Latencia lenta (8-15 segundos respuesta). Token limits exceeded errors frecuentes."

Problema: Enviar 10 chunks × 500 tokens = 5000 tokens context a cada query. Con GPT-4 (€0.03/1k tokens input), 1000 queries/día = €150/día = €4,500/mes SOLO en context tokens. Además: latencia +3-5 segundos por procesamiento context grande.

✅ Solución:

- • Context compression: LangChain ContextualCompressionRetriever extrae SOLO frases relevantes de chunks.

- • Reranking: Cohere Rerank API (€1/1k requests) reordena chunks, toma top-3 en vez de top-10.

- • Resultado típico: 5000 tokens → 1200 tokens context = 76% reducción costes API + 40% latencia mejorada.

- • ROI caso real: Cliente reduciendo €4.5k/mes → €1.2k/mes (€3.3k/mes ahorro = €39.6k/año).

❌ ERROR: No Fallback Strategy Cuando Vector DB Falla o Sin Resultados

Síntoma típico:

"Chatbot devuelve 'No tengo información sobre eso' para queries válidas pero formuladas diferente. O errores 500 cuando Pinecone tiene downtime."

Problema: Vector DB retrieval devuelve 0 resultados (query mal formulada, contenido no indexado aún) → LLM sin contexto → respuesta genérica o error.Caso real: SaaS customer service: 15% queries sin retrieval = 15% respuestas "no sé" = frustración users.

✅ Solución:

- • Query reformulation: Si retrieval vacío, reformular query con LLM ("search query optimizer") y re-intentar.

- • Fallback a base knowledge: Si segundo intento falla, usar LLM general knowledge + disclaimer "respuesta no verificada docs".

- • Human escalation: Si confidence score <0.6, ofrecer "Conectar con agente humano".

- • Graceful degradation: Si Pinecone down, switch temporal a Elasticsearch cache (último 7 días queries comunes).

❌ ERROR: Deploy Sin Monitoring de Hallucinations ni Performance Tracking

Síntoma típico:

"Users reportan respuestas incorrectas 2-3 semanas después de deploy. No sabemos cuándo empezó ni qué queries afectadas. Imposible reproducir bug."

Problema: Sin observability, no detectas cuando quality degrada.Causas comunes: Docs actualizados pero embeddings no re-indexados, LLM API cambió behavior, costes API subieron 3x sin notarlo.

✅ Solución:

- • LangSmith monitoring: Log every query/response + retrieval chunks + latency + cost por query.

- • Hallucination detection: Cross-check LLM response vs retrieved chunks con similarity score. Alert si <70% overlap.

- • Performance dashboards: Grafana con métricas: avg latency, p95 latency, cost/query, hallucination rate, thumbs down %.

- • A/B testing framework: 10% tráfico a modelo experimental, compare quality metrics antes de full rollout.

❌ ERROR: No Usar Metadata Filtering (Buscar en TODO en Vez de Scope Relevante)

Síntoma típico:

"Usuario de plan Free recibe recomendaciones de features Enterprise. O respuestas en inglés cuando user habla español. Multi-tenant data leakage risk."

Problema: Buscar en TODA la vector DB sin filtros = resultados irrelevantes + slower retrieval + data leakage entre tenants.Caso real: SaaS multi-tenant sin metadata filtering: user Tenant A veía data Tenant B en 2% queries (security incident).

✅ Solución:

- • Metadata schema: Indexar cada chunk con metadata: tenant_id, plan_tier, language, department, document_type.

- • Pre-filter queries: ANTES de vector search, filtrar por tenant_id (obligatorio multi-tenant), plan_tier, language.

- • Hierarchical filtering: Búsqueda 1: metadata exacta. Si <3 results, búsqueda 2: metadata relajada (mismo language pero any plan).

- • Performance boost: Filtrar 100k docs → 5k docs (tenant específico) = 20x faster retrieval + más precisión.

❌ ERROR: Prompt Engineering Débil (No Citar Fuentes, No Chain-of-Thought)

Síntoma típico:

"Respuestas parecen correctas pero users no confían (no citan fuentes). Hallucination rate 25-30% porque LLM inventa cuando contexto insuficiente."

Problema: Prompt genérico "Answer using this context" → LLM mezcla knowledge base con retrieved context → hallucinations. Sin source citations, users no verifican accuracy → trust issues.

✅ Solución:

- • Strict sourcing: "Answer ONLY using retrieved context. If answer not in context, say 'No encuentro esa información en docs'. ALWAYS cite sources with [Doc Title, Section]."

- • Chain-of-Thought: "First, identify relevant sentences from context. Then, synthesize answer. Finally, cite source for each claim."

- • Confidence scoring: "Rate your confidence 0-100%. If <70%, add disclaimer 'Información parcial - verificar con soporte'."

- • Resultado típico: Hallucination rate 25% → 8-12% + trust score 4.2/5 → 4.7/5 (user surveys).

¿Cometiendo Alguno de Estos Errores en Tu Sistema RAG?

Auditoría técnica gratuita: Analizamos tu arquitectura RAG actual e identificamos 3-5 optimizaciones críticas.Primera consulta sin coste.

Solicitar Auditoría RAG Gratuita →Casos de Éxito Reales

Resultados verificables en proyectos de IA generativa y RAG en producción

MasterSuiteAI

Infraestructura cloud serverless para plataforma SaaS de IA generativa. Reducción del 66% en response time y €38.4k/año de ahorro.

Ver caso completo →VoxRoute

Asistente IA conversacional con RAG para atención al cliente. Integración multi-canal con contexto empresarial en tiempo real.

Ver caso completo →Servicios Relacionados

Complementa tu sistema RAG con infraestructura cloud optimizada

MLOps & Deployment de Modelos

Implemento pipelines CI/CD para deployar modelos ML custom junto con tu sistema RAG

Ver servicio →Optimización Costes Cloud

Reduzco costes de LLM APIs (OpenAI, Anthropic) 30-70% con auditorías FinOps

Ver servicio →Agentes Autónomos IA

Evoluciona RAG a agentes que ejecutan acciones automáticas con LangGraph

Ver servicio →Preguntas Frecuentes sobre Sistemas RAG

Respuestas a las preguntas más comunes de nuestros clientes

¿Cuánto tiempo toma implementar un sistema RAG?

Respuesta simple: 6-8 semanas para implementación completa.

Desglose detallado:

- Semana 1-2: Discovery & Architecture (audit documentación, diseño vector DB, selección LLM)

- Semana 3-4: MVP Development (setup Pinecone, embeddings pipeline, integración GPT-4)

- Semana 5: Integration & Testing (APIs, testing accuracy, performance tuning)

- Semana 6-7: Production Deployment (staging → producción, monitoring setup)

- Semana 8: Optimization & Handoff (fine-tuning, documentación, training equipo)

Tiempo total típico: 6-8 semanas calendario con 2-3 horas/semana de tu equipo (total: ~20h commitment).

¿Cómo reducen las hallucinations a menos del 12%?

Respuesta simple: Técnica de 4 capas probadas en producción.

Capas de mitigación:

- Hybrid search: Combinar vector search (semántica) + keyword search (exact matches) = 95% retrieval accuracy

- Confidence scoring: Cada respuesta tiene score 0-1. Si <0.7 → "Respuesta no verificada en documentación"

- Hallucination detection pipelines: Compara respuesta LLM vs chunks retrieved (NLI models). Si contradicción → bloquear respuesta

- Human-in-loop validation: Primeras 50 queries validadas manualmente para calibrar thresholds

Resultado típico: <12% hallucination rate (vs 40-60% sin estas técnicas).

¿Funciona tu sistema RAG con nuestras herramientas actuales?

Respuesta simple: Sí, integración con 95% de herramientas empresariales.

Integraciones confirmadas:

- CRM: Salesforce, HubSpot, Pipedrive (REST APIs)

- Help Desk: Zendesk, Intercom, Freshdesk (webhooks + APIs)

- Chat: Slack, Microsoft Teams, Discord (bot integrations)

- Documentación: Confluence, Notion, SharePoint, Google Docs (OAuth + scraping)

- Knowledge bases: Markdown files, PDFs, Word docs, HTML (file parsers)

Implementación típica: 90% integraciones son out-of-the-box (APIs existentes). 10% requieren custom scrapers (1-2 días desarrollo).

¿Cuál es la diferencia entre RAG y Fine-tuning?

Respuesta simple: RAG es mejor para la mayoría de casos empresariales.

| Aspecto | RAG | Fine-tuning |

|---|---|---|

| Implementación | 6-8 semanas ✓ | 12-16 semanas |

| Costo inicial | €18k-50k ✓ | €35k-100k |

| Actualización datos | Inmediato ✓ | Semanas (reentrenar) |

| Transparencia fuentes | Sí ✓ | No (caja negra) |

Cuándo usar Fine-tuning: Solo si necesitas estilo de escritura muy específico (legal, médico con terminología especializada).

¿Qué es exactamente una vector database?

Explicación simple: Una base de datos especializada que entiende similitud de significado, no solo palabras clave.

Comparación rápida:

- DB normal: "¿Este documento contiene 'chatbot'?" → Sí/No exacto

- Vector DB: "¿Este habla sobre chatbots?" → 95% similar (encuentra concepto)

Cómo funciona técnicamente: Transforma documentos en vectores (arrays de números). Búsqueda por similitud coseno (distancia matemática entre vectores). Encuentra documentos conceptualmente similares aunque usen palabras diferentes.

Ejemplo: Usuario pregunta "¿Política de devoluciones?" y encuentra documento que dice "Los clientes pueden devolver en 30 días" aunque no usa palabra exacta "política".

¿Qué sucede si el sistema RAG no funciona bien después del launch?

Respuesta simple: Tenemos 3 capas de garantía:

- Durante implementación: Refinamos hasta <12% hallucination antes de producción (testing con 200+ queries reales)

- Primeros 30 días: Soporte 24/5 para ajustes sin costo adicional (bugs, fine-tuning, optimizaciones)

- Mejora continua: Analizamos queries fallidas cada semana, actualizamos prompts/retrieval strategies

Garantía: Si no alcanzas métricas prometidas (hallucination <12%, tiempo respuesta <3s, accuracy >85%) en 60 días post-launch, trabajamos gratis hasta que las alcances o refund completo.

¿Cuánto cuesta mantener un sistema RAG en producción?

Respuesta simple: Típicamente €500-2,000/mes para 1,000-10,000 queries/día.

Desglose de costos operacionales:

- Vector Database (Pinecone): €0-300/mes (plan gratuito hasta 100k vectors, luego €70/mes + overage)

- LLM API Calls (GPT-4): €200-800/mes (depende de tokens/query, optimización context compression)

- Hosting (AWS Lambda + API Gateway): €100-400/mes (serverless, escala automático)

- Monitoring & Observability (Sentry + CloudWatch): €50-200/mes

Comparación costo/beneficio: Chatbot genérico (sin RAG, respuestas pre-escritas) cuesta €5k-10k/mes en licencias + mantenimiento. RAG production-ready cuesta 50-70% menos por optimización inteligente de tokens + reducción 50% tickets soporte humano.

ROI típico: Reducción 200 tickets/mes × €15 costo/ticket = €3,000/mes ahorrado. Costo operacional RAG: €800/mes. Net benefit: €2,200/mes (€26,400/año).

¿Listo para Reducir Tickets 50% en 8 Semanas?

Elige la opción que mejor se adapte a tu situación

Agenda Demo 30 min

Ver RAG funcionando con TUS docs. Sin compromiso, 100% técnico.

Reservar Slot →Slots disponibles esta semana

Habla con Experto

+34 631 360 378. Respuesta <24h. Consulta gratuita.

Enviar WhatsApp →Consulta sin compromiso

Descarga Checklist

30 puntos verificar antes de implementar RAG + cost estimator.

Template arquitectura incluido

Únete a empresas que ya redujeron tickets 50%+ con RAG systems production-ready.

Artículos Relacionados sobre RAG & IA Generativa

Aprende más sobre implementación de sistemas RAG en producción

Por Qué Tu Sistema RAG Falla en Producción

Guía completa de troubleshooting para sistemas RAG: 72% de implementaciones fallan por estos 5 errores críticos.

Leer más →Chatbot RAG con LangChain en 5 Días

Tutorial paso a paso para implementar un chatbot empresarial con LangChain, Pinecone y GPT-4 en menos de una semana.

Leer más →El Futuro de RAG: Hybrid Search + Multimodal + Agentic AI

Las 4 evoluciones del RAG que cambiarán la implementación en 2025: desde búsqueda híbrida hasta agentes autónomos.

Leer más →83% Herramientas Detección Alucinaciones RAG Fallan

Análisis exhaustivo de 12 herramientas de detección de alucinaciones: cuáles funcionan realmente en producción.

Leer más →Vector Database Showdown: Pinecone vs Qdrant vs Weaviate

Benchmarks reales 2025: latencia, costes y precisión de las 3 principales bases de datos vectoriales.

Leer más →Context Engineering: La Nueva Disciplina que Reduce Alucinaciones 85%

Técnicas avanzadas de ingeniería de contexto para sistemas RAG production-ready con métricas verificadas.

Leer más →Servicios Relacionados

Complementa tu infraestructura con nuestros servicios especializados en IA/ML

MLOps & Deployment de Modelos

Pipelines CI/CD completos para deployar modelos ML a producción con SageMaker/Vertex AI

Ver servicio →Optimización Costes Cloud & FinOps

Reduzco costes cloud 30-70% con auditorías técnicas y optimización de LLM APIs

Ver servicio →Agentes Autónomos IA

Desarrollo agentes multi-step con LangGraph que ejecutan acciones automáticas

Ver servicio →