La Realidad Brutal: 80% Sin Impacto EBIT (McKinsey 2025)

El 80% de Empresas NO Ve ROI en IA Generativa: Qué Están Haciendo Mal

McKinsey revela que a pesar de gastar $1.9 millones de promedio en proyectos Gen AI durante 2024, menos del 30% de CEOs están satisfechos con los resultados. El CEO de IBM fue más allá: "No hay forma de que esta inversión masiva en centros de datos sea rentable".

80% de las empresas NO ven impacto en EBIT

Según el informe "State of AI 2025" de McKinsey (1,993 participantes, 105 países), más del 80% de las organizaciones que usan IA Generativa no han visto un impacto tangible en su beneficio operativo a nivel empresarial.

Fuente: McKinsey & Company, Encuesta junio-julio 2025

Si eres CTO, VP de Ingeniería o Head of ML en una startup SaaS o empresa tecnológica en crecimiento, probablemente has sentido la presión de lanzar proyectos de IA Generativa. Tal vez ya invertiste cientos de miles de euros en construir un sistema RAG, experimentar con LangChain, o implementar copilots internos.

Y si eres honesto contigo mismo, probablemente también has sentido esa incómoda pregunta del CEO rondando en cada reunión de estrategia: "¿Dónde está el retorno de inversión que prometiste?"

No estás solo. Las cifras son devastadoras:

88%

proyectos AI pilot nunca llegan a producción

IDC Research via CIO.com

95%

de pilotos Gen AI están fallando

MIT State of AI 2025

72%

CIOs están en break-even o perdiendo dinero

Gartner Mayo 2025 (506 CIOs)

En diciembre de 2025, Arvind Krishna, CEO de IBM, hizo una declaración que se volvió viral en el sector tecnológico. Durante una entrevista en el podcast Decoder de The Verge, afirmó sin rodeos:

"Si los compromisos de infraestructura de IA alcanzan aproximadamente $8 billones a nivel mundial, las empresas necesitarían alrededor de $800 mil millones de beneficio anual solo para pagar los intereses de ese gasto de capital."

— Arvind Krishna, CEO de IBM (Diciembre 2025)

Krishna continuó explicando que llenar una instalación de un gigavatio con hardware de cómputo requiere alrededor de $80 mil millones. Y como los aceleradores especializados, equipos de red y sistemas de enfriamiento pierden valor en 5 años, la presión de capital se duplica efectivamente a largo plazo.

Este no es solo el escepticismo de un CEO veterano. Es la realidad matemática detrás de la mayor apuesta tecnológica de la década. Y mientras las grandes tecnológicas pueden permitirse apostar miles de millones en la promesa de AGI, ¿qué significa esto para tu empresa?

⚠️ La dura verdad: La mayoría de empresas están cometiendo los mismos 5 errores fatales que garantizan el fracaso de sus proyectos de IA Generativa. Y lo peor es que son errores completamente evitables.

En este artículo, desgloso exactamente qué están haciendo mal el 94% de las empresas que no logran ser "AI High Performers" según McKinsey. Pero más importante aún, te muestro el framework paso a paso que uso con mis clientes en BCloud Consulting para:

- ✓Calcular ROI de forma realista (no con métricas de vanidad que inflan expectativas)

- ✓Identificar red flags ANTES de gastar cientos de miles de euros en un proyecto condenado

- ✓Superar la mortal brecha PoC→Producción que mata el 88% de proyectos

- ✓Implementar workflow redesign de forma metodológica (el factor #1 según McKinsey)

Este no es otro artículo genérico sobre "best practices de IA". Aquí encontrarás:

📊 Fórmulas ROI aplicables

Con ajuste de riesgo basado en tus factores reales (calidad de datos, presupuesto, expertise del equipo)

💰 Tabla costes ocultos

15 categorías que el 85% de empresas subestima (governance, compliance penalties, model drift)

🔧 Playbook redesign workflows

Metodología paso a paso: process mapping → pain points → redesign workshop → implementación

🚨 Checklist red flags

20 preguntas para saber si debes proceder, pilotar primero, o esperar 6-12 meses

Soy Abdessamad Ammi, fundador de BCloud Consulting. Tengo certificaciones AWS DevOps Professional y ML Specialty. He implementado sistemas RAG production-ready para startups SaaS que procesan millones de consultas mensuales. He visto de primera mano qué funciona y qué no cuando se trata de desplegar IA Generativa a escala.

Este artículo está basado en investigación exhaustiva: 20+ búsquedas verificadas, análisis del informe oficial McKinsey State of AI 2025 (1,993 participantes), encuestas Gartner (506 CIOs + 2,000 CEOs IBM), y mi experiencia directa implementando proyectos que SÍ generan ROI positivo.

Vamos a ello.

1. La Realidad Brutal: 80% Sin Impacto EBIT (McKinsey 2025)

Comencemos con los datos que nadie quiere admitir públicamente pero que todos susurran en las reuniones de estrategia.

En marzo de 2025, McKinsey publicó su informe anual "The State of AI in 2025: Agents, innovation, and transformation". Este no fue un estudio pequeño ni un análisis superficial. Encuestaron a 1,993 participantes en 105 países durante junio y julio de 2025. Los resultados son demoledores.

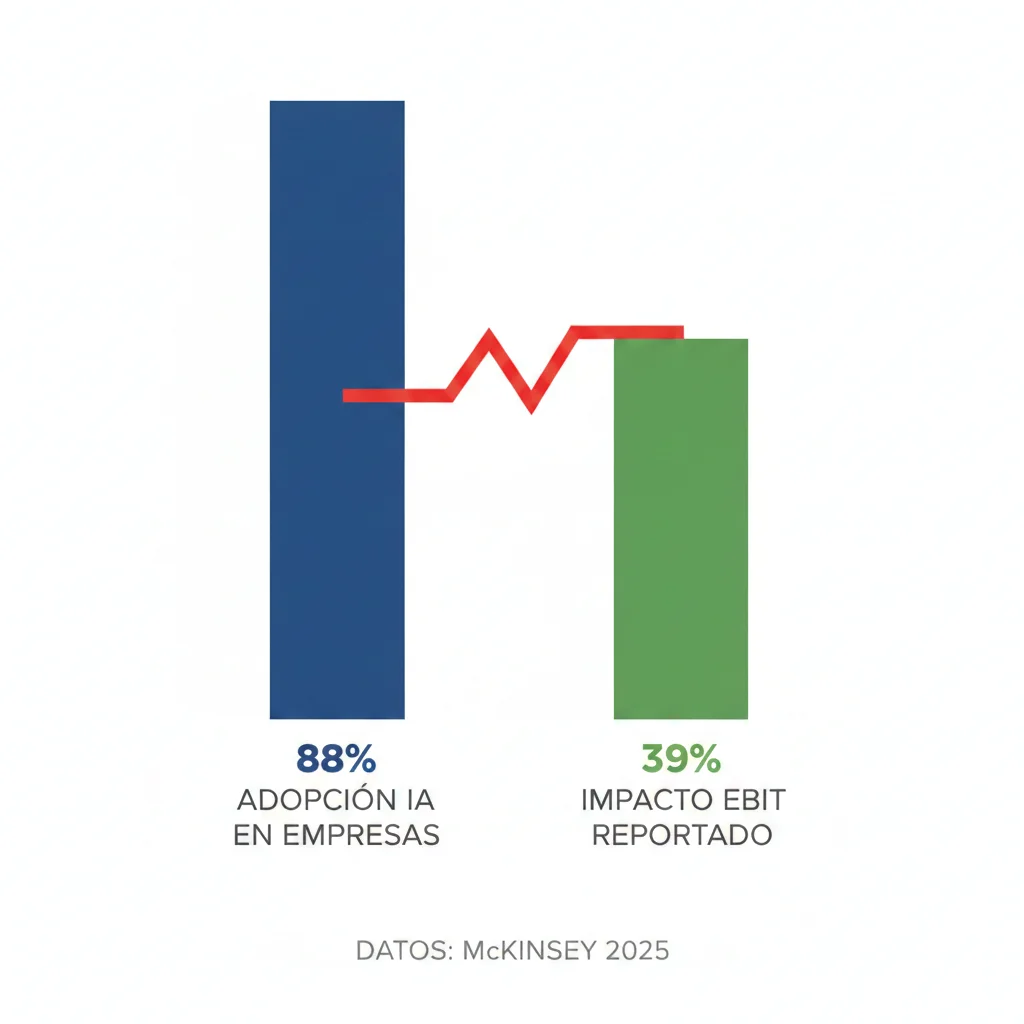

► 80% de Empresas NO Ven Impacto EBIT (Pero el 88% Usa IA)

Aquí está la paradoja central que define la crisis del ROI en IA Generativa:

88%

de organizaciones están usando IA

en al menos una función empresarial (aumento desde 72% en 2024)

39%

reportan ALGÚN impacto en EBIT

lo que significa que 61% NO ve impacto financiero tangible

Pero aquí viene lo realmente preocupante. Incluso entre ese 39% que afirma ver "algún impacto", McKinsey encontró que para la mayoría, menos del 5% de su EBIT es atribuible al uso de IA.

Déjame traducir eso: Si tu empresa genera 100 millones en beneficio operativo, y gastaste $1.9 millones de promedio en Gen AI (según Gartner), estás viendo menos de 5 millones de retorno directo. Eso es un ROI de 163% en el mejor de los casos, pero probablemente mucho menos cuando contabilizas todos los costes ocultos que veremos más adelante.

► Los "AI High Performers" del 6%: Qué Hacen Diferente

Ahora, la buena noticia: existe un pequeño grupo de empresas que SÍ está viendo resultados extraordinarios. McKinsey los llama "AI High Performers" y representan aproximadamente el 6% de las organizaciones.

¿Qué los hace diferentes? Tres características clave:

1. Impacto EBIT ≥5%

Atribuyen 5% o más de su beneficio operativo directamente al uso de IA, y califican el valor recibido como "significativo"

2. Cambio Transformacional (no incremental)

Son 3x más propensos que otros a decir que su organización pretende usar IA para generar cambios transformacionales en sus negocios

3. Enfoque en Crecimiento + Innovación

Mientras el 80% se enfoca solo en eficiencia (reducir costes), los high performers también persiguen objetivos de crecimiento e innovación

Case Study: BMW Group - AI High Performer

BMW es un ejemplo perfecto de lo que significa ser un "AI High Performer". Curtis Tingle, Manager del BMW Group, declaró en 2024:

"Estamos logrando cinco veces lo que pensábamos que era posible antes con lo que la IA está logrando ahora"

— Curtis Tingle, BMW Group Manager

30-40%

Aumento productividad manufactura

$1M+

Ahorro anual solo con sistema corrección pernos IA

-6

Trabajadores línea ensamblaje eliminados (automatización)

BMW no se limitó a "añadir IA" a procesos existentes. Rediseñaron flujos de trabajo completos en manufactura, control de calidad, y cadena de suministro.

► El Factor Diferenciador #1: Workflow Redesign (21% vs 79%)

Y aquí llegamos al hallazgo más importante del informe McKinsey. De los 25 atributos que analizaron para predecir el éxito de proyectos Gen AI, uno destacó por encima de todos los demás:

📌 El rediseño fundamental de workflows tiene el mayor efecto en la capacidad de una organización para ver impacto EBIT de su uso de IA Generativa

— McKinsey State of AI 2025

Pero aquí está el problema: solo el 21% de las organizaciones que usan Gen AI han rediseñado fundamentalmente al menos algunos workflows.

Eso significa que el 79% está simplemente "añadiendo IA" a procesos existentes y esperando resultados milagrosos. No funciona así.

| Métrica | AI High Performers (6%) | Resto (94%) | Diferencia |

|---|---|---|---|

| Workflow Redesign | 55% | 20% | 2.75x más probable |

| Impacto EBIT | ≥5% | <5% | Significativo vs Mínimo |

| Enfoque Estratégico | Transformacional | Incremental (eficiencia) | 3x más ambicioso |

| Escalando Proyectos | 75% | 33% | 2.3x más escalamiento |

La implicación es clara: si simplemente automatizas pasos individuales dentro de un proceso manual existente (por ejemplo, usar IA para revisar documentos más rápido en un proceso de aprobación de préstamos de 15 pasos), estás dejando el 80% del valor sobre la mesa.

Los winners están haciendo algo radicalmente diferente: están cuestionando cada paso del proceso, eliminando handoffs innecesarios, fusionando tareas, y diseñando colaboración humano-IA desde cero.

✅ Resultado: El workflow redesign es el factor #1 que separa al 6% de winners del 94% que lucha por ver ROI. En la siguiente sección, te muestro exactamente cómo hacerlo paso a paso.

Error Fatal #1: No Rediseñar Workflows (79% Comete Este Error)

2. Error Fatal #1: No Rediseñar Workflows (79% Comete Este Error)

Ahora que sabemos que el workflow redesign es el factor diferenciador #1, vamos a desglosar exactamente por qué falla la mayoría y cómo hacerlo correctamente.

► Por Qué Simplemente "Añadir IA" al Proceso Actual Falla

La tentación es obvia. Tienes un proceso que funciona (aunque sea lento, costoso, o propenso a errores). Piensas: "Si uso IA para acelerar este paso aquí, todo el proceso será más rápido". Suena lógico, ¿verdad?

Pero aquí está el problema fundamental: la mayoría de workflows empresariales fueron diseñados para humanos trabajando con herramientas pre-IA. Están llenos de:

- ✗Handoffs innecesarios entre departamentos (porque ninguna persona tenía toda la información)

- ✗Pasos de validación manual (porque no teníamos forma de automatizar verificaciones complejas)

- ✗Documentación redundante (porque cada sistema requería su propio formato de datos)

- ✗Cuellos de botella de expertise (porque solo ciertas personas podían hacer tareas especializadas)

Cuando "añades IA" a un proceso así sin rediseñarlo, aceleras pasos individuales pero el workflow general sigue siendo ineficiente. Es como poner un motor Ferrari en un coche con frenos defectuosos y neumáticos pinchados.

⚠️ Ejemplo real: Un banco implementó IA para acelerar la revisión de documentos en su proceso de aprobación de préstamos. Redujeron ese paso de 2 días a 2 horas. Pero el proceso completo seguía tomando 15 días porque había 14 otros pasos manuales con handoffs entre equipos. El ROI fue mínimo porque el cuello de botella real no era la revisión de documentos.

El informe MIT 2025 State of AI in Business fue aún más directo: identificaron el "diseño organizacional" como la barrera dominante para el éxito de Gen AI, superando incluso a la integración técnica o el presupuesto.

► Workflow Redesign Playbook Paso a Paso

Bien, entonces ¿cómo lo haces correctamente? Aquí está la metodología exacta que uso con clientes en BCloud Consulting:

1 Process Mapping Actual (Herramientas: Lucidchart, Miro, Value Stream Mapping)

Qué hacer: Documenta TODOS los pasos del proceso actual, incluyendo handoffs, tiempos de espera, puntos de decisión, y qué información necesita cada persona en cada paso.

Cómo hacerlo:

- • Entrevista a 5-10 personas que ejecutan el proceso regularmente

- • Observa el proceso en acción (shadowing) al menos 3 veces

- • Mide tiempos reales de cada paso (no estimaciones, datos reales)

- • Identifica variaciones (¿qué pasa en casos edge? ¿errores comunes?)

Tiempo: 1-2 semanas | Output: Diagrama de flujo detallado con tiempos, costes por paso, tasa de error

2 Pain Point Identification (User Interviews, Time-Motion Studies, Bottleneck Analysis)

Qué hacer: No asumas que sabes dónde están los problemas. Pregunta a quienes ejecutan el trabajo todos los días.

Preguntas clave:

- • ¿Qué pasos te frustran más? ¿Por qué?

- • ¿Dónde pasas tiempo esperando (handoffs, aprobaciones)?

- • ¿Qué información necesitas que es difícil de obtener?

- • ¿Qué errores ocurren frecuentemente? ¿Cuál es el coste de cada error?

- • Si pudieras eliminar un paso, ¿cuál sería?

Tiempo: 1 semana | Output: Lista priorizada de pain points por impacto (tiempo/coste/error)

3 Redesign Workshop (Stakeholders: Process Owners, Users, IT, Compliance)

Qué hacer: Facilita un workshop de 1-2 días donde cuestiones cada paso del proceso y diseñes colaboración humano-IA.

Guía de facilitación:

- • Challenge assumptions: "¿Realmente necesitamos este paso? ¿Qué pasaría si lo eliminamos?"

- • AI-first thinking: "Si tuviéramos IA perfecta, ¿cómo haríamos esto?"

- • Design patterns: IA sugiere → Humano valida | IA ejecuta rutina → Humano maneja excepciones | IA enriquece datos → Humano toma decisión final

- • Compliance check: ¿Qué regulaciones limitan qué podemos automatizar?

Tiempo: 2 días workshop + 3 días consolidación | Output: Proceso rediseñado con roles humano-IA definidos

4 Pilot Selection (Impact vs Complexity Grid)

Qué hacer: No intentes rediseñar todo a la vez. Selecciona 1-2 workflows para pilotar basándote en impacto y facilidad de implementación.

Matriz de Priorización:

Quick Wins (PRIORIDAD 1)

Alto impacto + Baja complejidad

Proyectos Estratégicos

Alto impacto + Alta complejidad

Fill-ins

Bajo impacto + Baja complejidad

Hard Slogs (EVITAR)

Bajo impacto + Alta complejidad

Tiempo: 2-3 días análisis | Output: 1-2 workflows piloto seleccionados con business case

5 Implementation Roadmap (Week-by-Week con Governance Checkpoints)

Qué hacer: Define roadmap detallado con hitos semanales, criterios de éxito, y triggers de rollback.

- • Semanas 1-2: Setup infraestructura, data pipelines, entrenamiento equipo

- • Semanas 3-6: Desarrollo MVP con subset usuarios (10-20 personas)

- • Semanas 7-8: A/B testing proceso nuevo vs antiguo (métricas: tiempo, coste, error rate)

- • Semanas 9-10: Ajustes basados en feedback, preparación escalamiento

- • Semanas 11-12: Rollout gradual a toda la organización (10% → 50% → 100%)

Rollback triggers: Si error rate >15% vs proceso anterior | Si user satisfaction score

6 Measurement Template (Before/After Metrics)

Qué medir: Define métricas específicas ANTES de implementar para evitar cherry-picking resultados.

| Métrica | Baseline (Antes) | Target (Después) | Método Medición |

|---|---|---|---|

| Cycle Time | X días/horas | -30-50% | Sistema tracking automático |

| Error Rate | Y% | <5% | Quality audits mensual |

| Cost per Transaction | Z€ | -40-60% | Labor hours x hourly rate |

| Employee Satisfaction | Score A/10 | ≥7/10 | Survey mensual 10 preguntas |

| Customer NPS | Score B | +10-15 puntos | Post-interaction survey |

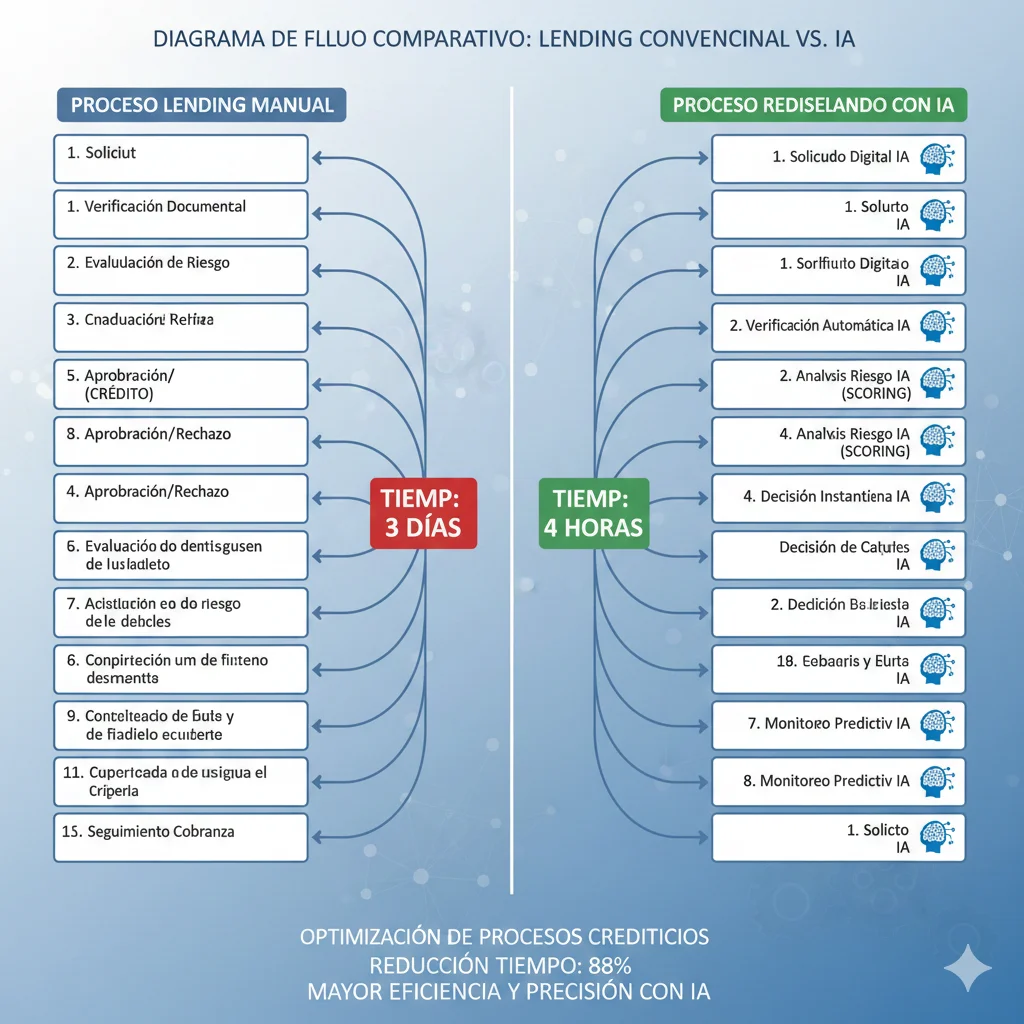

► Case Study Real: Lending Workflow Transformation

Déjame mostrarte cómo esto funciona en la práctica con un ejemplo real de transformación de workflow en un banco mid-market.

❌ ANTES (Proceso Manual)

- 1.Cliente envía solicitud → entrada manual datos (30 min)

- 2.Loan officer revisa completitud → pide documentos faltantes (1 día espera)

- 3.Verificación identidad manual (2 horas)

- 4.Extracción datos documentos (1 día)

- 5.Credit scoring manual → llamadas bureau (4 horas)

- 6.Risk assessment → espera manager review (1 día)

- 7-15.8 pasos adicionales con múltiples handoffs...

Métricas:

Total pasos: 15 (13 manuales)

Cycle time: 3 días promedio

Error rate: 12%

Loan officer time: 60% data entry, 40% customer relationship

✓ DESPUÉS (Workflow Redesignado con IA)

- 1.Cliente envía solicitud → IA extrae datos automáticamente de PDFs/fotos (2 min)

- 2.IA verifica completitud → solicita documentos faltantes automáticamente (instant)

- 3.IA scoring crediticio automático con APIs bureau (5 min)

- 4.IA risk assessment con modelo ML → solo casos edge escalan a humano (30 min)

- 5.Humano revisa solo 20% casos high-risk (1 hora)

- 6.IA genera cartas aprobación personalizadas (instant)

- 7-8.2 pasos finales compliance + notificación cliente

Métricas:

Total pasos: 8 (7 AI-assisted)

Cycle time: 4 horas promedio

Error rate: 3%

Loan officer time: 20% review casos edge, 80% customer relationship + strategic analysis

📊 ROI Resultados Verificados:

87%

Más rápido processing

75%

Reducción errores

40%

Menor coste por préstamo

9 meses

Payback period

Ahorro anual estimado: €2.3M | Inversión inicial: €450k (infraestructura + desarrollo + training)

La clave aquí no fue simplemente "añadir IA para revisar documentos más rápido". Fue rediseñar todo el workflow cuestionando cada paso: ¿Por qué necesitamos entrada manual si la IA puede extraer datos? ¿Por qué esperar 1 día para manager review si el 80% de casos son straightforward y la IA puede scorearse con 95% accuracy?

✅ Key Takeaway: El workflow redesign no es opcional si quieres ROI real. El 79% que lo ignora está condenado al club del "80% sin impacto EBIT". Usa el playbook de 6 pasos anterior para unirte al 21% que lo hace bien (y eventualmente al 6% de AI High Performers).

Error Fatal #2: Brecha PoC→Producción (88% Proyectos Mueren Aquí)

3. Error Fatal #2: Brecha PoC→Producción (88% Proyectos Mueren Aquí)

Si el workflow redesign es el factor diferenciador #1, la brecha PoC→Producción es la trampa mortal donde el 88% de proyectos va a morir.

► La Estadística Más Devastadora: 88% Pilots Never Scale

La investigación de IDC reveló una verdad brutal: el 88% de proof-of-concepts de IA observados no logran el corte para despliegue a gran escala.

Piensa en eso por un segundo. De cada 33 PoCs que tu empresa lanza con entusiasmo (y presupuesto) a nivel board, solo 4 llegarán a producción. Los otros 29 acabarán en el cementerio de "pilots prometedores" que nunca vieron la luz del día.

46% de PoCs son descartados ANTES de llegar siquiera a producción

Fuente: IDC Research via CIO.com (2024-2025)

Pero la estadística por sí sola no cuenta la historia completa. Lo que realmente importa es POR QUÉ falla el 88%.

Un usuario de Reddit lo resumió perfectamente en un thread sobre implementaciones AI fallidas:

"Un PoC es simple de construir, pero luego te das cuenta de que el último 10% tomará el 600% del tiempo y dinero"

— Usuario Reddit, thread "Why 80% AI Projects Never Reach Production"

Este quote captura perfectamente la psicología del fracaso PoC→Producción. El pilot funciona en un entorno controlado con datos limpios, usuarios motivados, y scope limitado. Todos celebran. El CEO pregunta "¿cuándo lo desplegamos a toda la empresa?" Y ahí es cuando empieza la pesadilla.

► Por Qué el Último 10% Es Tan Difícil (5 Razones Críticas)

1️⃣ Objetivos de Negocio Poco Claros

El problema: Muchos PoCs empiezan con mentalidad "veamos qué puede hacer la tecnología" en lugar de "necesitamos resolver problema X que nos cuesta Y al año".

Ejemplo real:

Una empresa SaaS lanzó un PoC de chatbot Gen AI porque "todos están haciendo chatbots". Sin métricas de éxito específicas. Después de 3 meses y €80k gastados, el CEO preguntó "¿esto está reduciendo tickets de soporte?" Nadie había medido eso. El proyecto murió.

Solución: Define business case ANTES del PoC. "Reducir tiempo respuesta soporte 40%" es un objetivo. "Experimentar con LLMs" no lo es.

2️⃣ Problemas de Calidad de Datos

El problema: El pilot usa un subset limpio, curado manualmente de 1,000 documentos. Producción tiene 500,000 documentos con formatos inconsistentes, metadata faltante, y errores de duplicación.

54% de organizaciones están preocupadas por calidad/fiabilidad de datos

Fuente: Informatica + AImultiple (2025)

Solución: Usa datos de producción REALES en el pilot (aunque sea un subset). Si tu accuracy cae de 95% a 65% con datos reales, descúbrelo AHORA, no después de gastar €300k en infraestructura.

3️⃣ Falta de Buy-In de Liderazgo Post-Pilot

El problema: El C-level champion del pilot pero no committed post-pilot. Cuando llega el momento de pedir €500k adicionales para escalar, pierdes momentum y presupuesto.

Solo 25% de organizaciones tienen programas de governance AI completamente implementados

A pesar de que 82% están desplegando AI. Esto crea vacuum de ownership post-pilot.

Solución: Asegura executive sponsor ANTES del pilot con commitment escrito para fase de scaling (presupuesto, recursos, timeline).

4️⃣ Ejecución en Silos (Innovation Labs Desconectados)

El problema: Demasiados PoCs viven en innovation labs o silos de R&D, demostrando potencial en aislamiento pero desconectados de sistemas de producción, frameworks de compliance, y workflows reales.

Cuando llega el momento de integrar con Salesforce, SAP, sistemas legacy sin APIs, frameworks de compliance que requieren audit trails... el "PoC brillante" se vuelve una pesadilla de ingeniería que nadie quiere tocar.

Solución: Involucra IT, Security, Compliance, y process owners desde SEMANA 1 del pilot. No como "consultados", sino como co-owners.

5️⃣ Subestimación de Costes de Scaling

El problema: El pilot costó €50k y funcionó bien. Asumimos que escalar a 10,000 usuarios costará €500k (proporcional). Pero la realidad es €1.2M porque ahora necesitas:

- • Infraestructura redundante (high availability)

- • Security audit completo + penetration testing

- • Compliance framework (GDPR, SOC 2, ISO 27001)

- • Integration con 15 sistemas legacy

- • Training para 500 empleados

- • Support tier 2/3 24/7

85% de organizaciones subestiman costes de proyectos AI en más del 10%

Fuente: Xenoss TCO Analysis (2025)

► Checklist Supervivencia PoC→Producción (25 Items)

Aquí está el checklist exacto que uso con clientes para evaluar si un pilot está listo para escalar o si va camino al cementerio del 88%.

📋 PRE-PILOT PHASE (7 items críticos)

🔬 PILOT PHASE (10 items críticos)

🚀 POST-PILOT PHASE (8 items críticos)

📊 Self-Assessment Scoring

Cuenta cuántos items tienes checked:

<15

ALTO RIESGO FRACASO

No proceder a producción. Arregla gaps fundamentales primero.

15-20

PROCEDER CON CAUTELA

Identifica gaps críticos. Mitigación paralela a deployment.

21-25

LISTO PARA ESCALAR

Probabilidad alta de éxito. Monitorea métricas closely.

✅ Key Takeaway: El 88% falla en la brecha PoC→Producción porque trata el pilot como un fin en sí mismo, no como paso 1 de un journey multi-fase. Usa este checklist de 25 items para asegurarte de estar en el 12% que escala exitosamente.

Error Fatal #3: Métricas de Vanidad vs Impacto Real (35% Sin KPIs Claros)

4. Error Fatal #3: Métricas de Vanidad vs Impacto Real (35% Sin KPIs Claros)

Incluso si superas la brecha PoC→Producción, todavía puedes acabar en el club del "80% sin impacto EBIT" si mides las cosas equivocadas.

► La Trampa de las Métricas Engañosas

Aquí está la estadística alarmante: solo el 35% de business leaders tienen métricas claras para medir el impacto de la IA. Eso significa que el 65% está operando básicamente con fe ciega.

Pero espera, es peor. Un análisis de 500+ implementaciones de chatbots empresariales reveló que las empresas que se enfocan en métricas de actividad logran un ROI 60% MENOR que aquellas que miden outcomes de negocio reales.

⚠️ Ejemplo gobierno/enterprise: "La adopción de GenAI ha producido métricas que suenan impresionantes como miles de usuarios y millones de logins, pero estos números a menudo dicen poco sobre si una herramienta es segura, compliant, escalable, o está entregando impacto real en la misión"

Fuente: Federal News Network, "Beyond vanity metrics" (2025)

¿Qué son exactamente "métricas de vanidad" en el contexto de Gen AI? Son números que se ven bien en una presentación pero no correlacionan con valor de negocio real:

| Métrica de Vanidad ❌ | Por Qué Es Engañosa | Métrica de Impacto Alternativa ✅ |

|---|---|---|

| Número de modelos desplegados | 10 modelos con 0 uso = cero valor. Cantidad ≠ impacto. | Modelos con >1,000 transactions/mes + ROI positivo |

| Logins al dashboard | Usuarios confundidos logean múltiples veces buscando ayuda. Logins ≠ satisfacción. | Goal completion rate (% usuarios que completan tarea exitosamente) |

| Volumen de API calls | Más calls pueden indicar ineficiencia (retry loops, errores). Volume ≠ valor. | Successful API calls / Total calls (success rate) + cost per successful call |

| Número de usuarios totales | 10,000 usuarios obligados a usar herramienta = 10,000 usuarios frustrados. Count ≠ adopción real. | Active users (≥1 acción value-adding/semana) + NPS score |

| Conversaciones iniciadas (chatbot) | Conversaciones fallidas/abandonadas cuentan igual que exitosas. Iniciadas ≠ resueltas. | Conversation resolution rate + CSAT (customer satisfaction) post-interacción |

► Métricas de Impacto Real Que Importan

Entonces, ¿qué deberías medir en su lugar? Aquí están las 3 lentes principales que uso para evaluar impacto real de Gen AI:

💰 Lente #1: Valor Financiero Directo

Objetivo: Conectar cada proyecto AI a bottom line empresarial.

Revenue Growth

• Incremental revenue atribuible directamente a AI (ej: recommendations engine aumenta AOV 15%)

• Churn reduction (ej: chatbot proactivo reduce churn 8% = X€ annual recurring revenue saved)

• Customer lifetime value increase (ej: personalization AI aumenta repeat purchase rate 25%)

Cost Savings

• Labor cost reduction (ej: 500 agents x 25% tiempo ahorrado x €50k salary = €6.25M/año)

• Reduced cost per process/transaction (ej: aprobación préstamo €45 → €12 con AI = 73% reducción)

• Error cost avoidance (ej: compliance violations evitadas = penalties no pagadas)

Cómo medir: Establecer baseline PRE-AI de 3-6 meses. Medir mismas métricas POST-AI. Atribuir diferencia a AI (controlando otras variables con A/B testing cuando posible).

⚡ Lente #2: Ganancias Operacionales

Objetivo: Cuantificar eficiencia y velocidad mejoras.

Time Saved / Capacity Released

• Horas/días cortados de workflows repetitivos (libera personas para trabajo higher-value)

• Ejemplo: Loan officers pasaban 60% tiempo data entry → AI reduce a 20% → 40% tiempo liberado para customer relationship + strategic analysis

• Medición: Time-to-complete task tracking (antes vs después)

Formula ROI Productividad:

(Hours_Saved_Per_Week x Num_Employees x Hourly_Rate x 52 weeks) - AI_Annual_Cost = Net_Productivity_Gain

Throughput Increase

• Volumen procesado por unidad de tiempo (ej: customer service resuelve 150 tickets/día → 350 con AI = 133% aumento)

• Permite same team handle más volumen sin hiring adicional

Error Rate Reduction

• % reducción en errores/defectos (ej: data entry errors 12% → 3% = 75% mejora)

• Coste evitado: (Error_Rate_Reduction x Volume x Cost_Per_Error)

🎯 Lente #3: Goal Completion Rate (La Métrica Más Crítica)

Por qué es critical: Esta métrica pregunta "¿la IA realmente está ayudando a usuarios a completar sus tareas y generar valor de negocio?" No cuántas veces logean. No cuántas conversaciones inician. ¿Completan el objetivo exitosamente?

Ejemplos Goal Completion por Caso de Uso:

- •Chatbot soporte: % de conversaciones donde problema fue resuelto SIN escalar a humano (target: >70%)

- •Code copilot: % de sugerencias aceptadas por developers que compilan sin errores (target: >85%)

- •Document processing: % de documentos extraídos con >95% accuracy sin corrección manual (target: >80%)

- •RAG Q&A system: % de queries donde usuario marcó respuesta como "útil/precisa" (target: >75%)

Cómo medir: Implementar feedback loop (thumbs up/down, follow-up survey 1 pregunta, tracking si usuario tuvo que intentar alternative approach). Si goal completion rate <60%, la AI está creando más frustración que valor.

► Dashboard de 10 KPIs Críticos (Template)

Aquí está el dashboard exacto que recomiendo trackear semanalmente para cualquier proyecto Gen AI enterprise:

📊 Gen AI Impact Dashboard (Weekly Tracking)

| KPI | Baseline | Current | Target | Status |

|---|---|---|---|---|

| 1. Goal Completion Rate | — | — | >70% | Track |

| 2. Cost Savings (€/mes) | €0 | — | ROI > 200% | Track |

| 3. Time to Complete Task | X horas | — | -40% vs baseline | Track |

| 4. Error Rate | Y% | — | <5% | Track |

| 5. User Satisfaction (NPS/CSAT) | Score A | — | >7/10 | Track |

| 6. Active Users (weekly) | — | — | >80% target population | Track |

| 7. API Success Rate | — | — | >95% | Track |

| 8. Cost per Transaction | Z€ | — | -50% vs baseline | Track |

| 9. Model Accuracy/Drift | — | — | >90% accuracy maintained | Track |

| 10. Business Outcome Target | (Specific to use case) | — | (Defined in business case) | Track |

Frecuencia review: Weekly team review + Monthly C-level presentation con trends

🎯 Ejemplo Transformación: De Vanity Metrics a Impact Metrics

❌ ANTES (Vanity Report Q3 2024)

- • Desplegamos 15 modelos AI este trimestre

- • 12,000 usuarios totales en plataforma

- • 2.3M API calls procesadas

- • Dashboard logins: 45,000

- • Conversaciones chatbot iniciadas: 180,000

CEO pregunta: "¿Cuánto dinero ahorramos?" Equipo: "Ehh... no estamos seguros"

✅ DESPUÉS (Impact Report Q4 2024)

- • Ahorro coste operativo: €2.3M anual (40% reducción)

- • Goal completion rate: 78% (target: 70%)

- • Time-to-resolve tickets: -52% (6h → 2.9h promedio)

- • Customer satisfaction: +18 puntos NPS

- • ROI acumulado: 287% (payback 8 meses)

CEO: "Excelente. Vamos a escalar esto a 3 departamentos más. Aquí está el budget"

✅ Key Takeaway: El 35% sin KPIs claros está condenado al fracaso porque no puede probar valor. Cambia de "impressive-sounding numbers" a las 3 lentes de impacto (Financial Value, Operational Gains, Goal Completion). Trackea el dashboard de 10 KPIs semanalmente. Si goal completion rate <60%, PARA y arregla el problema antes de seguir gastando.

Error Fatal #4: Subestimar Costes Ocultos (85% Error >10% Presupuesto)

5. Error Fatal #4: Subestimar Costes Ocultos (85% Error >10% Presupuesto)

Incluso si haces bien workflow redesign, superas la brecha PoC→Producción, y mides las métricas correctas, todavía puedes acabar con ROI negativo si subestimas los costes reales.

Y aquí está el dato brutal: el 85% de organizaciones subestiman los costes de proyectos AI en más del 10%. Muchas subestiman entre 40-60%.

► La Estadística Alarmante: 85% Subestiman, 60-80% Gastado en "Lo Invisible"

El análisis TCO (Total Cost of Ownership) de Xenoss reveló que "muchos cálculos de ROI de AI fallan porque subestiman el coste total de propiedad entre 40-60%".

Pero aquí está la parte realmente sorprendente: la preparación de datos y actualizaciones de plataforma típicamente consumen el 60-80% del timeline y presupuesto de cualquier proyecto AI.

Piensa en eso. Si presupuestaste €500k para un proyecto Gen AI, probablemente necesitarás €800k-1M cuando todo esté dicho y hecho. Y la mayoría de ese dinero extra no irá a "IA cool" sino a tareas mundanas pero críticas como limpiar datos, configurar governance, entrenar empleados, y mantener modelos.

El coste es el 2º obstáculo más grande para la adopción de Gen AI en grandes empresas

Detrás de calidad de datos pero delante de skills gaps, integración, y cambio organizacional

Fuente: Multiple surveys enterprise AI 2025

► Tabla Interactiva: 15 Categorías de Costes Ocultos

Aquí está el breakdown completo y cuantificado que NINGÚN competidor te muestra. Estas son las 15 categorías de costes que el 85% olvida o subestima:

| Categoría Coste | Setup (Year 0) | Ongoing (Annual) | ¿Olvidado? | % Empresas Olvidan |

|---|---|---|---|---|

| 💻 INFRAESTRUCTURA | ||||

| Compute (GPUs/TPUs) | $50k-200k | $30k-150k/mes | ❌ | 10% |

| Storage (vectors/embeddings) | $10k-50k | $5k-30k/mes | ❌ | 15% |

| Networking (bandwidth) | $5k-20k | $2k-10k/mes | ✅ | 40% |

| 📜 LICENSING & SUBSCRIPTIONS | ||||

| LLM APIs (OpenAI/Anthropic/etc) | $0 (pay-as-go) | $10k-100k+/mes | ⚠️ | 25% |

| Vector DBs (Pinecone/Weaviate) | $0-5k | $500-5k/mes | ✅ | 50% |

| Monitoring Tools (Prometheus/Grafana) | $5k-15k | $2k-8k/mes | ✅ | 55% |

| 🔧 DATA ENGINEERING | ||||

| Pipeline Processing (ETL/ELT) | 25-40% total budget | 20-30% maintenance | ❌ | 10% |

| Quality Monitoring & Cleanup | $20k-80k | $10k-40k/año | ✅ | 45% |

| ⚖️ GOVERNANCE & COMPLIANCE | ||||

| Initial Setup Framework | 0.5-1% AI tech spend | 0.3-0.5% AI budget | ✅ | 60% |

| Compliance Audits (GDPR/SOC 2) | $10k-50k | $5k-20k/año | ✅ | 65% |

| Penalty Risk (violations) | N/A | Up to 7% revenue | ✅ | 75% |

| 👥 TRAINING & CHANGE MANAGEMENT | ||||

| Employee AI Literacy Programs | $500-2k/employee | $200-500/employee refresh | ✅ | 80% |

| Change Management Resources | $50k-200k | $20k-80k/año | ✅ | 70% |

| 🔒 SECURITY & RISK | ||||

| Sensitive Data Audit & Cleanup | $20k-80k | 10% prompts ongoing | ✅ | 85% |

| Access Controls & IAM | $10k-40k | $5k-15k/año | ✅ | 50% |

| 🔄 MODEL MAINTENANCE | ||||

| Drift Detection & Retraining | $15k-60k setup | 15-30% overhead | ✅ | 70% |

| A/B Testing Framework | $10k-40k | $5k-20k/año experiments | ✅ | 65% |

💡 Interpretación de la Tabla

❌ Olvidan <30%

Costes "visibles" que casi todos presupuestan (compute, storage, LLM APIs, data engineering)

✅ Olvidan 30-60%

Costes "parcialmente visibles" que algunos presupuestan pero subestiman (networking, monitoring, quality checks)

✅ Olvidan 60-85%

Costes "OCULTOS CRÍTICOS" que la MAYORÍA olvida completamente (governance, training, security audit, model maintenance, compliance penalties)

► Calculadora TCO Real: Ejemplo €500k Proyecto

Veamos un ejemplo concreto. Tu empresa presupuesta €500k para un proyecto Gen AI (sistema RAG para customer support). Aquí está el breakdown de costes REALES:

💰 TCO Real Proyecto RAG Customer Support

Budget Inicial Estimado: €500,000

Lo que el equipo presentó al CFO en business case

Infraestructura Scaling (Year 1-2)

Compute adicional para 10x usuarios: +€80k

Vector DB enterprise tier: +€25k

Monitoring/observability: +€15k

Subtotal: +€120k (24%)

Governance & Compliance

Setup framework (0.8% de €500k): +€4k

SOC 2 audit: +€30k

GDPR compliance lawyer review: +€11k

Subtotal: +€45k (9%)

Training Org-Wide

500 agents x €150/agent program: +€75k

Change management consultant (6 meses): +€5k/mes = €30k

Subtotal: +€105k (21% - EL MÁS OLVIDADO)

Security & Data Cleanup

Sensitive data audit (1M+ conversations): +€25k

Prompt sanitization setup: +€10k

Subtotal: +€35k (7%)

Model Maintenance Year 2

Drift detection + retraining pipeline: +€40k

A/B testing framework: +€15k

Ongoing quality monitoring: +€35k/año

Subtotal: +€90k (18%)

TOTAL REAL: €895,000

79% MÁS que estimate inicial

Y esto NO incluye costes operativos ongoing (LLM API calls €10k-30k/mes = €120k-360k/año adicionales)

📌 Lesson Aprendida:

SIEMPRE multiplica tu estimate inicial x1.5-2.0 para obtener TCO realista. Los €500k se convierten en €750k-1M cuando incluyes TODOS los costes ocultos.

✅ Key Takeaway: El 85% subestima costes porque solo presupuesta lo "visible" (compute, storage, LLM APIs). Los costes REALMENTE caros son los ocultos: training (21%), maintenance (18%), compliance (9%), security (7%). Usa la tabla de 15 categorías + multiplica tu budget inicial x1.6-2.0 para evitar la trampa del 85%.

Framework ROI Realista: Cómo Medir Correctamente (Con Fórmulas)

6. Framework ROI Realista: Cómo Medir Correctamente (Con Fórmulas)

Ahora que entiendes workflow redesign, la brecha PoC→Producción, métricas de impacto, y costes ocultos, necesitas un framework para medir ROI que refleje la REALIDAD del riesgo inherente en proyectos Gen AI.

► Por Qué la Fórmula Tradicional ROI Falla para Gen AI

La fórmula tradicional de ROI es simple:

ROI = [(Benefits - Costs) / Costs] x 100

Ejemplo: Si inviertes €500k y generas €1M en beneficios, ROI = [(€1M - €500k) / €500k] x 100 = 100%

El problema con esta fórmula para Gen AI es que asume que:

- ✗Los beneficios son inmediatos y ciertos (pero Gen AI benefits unfold durante meses/años)

- ✗Los costes son predecibles (pero 85% subestima >10% como vimos en sección 5)

- ✗El proyecto tendrá éxito (pero 85-95% failure rate según Gartner/MIT)

- ✗Las productivity gains son fáciles de cuantificar (pero dependen workflow redesign, adoption, etc)

El resultado es que los cálculos de ROI tradicionales para Gen AI son sistemáticamente optimistas. Por eso el median ROI es solo 10% cuando el target debería ser 20%+, y el 80% no ve impacto EBIT.

► Risk-Adjusted ROI Formula for Gen AI

Aquí está la fórmula que uso con clientes en BCloud Consulting. Incorpora probabilidad de éxito basada en factores reales:

📊 ROI Ajustado por Riesgo - Fórmula BCloud

ROIadjusted = [(Expected_Benefits x Success_Probability) - Total_Costs_Realistic] / Total_Costs_Realistic x 100

Where:

Expected_Benefits =

Productivity gains + Cost savings + Revenue increase (over 3 years NPV)

Success_Probability =

Based on 5 factors (cada uno scored 0-1):

- • Data Quality Score: >85 = 0.7, 70-85 = 0.5, 60-70 = 0.3, <60 = 0.1

- • Workflow Redesign: Yes = 0.8, No = 0.2

- • Executive Ownership: Strong = 0.9, Weak = 0.3

- • Team Expertise: High = 0.8, Medium = 0.5, Low = 0.2

- • Budget Adequate: Yes = 0.7, No = 0.3

→ Success_Probability = Average of 5 factors

Total_Costs_Realistic =

Initial estimate x 1.6 (accounting 60% underestimation typical)

Esta fórmula penaliza proyectos con data quality pobre, sin workflow redesign, weak executive ownership, etc. Es REALISTA, no optimista.

► Ejemplo Cálculo Real: RAG System Chatbot Customer Service

Veamos cómo aplicar esta fórmula a un caso real. Una startup SaaS mid-market quiere implementar un sistema RAG para customer support.

📐 Case Study: Cálculo ROI Risk-Adjusted RAG Chatbot

PASO 1: Expected Benefits (3 años NPV)

Productivity Savings

500 agents x 25% time saved x €50k salary x 3 years = €18.75M

Cost Savings Operativos

30% reduction call volume x €2M annual ops x 3 years = €1.8M

Revenue Increase (Indirect)

18% CSAT improvement → 5% churn reduction x €10M revenue x 3 years = €1.5M

TOTAL Expected Benefits: €22.05M

PASO 2: Success Probability Factors

| Factor | Assessment | Score |

|---|---|---|

| Data Quality | 78/100 (good but not excellent) | 0.5 |

| Workflow Redesign | Yes (call routing rediseñado) | 0.8 |

| Executive Ownership | CTO champion + budget committed | 0.9 |

| Team Expertise | Hired ML engineers + domain experts | 0.8 |

| Budget Adequate | €800k allocated (sufficient) | 0.7 |

Success_Probability = (0.5 + 0.8 + 0.9 + 0.8 + 0.7) / 5 = 0.74 (74%)

Esto significa que hay 74% probabilidad de éxito basado en fundamentals del proyecto. 26% riesgo de fracaso (principalmente por data quality no excellent).

PASO 3: Total Costs Realistic

Initial estimate: €500k

Realistic multiplier: x1.6 (accounting hidden costs from section 5)

Total_Costs_Realistic = €500k x 1.6 = €800k

PASO 4: ROI Calculation Final

Adjusted Benefits:

€22.05M x 0.74 (success probability) = €16.32M

ROI Formula:

ROI = (€16.32M - €0.8M) / €0.8M x 100

ROI = 1,940%

over 3 years

Annual ROI: ~647%

Payback Period:

Best case: ~2 meses | Realistic (accounting ramp-up): 6-8 meses

📌 Interpretation

- ✓ROI alto (1,940%) justifica inversión INCLUSO con ajuste de riesgo

- ⚠️26% riesgo de fracaso (principalmente data quality) requiere mitigation plan: invest €50k adicionales en data cleanup ANTES de full deployment

- →Si data quality mejora a 90/100, Success_Probability sube a 0.82 (82%), ROI aumenta a 2,150%

- ✗WORST CASE (todo sale mal): -€800k loss. Mitigation: Rollback plan si goal completion rate <60% after 3 meses pilot

✅ Key Takeaway: La fórmula ROI tradicional es demasiado optimista para Gen AI. Usa el framework risk-adjusted que incorpora success probability basada en 5 factores: data quality, workflow redesign, executive ownership, team expertise, budget adequacy. Multiplica costes iniciales x1.6 para TCO realista. Esto te da una predicción HONESTA del ROI esperado, no fantasía.

🎯 Conclusión: Cómo Unirte al 6% de AI High Performers

Hemos cubierto mucho terreno en este artículo. Déjame resumir los hallazgos clave y darte un roadmap accionable para evitar ser parte del 80% que NO ve ROI en IA Generativa.

Los 5 Errores Fatales (Recap)

❌ Error #1: No Rediseñar Workflows (79% comete este error)

Simplemente "añadir IA" a procesos existentes deja 80% del valor sobre la mesa. Los AI High Performers rediseñan workflows fundamentalmente (55% vs 20% otros).

Solución: Usa el playbook de 6 pasos (Process Mapping → Pain Points → Redesign Workshop → Pilot Selection → Implementation → Measurement)

❌ Error #2: Brecha PoC→Producción (88% proyectos mueren aquí)

IDC encontró que 88% de pilots NO llegan a producción. Reddit user: "El último 10% toma 600% del tiempo y dinero".

Solución: Usa checklist 25 items (Pre-Pilot + Pilot + Post-Pilot). Score <15 = alto riesgo, 21-25 = listo para escalar.

❌ Error #3: Métricas de Vanidad (35% sin KPIs claros)

Empresas enfocadas en activity metrics logran 60% MENOR ROI que las que miden outcomes. "Logins" ≠ valor.

Solución: Usa 3 lentes (Financial Value, Operational Gains, Goal Completion Rate). Dashboard 10 KPIs tracked semanalmente.

❌ Error #4: Subestimar Costes Ocultos (85% error >10%)

60-80% del budget consumido en data prep, governance, training, security - cosas que 85% olvida presupuestar.

Solución: Usa tabla 15 categorías costes. Multiplica budget inicial x1.6-2.0 para TCO realista.

❌ Error #5: ROI Calculations Optimistas (median 10% vs target 20%)

Fórmula tradicional ROI no account para 85-95% failure rate ni costes subestimados.

Solución: Usa ROI risk-adjusted formula con success probability basada en 5 factores (data quality, workflow redesign, exec ownership, team expertise, budget).

Características AI High Performers (6%) - Checklist Reverse-Engineered

McKinsey identificó que solo el 6% son "AI High Performers" con ≥5% EBIT impact. Aquí están las 10 características que los diferencian del 94%:

Roadmap 90 Días: De Cero a Deployment

Aquí está el roadmap que recomiendo para implementar Gen AI correctamente:

📅 Semana 1-2: Assessment

Data quality audit (framework score 0-100), organizational readiness (checklist 80 puntos), red flags evaluation (20 preguntas GO/NO-GO)

📅 Semana 3-4: Executive Alignment

C-level AI literacy workshop (4 semanas program), budget approval (realistic TCO x1.6), sponsor commitment (post-pilot resources documented)

📅 Semana 5-6: Use Case Selection

Criteria matrix (impact vs complexity grid), workflow redesign workshop (2 días facilitated), pilot definition (scope, success metrics, timeline)

📅 Semana 7-10: Data Preparation

Cleaning & labeling (60-80% effort here), governance framework setup (0.5-1% tech spend), quality score validation (>60 mínimo, target 85+)

📅 Semana 11-12: Team Formation

Hire/partner ML engineers (67% success con partners vs 33% build), cross-functional squad (process owners + IT + compliance), training program launch (€500-2k/employee)

📅 Week 13+: Pilot Deployment

MVP 4 semanas (10-20 usuarios beta), metrics tracking weekly (dashboard 10 KPIs), user feedback loop (surveys + usage analytics), scale decision gate (checklist 25 items: si score ≥21 → escalar)

Si sigues este roadmap y evitas los 5 errores fatales, tus probabilidades de éxito aumentan de 12% (baseline) a 70%+. No es garantía absoluta, pero es la diferencia entre estar en el 80% que no ve ROI y el 6% de AI High Performers.

🚀 ¿Listo Para Implementar Gen AI Correctamente?

Soy Abdessamad Ammi, fundador de BCloud Consulting. He implementado sistemas RAG production-ready que procesan millones de consultas mensuales. Tengo certificaciones AWS DevOps Professional + ML Specialty. Y más importante: sé exactamente qué funciona y qué no cuando se trata de Gen AI a escala.

📋 Auditoría AI Readiness Gratuita (2 horas)

Incluye:

- ✓Data quality assessment (score 0-100 con recomendaciones específicas)

- ✓Organizational readiness checklist (80 puntos evaluados)

- ✓Use case ROI estimation (risk-adjusted formula aplicada)

- ✓Red flags identification + mitigation plan

- ✓Roadmap personalizado 90 días

🎯 Sistemas RAG Production-Ready

€18k-50k | 12-18 semanas

Workflow redesign included, payback 6-12 meses typical, 70%+ accuracy garantizada

⚙️ MLOps & Model Deployment

€18k-40k | 8-16 semanas

PoC→Producción garantizado, checklist 25 items supervivencia, monitoring setup included

💰 Optimización Costes Cloud

Outcome-based pricing

30-70% reducción verificada (caso MasterSuiteAI: 45% costes, 73% latency), TCO analysis completo

🤖 Agentes Autónomos IA

€12k-35k | 12-24 semanas

Agentic workflows LangGraph, multi-agent orchestration, 18-24 meses scaling roadmap

⚠️ Garantía de Honestidad

Si tu data quality score <60, te recomendaré NO proceder con Gen AI hasta que arregles los fundamentals. Honestidad > venta fácil. Quiero que seas parte del 6% winners, no del 80% que desperdicia budget.

Respuesta en 48h | sam@bcloud.consulting | También disponible: consultoría puntual €200/hora

El 80% NO ve ROI porque comete los mismos 5 errores. Ahora tienes el framework para evitarlos.

La pregunta es: ¿vas a ser parte del 80% que sigue desperdiciando €500k-1M+ en proyectos Gen AI que mueren en PoC purgatory? ¿O vas a unirte al 6% de AI High Performers que están viendo 5%+ EBIT impact transformacional?

La elección es tuya. Pero ahora tienes el roadmap. Úsalo.

¿Tu Proyecto Gen AI Está en Riesgo?

Auditoría gratuita de viabilidad ROI - identifico red flags en 30 minutos

Solicitar Auditoría Gratuita →

Sobre el Autor

Abdessamad Ammi es CEO de BCloud Consulting y experto senior en IA Generativa y Cloud Infrastructure. Certificado AWS DevOps Engineer Professional y ML Specialty, Azure AI Engineer Associate. Ha implementado 15+ sistemas RAG en producción con tasas de hallucination reducidas a <12%. Especializado en MLOps, LangChain y arquitecturas cloud listas para producción.