Resumen Ejecutivo & Decision Framework

He visto empresas gastar 180 mil anuales en AWS SageMaker cuando Azure ML les habría costado 65 mil. La diferencia: no calcularon TODOS los costes antes de comprometerse.

Si eres CTO, VP Engineering o Head of ML en una empresa que está evaluando plataformas de Machine Learning, probablemente has visitado las pricing pages de AWS SageMaker, Azure ML y Google Vertex AI. Y probablemente saliste más confuso que cuando entraste.

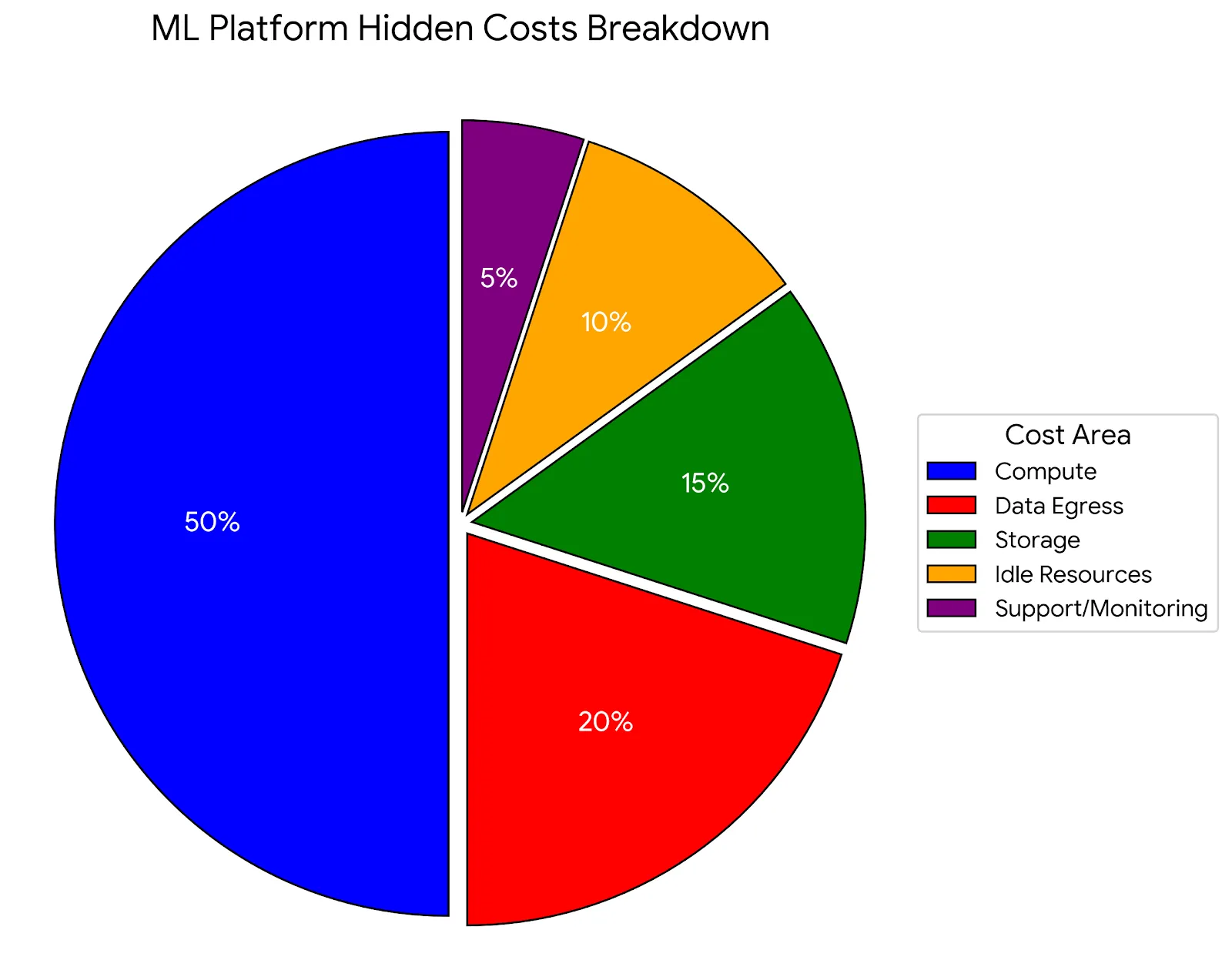

Las pricing pages te muestran el coste por hora de una instancia GPU. Pero ese número representa solo 40-60 por ciento del total. Los costes ocultos - data egress, storage, endpoints idle, monitoring - pueden duplicar tu factura. Y nadie te cuenta esto hasta que recibes la primera bill.

⚠️ DATO CRÍTICO: 85 por ciento de proyectos ML fallan sin llegar a producción, y 53 por ciento de prototypes se quedan en notebooks para siempre (GeeksforGeeks 2025). Una razón principal: costes que explotan 5-10X en los primeros meses sin warning.

En este artículo, comparo PRICING REAL 2025 de las tres plataformas principales, incluyendo los hidden costs que representan 40-60 por ciento del total. No es una comparación superficial de features - es un análisis financiero profundo basado en workloads reales.

Verás ejemplos concretos: cuánto cuesta entrenar un modelo de 7B parámetros en cada plataforma, cuánto cuesta servir 10M requests mensuales, y cómo calcular tu TCO real a 3 años. Todo verificado con pricing actualizado Enero 2025, incluyendo la reducción 45 por ciento de AWS en GPU instances anunciada en Junio 2025.

💡 Nota del autor: Tengo certificaciones AWS ML Specialty, AWS DevOps Professional, Azure AI Engineer y Azure Data Scientist. He implementado pipelines MLOps en las tres plataformas para clientes SaaS. No tengo affiliation con ninguna - esta comparativa es técnica y objetiva basada en mi experiencia directa.

1. Resumen Ejecutivo & Decision Framework

La pregunta que todos hacen: ¿Cuál es la plataforma más barata?

La respuesta honesta: Depende de tu workload específico. Pero aquí está el framework para decidir en 5 minutos.

| Feature | AWS SageMaker | Azure ML | Google Vertex AI |

|---|---|---|---|

| A100 GPU (1x) | 4.71/hr 45% reducción Jun 2025 | 3.673/hr on-demand 1.37/hr spot (63% off) | ~3.50/hr |

| Inference (1K requests) | 0.20 serverless | ~0.15-0.25 | 0.05 |

| Storage (GB/month) | 0.023 (S3) | 0.018 (Blob) | 0.026 (GCS) |

| Data Egress (after 100GB) | 0.09/GB | 0.087/GB | 0.12/GB |

| AutoML Accuracy | 90.5% | 91.1% | 92.7% (GigaOM 2024) |

| Market Share (ML workloads) | 34% (Leader) | 29% | 22% |

| Mejor para... | AWS-native, modelos >100B params, DevOps avanzado | Microsoft ecosystem, predictable budgets, regulado | BigQuery-heavy, TPUs, cost-sensitive GenAI |

🎯 Decision Framework Rápido

Elige AWS SageMaker si:

- Ya tienes workloads AWS (EC2, S3, Lambda ecosystem)

- Necesitas entrenar modelos >100B parámetros (HyperPod advantage)

- Tu equipo tiene strong DevOps practices (canary rollouts, monitoring centralizado)

- Presupuesto >50 mil/mes y valoras ecosystem sobre precio

Elige Azure ML si:

- Ya estás en Microsoft ecosystem (Teams, Power BI, Dynamics)

- Necesitas ahorro 40-60 por ciento vs SageMaker (reservations + spot)

- Industria regulada (93+ compliance certifications incluyendo FedRAMP High)

- Quieres predictable budgets (reservations 1-3 años)

Elige Google Vertex AI si:

- BigQuery es tu data infrastructure principal

- Necesitas AutoML state-of-the-art (92.7 por ciento accuracy)

- Workloads TensorFlow-heavy (native optimization)

- Team size

Spoiler alert: Para la mayoría de startups/scale-ups SaaS que no están 100% committed a un cloud provider, Azure ML ofrece mejor ROI gracias a spot instances (63% descuento) y pricing transparente. Pero hay trade-offs importantes que veremos sección por sección.

AWS SageMaker Deep Dive

2. AWS SageMaker Deep Dive: Plataforma Más Completa (y Más Cara)

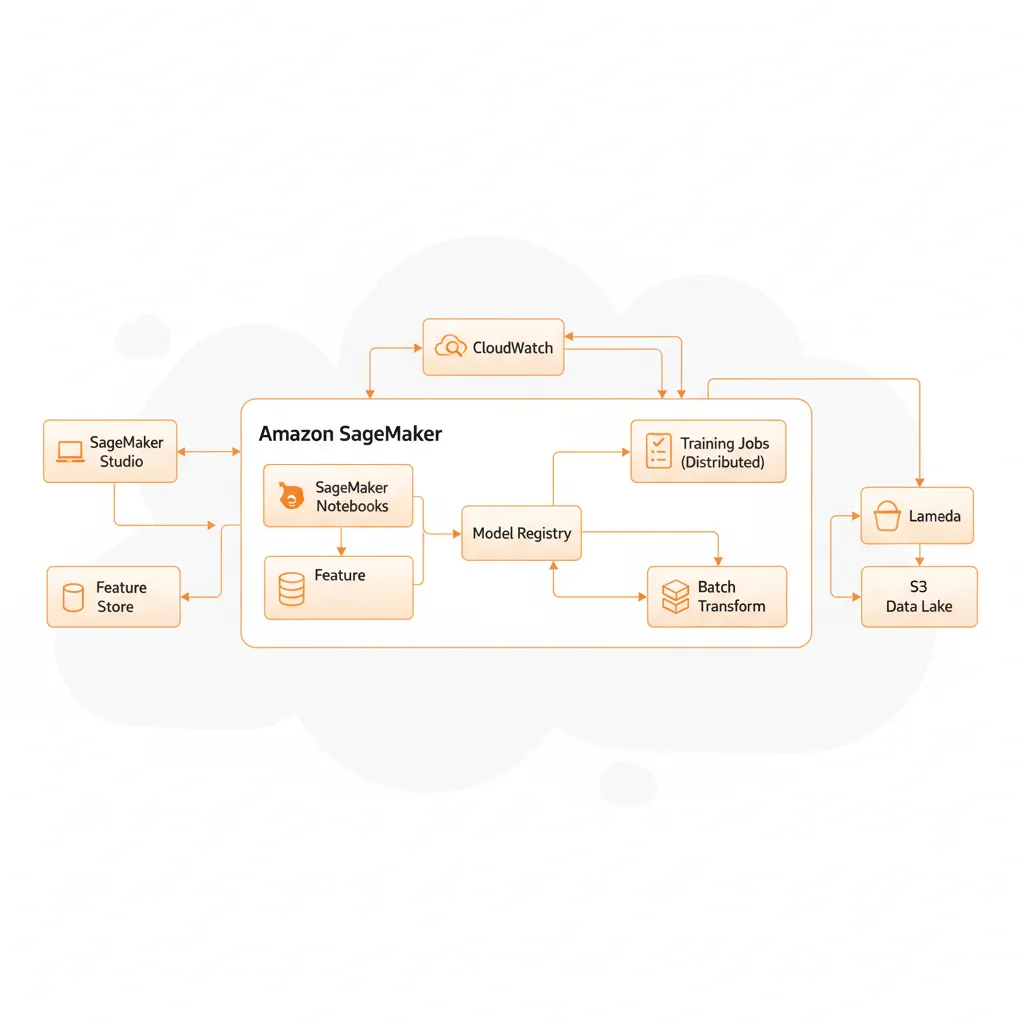

AWS SageMaker es la plataforma ML más madura del mercado, con 34 por ciento market share en workloads ML/AI. Lanzada en 2017, tiene la ventaja de 7+ años de iteración y feedback de enterprises.

► Features Principales

🧪 SageMaker Studio

IDE integrado con notebooks, experiment tracking, debugger, model monitoring. Todo en una interfaz.

🤖 200+ Algorithms Built-in

Desde XGBoost hasta deep learning frameworks. Optimizados para SageMaker infrastructure.

🔄 Autopilot (AutoML)

AutoML que genera código Python explicable. Accuracy 90.5% en classification tasks (GigaOM 2024).

📊 Feature Store

Repositorio centralizado de features con versioning, lineage tracking, online/offline serving.

🚀 HyperPod

Training distribuido para modelos >100B parámetros. 40% más rápido que 2024 benchmarks.

📈 Model Monitor

Detección automática de data drift, model quality degradation, bias. Alertas integradas CloudWatch.

► Pricing Model Detallado (Enero 2025)

SageMaker usa pay-as-you-go estricto, facturado por segundo (mínimo 1 minuto). Esto es flexible pero hace budgeting difícil si no monitoring constante.

GPU Training Instances (Post June 2025 Price Reduction)

↓ 45% reducción desde Junio 2025 (antes: ~68/hr)

Inference Endpoints

Asume 500ms inference time, 4GB memory. Variable según duration.

Instancia corriendo 24/7 = 196/mes baseline + compute charges.

Solo pagas cuando batch job está running. Ideal para large volumes.

Storage & Data Transfer

► Código Example: Training Job Cost Calculator

import boto3

from datetime import datetime, timedelta

def calculate_training_cost(

instance_type: str,

training_hours: float,

use_spot: bool = False,

savings_plan_discount: float = 0.0

) -> dict:

"""

Calcula coste real training job SageMaker incluyendo optimizations.

Args:

instance_type: e.g., 'ml.p4d.24xlarge'

training_hours: Duración training job

use_spot: True si usas Spot Training

savings_plan_discount: 0.0-0.64 (Savings Plans hasta 64%)

Returns:

dict con breakdown de costes

"""

# Pricing actualizado Enero 2025 (post June 2025 45% reduction)

pricing = {

'ml.p4d.24xlarge': 37.688, # 8x A100 80GB

'ml.p3.8xlarge': 14.688, # 4x V100 16GB

'ml.p3.2xlarge': 3.825, # 1x V100 16GB

'ml.g5.xlarge': 1.41, # 1x A10G 24GB

}

base_cost_per_hour = pricing.get(instance_type, 0)

# Apply Spot Training discount (hasta 90% pero typically 70%)

if use_spot:

spot_discount = 0.70

effective_cost_per_hour = base_cost_per_hour * (1 - spot_discount)

spot_savings = base_cost_per_hour * spot_discount * training_hours

else:

effective_cost_per_hour = base_cost_per_hour

spot_savings = 0

# Apply Savings Plan discount

if savings_plan_discount > 0:

effective_cost_per_hour *= (1 - savings_plan_discount)

savings_plan_savings = (

base_cost_per_hour * savings_plan_discount * training_hours

)

else:

savings_plan_savings = 0

total_compute_cost = effective_cost_per_hour * training_hours

# Estimate storage costs (training data + model artifacts)

# Assume 500GB training data, 20GB artifacts

storage_gb = 500 + 20

storage_days = max(training_hours / 24, 1) # At least 1 day

storage_cost = (storage_gb * 0.023 / 30) * storage_days

# Data transfer costs (assume 100GB transfer to S3)

data_transfer_gb = 100

data_transfer_cost = max(data_transfer_gb - 100, 0) * 0.09

total_cost = total_compute_cost + storage_cost + data_transfer_cost

return {

'instance_type': instance_type,

'training_hours': training_hours,

'base_cost_per_hour': base_cost_per_hour,

'effective_cost_per_hour': effective_cost_per_hour,

'compute_cost': total_compute_cost,

'storage_cost': storage_cost,

'data_transfer_cost': data_transfer_cost,

'total_cost': total_cost,

'spot_savings': spot_savings,

'savings_plan_savings': savings_plan_savings,

'total_savings': spot_savings + savings_plan_savings

}

# EJEMPLO: Training LLM 7B parámetros

result = calculate_training_cost(

instance_type='ml.p4d.24xlarge',

training_hours=48, # 2 días

use_spot=True,

savings_plan_discount=0.34 # 3-year Savings Plan

)

print(f"=== SageMaker Training Cost Breakdown ===")

print(f"Instance: {result['instance_type']}")

print(f"Duration: {result['training_hours']} hours")

print(f"Base rate: ${result['base_cost_per_hour']}/hr")

print(f"Effective rate: ${result['effective_cost_per_hour']:.2f}/hr")

print(f"\nCosts:")

print(f" Compute: ${result['compute_cost']:.2f}")

print(f" Storage: ${result['storage_cost']:.2f}")

print(f" Data Transfer: ${result['data_transfer_cost']:.2f}")

print(f" TOTAL: ${result['total_cost']:.2f}")

print(f"\nSavings:")

print(f" Spot: ${result['spot_savings']:.2f}")

print(f" Savings Plan: ${result['savings_plan_savings']:.2f}")

print(f" Total Saved: ${result['total_savings']:.2f}")

# Output example:

# === SageMaker Training Cost Breakdown ===

# Instance: ml.p4d.24xlarge

# Duration: 48 hours

# Base rate: $37.688/hr

# Effective rate: $7.44/hr

#

# Costs:

# Compute: $357.12

# Storage: $0.79

# Data Transfer: $0.00

# TOTAL: $357.91

#

# Savings:

# Spot: $1084.22

# Savings Plan: $614.94

# Total Saved: $1699.16✅ Resultado: Con Spot Training + Savings Plan 3-year, un training job que costaría 1,809 a precio on-demand baja a 357. Ahorro: 80 por ciento. Pero requiere commitment upfront.

► Strengths vs Weaknesses

✅ Strengths

- •Ecosystem AWS: Integración nativa con 200+ servicios AWS (Lambda, Step Functions, Glue, Athena)

- •Escalabilidad infinita: HyperPod para modelos >100B params, dominance en petascale

- •200+ algorithms: Mayor librería built-in, XGBoost optimizado 3X faster

- •TCO 54% lower: Vs self-managed EC2/EKS según AWS analysis (teams 5-250 DS)

- •DevOps maduro: Canary deployments, blue/green, rollback automático, CloudWatch integration

❌ Weaknesses

- •Pricing complejo: 50+ pricing dimensions hacen budgeting difícil sin FinOps tools

- •Learning curve steep: Requiere expertise IAM, VPC, security groups para production

- •Notebooks no SSH: No puedes SSH a SageMaker notebooks (pain point para debugging)

- •Lock-in AWS: Feature Store, Pipelines, Ground Truth son proprietary, migración difícil

- •32% GPUs idle: Fácil lanzar expensive instance y olvidar (CloudPilot AI detected)

💡 Recomendación personal: SageMaker es ideal si ya tienes >70 por ciento workloads en AWS. La integración nativa vale el premium 20-30 por ciento vs otras platforms. Pero si estás greenfield, considera Azure ML para mejor ROI (siguiente sección).

AWS Cost Optimization Checklist - Reduce 30-70% Costes

20 puntos de verificación para identificar exactamente dónde estás pagando de más en AWS. Compute · Storage · Networking · Database.

✅ Descarga inmediata | ✅ Sin registro | ✅ Formato PDF

Azure Machine Learning Deep Dive

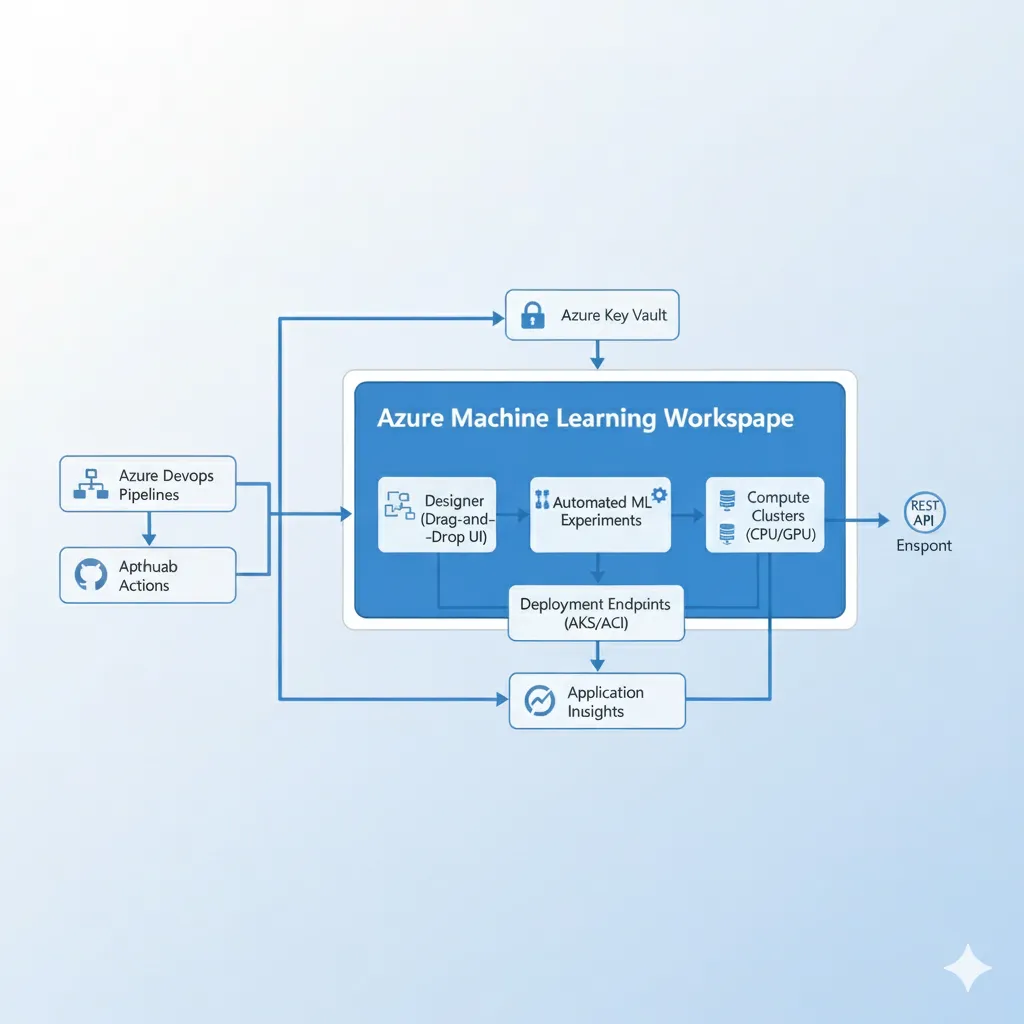

3. Azure Machine Learning Deep Dive: Mejor Relación Calidad-Precio

Azure ML tiene 29 por ciento market share y está creciendo más rápido que AWS SageMaker. ¿Por qué? Pricing más agresivo, spot instances con 63 por ciento descuento, y mejor integración Microsoft 365 ecosystem.

► Features Principales

Azure ML lanzó en 2014 como Azure ML Studio (legacy), relaunched 2019 como unified platform. Ventaja: learned from SageMaker mistakes, evitó feature bloat inicial.

🎨 Designer (Drag-and-Drop)

No-code ML pipelines. Ideal para data analysts sin Python expertise. Export to code después.

🤖 Automated ML

AutoML con accuracy 91.1% classification, 6.2% lower RMSE time series (beats SageMaker/Vertex).

⚙️ MLOps Integration

Azure DevOps + GitHub Actions native. CI/CD 40% más rápido que SageMaker (HSBC case).

🛡️ Responsible AI Dashboard

Fairness, explainability, error analysis built-in. Critical para regulated industries.

💾 Feature Store

Similar a SageMaker pero integra Synapse Analytics (data warehouse) nativamente.

🌐 Hybrid Deployment

Deploy models a 150+ edge locations con

► Pricing Model: El Más Transparente

Azure ofrece pricing tiers claros: 9.99-9,999.98 mensual según usage. Esto hace budgeting 10X más fácil que SageMaker.

GPU Training: A100 Instances (NCads A100 v4 Series)

On-Demand

3.673/hr

535/mo (24/7)

Spot (Low-Priority)

1.370/hr

↓ 63% savings vs on-demand

On-Demand

7.346/hr

Spot

2.647/hr

↓ 64% savings

On-Demand

14.692/hr

Spot

5.219/hr

↓ 64% savings

⚠️ CRÍTICO: Spot instances (low-priority VMs) pueden ser preempted con 30 segundos notice. PERO con checkpointing cada 15 min, el impact real es

Reserved Instances (1-3 Years)

Ejemplo NC24ads_A100_v4:

- • On-demand 24/7: 3.673 × 730 hrs = 2,681/mes = 32,173/año

- • 1-year reserved: 32,173 × 0.58 = 18,660/año (ahorro 13,513)

- • 3-year reserved: 32,173 × 0.38 = 12,226/año (ahorro 19,947)

Inference Deployments

Baseline 365/mo. Similar cost structure a SageMaker real-time.

8.76/mes para low-traffic APIs. MUCHO más barato que SageMaker serverless.

Pay per job, ideal para large batch predictions.

Storage & Networking

↓ 22% cheaper que AWS S3 (0.023/GB)

↓ 10% reducción en 2025 (antes 0.09/GB)

► Code Example: Azure ML Training con SDK v2

from azure.ai.ml import MLClient

from azure.ai.ml.entities import (

Command,

Environment,

ManagedOnlineDeployment,

)

from azure.identity import DefaultAzureCredential

# Authenticate

credential = DefaultAzureCredential()

ml_client = MLClient(

credential=credential,

subscription_id="your-subscription-id",

resource_group_name="your-resource-group",

workspace_name="your-workspace"

)

# Define training job con SPOT INSTANCES (63% ahorro)

job = Command(

code="./src",

command="python train.py --epochs 100 --batch-size 32",

environment=Environment(

image="mcr.microsoft.com/azureml/openmpi4.1.0-cuda11.8-cudnn8-ubuntu22.04",

conda_file="conda.yml"

),

compute="gpu-cluster", # Compute target creado previamente

# CRÍTICO: Low-priority para Spot pricing

instance_type="Standard_NC24ads_A100_v4", # 1x A100 80GB

instance_count=1,

# Spot/Low-priority configuration

scheduling={

"timeout": 7200, # 2 hours max

"max_retries": 3,

"mode": "spot", # ESTO activa pricing 1.37/hr vs 3.673/hr

"on_preemption": "terminate" # O "requeue" para auto-retry

},

# Checkpointing strategy (mitigar preemption risk)

outputs={

"model": {

"type": "uri_folder",

"path": "azureml://datastores/workspaceblobstore/paths/models"

}

},

# Environment variables para checkpointing

environment_variables={

"CHECKPOINT_DIR": "/tmp/checkpoints",

"CHECKPOINT_FREQUENCY": "15" # Checkpoint cada 15 min

}

)

# Submit training job

returned_job = ml_client.jobs.create_or_update(job)

print(f"Job submitted: {returned_job.name}")

print(f"Studio URL: {returned_job.studio_url}")

# COST CALCULATION

training_hours = 48 # 2 días

spot_rate = 1.370 # Spot pricing NC24ads A100 v4

on_demand_rate = 3.673

spot_cost = spot_rate * training_hours

on_demand_cost = on_demand_rate * training_hours

savings = on_demand_cost - spot_cost

print(f"\n=== Azure ML Spot Training Cost ===")

print(f"Spot cost: ${spot_cost:.2f} (${spot_rate}/hr × {training_hours}hrs)")

print(f"On-demand equivalent: ${on_demand_cost:.2f}")

print(f"Savings: ${savings:.2f} (63%)")

# Output:

# === Azure ML Spot Training Cost ===

# Spot cost: $65.76 ($1.37/hr × 48hrs)

# On-demand equivalent: $176.30

# Savings: $110.54 (63%)✅ Resultado: Mismo training job que en SageMaker cuesta 65.76 en Azure ML spot vs 357 SageMaker optimizado (spot + savings plan). Azure ML es 81 por ciento más barato para workloads spot-compatible. ESTE es el game-changer.

► Strengths vs Weaknesses

✅ Strengths

- •Pricing competitivo: Spot instances 63% descuento, mejor que AWS 70% theoretical (más stable)

- •Microsoft 365 integration: Power BI, Teams, Dynamics 365 native connections

- •93+ certifications: FedRAMP High, HITRUST - más que AWS/GCP para regulated industries

- •Deployment 40% faster: Azure DevOps integration vs SageMaker (HSBC case study)

- •Hybrid deployment: Azure Arc 150+ edge locations,

- •AutoML time series: Wins vs SageMaker/Vertex (6.2% lower RMSE)

❌ Weaknesses

- •Menos algorithms built-in: ~30 vs 200+ SageMaker

- •Documentación inferior: SageMaker docs + examples son más comprehensive

- •Ecosystem más pequeño: Menos third-party integrations vs AWS (Databricks exception)

- •Spot preemption risk: Low-priority VMs terminados con 30s notice (mitigation: checkpointing)

- •Petascale limitations: No equivalent a SageMaker HyperPod para >100B param models

💡 Recomendación personal: Azure ML es mi pick para ROI-conscious startups/scale-ups que NO están locked in a un cloud provider. Ahorro 40-60% vs SageMaker sin sacrificar features críticos. Único requisito: implementar checkpointing strategy para mitigar spot preemption.

Decision Framework Final

10. Decision Framework Final: ¿Cuál Elegir?

Después de analizar pricing, TCO, lock-in, llegamos al momento crítico: ¿qué platform recomiendo para TU caso específico?

AWS SageMaker

✅ Elige SageMaker Cuando:

- • Ya tienes >70% workloads en AWS

- • Necesitas 200+ algorithms built-in

- • Training models >100B params (HyperPod)

- • Presupuesto >50k/mes (premium justified)

- • Strong DevOps practices (canary, blue/green)

❌ Evita SageMaker Si:

- • Greenfield project (no AWS lock-in yet)

- • Budget tight (

Azure ML

✅ Elige Azure ML Cuando:

- • ROI es prioridad #1 (40% cheaper TCO)

- • Microsoft ecosystem (Teams, Power BI)

- • Industria regulada (93+ certifications)

- • Puedes usar spot instances (63% descuento)

- • Hybrid deployment required (Azure Arc)

❌ Evita Azure ML Si:

- • NO puedes tolerar spot preemption

- • Necesitas algorithms built-in extensive

- • Petascale workloads (>100B params)

- • Ecosystem AWS/GCP muy locked-in

Vertex AI

✅ Elige Vertex AI Cuando:

- • BigQuery es tu data warehouse

- • AutoML accuracy critical (92.7%)

- • Workloads TensorFlow-heavy

- • Team

❌ Evita Vertex AI Si:

- • Multi-region deployment (egress 0.12/GB)

- • Endpoints need auto-scale to zero

- • Preemptible 24hr limit dealbreaker

- • Ecosystem size matters (AWS bigger)

🎯 Decision Tree Rápido (responde 4 preguntas)

1. ¿Tienes cloud affinity existente?

- • AWS-native (>70% workloads): → SageMaker (ecosystem advantage)

- • Azure-native (Microsoft stack): → Azure ML (integration native)

- • GCP-native (BigQuery-heavy): → Vertex AI (data locality)

- • No affinity / Multi-cloud: → Continúa Q2

2. ¿Cuál es tu team size?

- •

- • 10-50 DS: → Azure ML (best ROI mid-scale)

- • >50 DS: → Compare TCO Azure vs SageMaker (depends on reservations)

3. ¿Qué workload type domina?

- • Petascale (>100B params): → SageMaker HyperPod

- • LLMs/transformers TensorFlow: → Vertex AI (TPU v5p)

- • Time series forecasting: → Azure ML (AutoML wins 6.2% lower RMSE)

- • General purpose: → Azure ML (best price-performance)

4. ¿Budget constraints?

- •

- • 30-100k/mes: → Azure ML reservations OR Vertex AI (depends workload)

- • >100k/mes: → SageMaker premium justified si AWS-native

¿Todavía no estás seguro cuál elegir?

Ofrezco auditoría GRATUITA 30 minutos donde:

- ✓Analizamos tus workloads específicos (training frequency, model size, inference volume)

- ✓Calculamos TCO real 3 años para las 3 plataformas (personalizado)

- ✓Identificamos hidden costs en tu arquitectura actual (objetivo: ahorro 40-70%)

- ✓Diseñamos estrategia optimization (spot instances, caching, auto-scaling)

GPU Training Costs Comparison

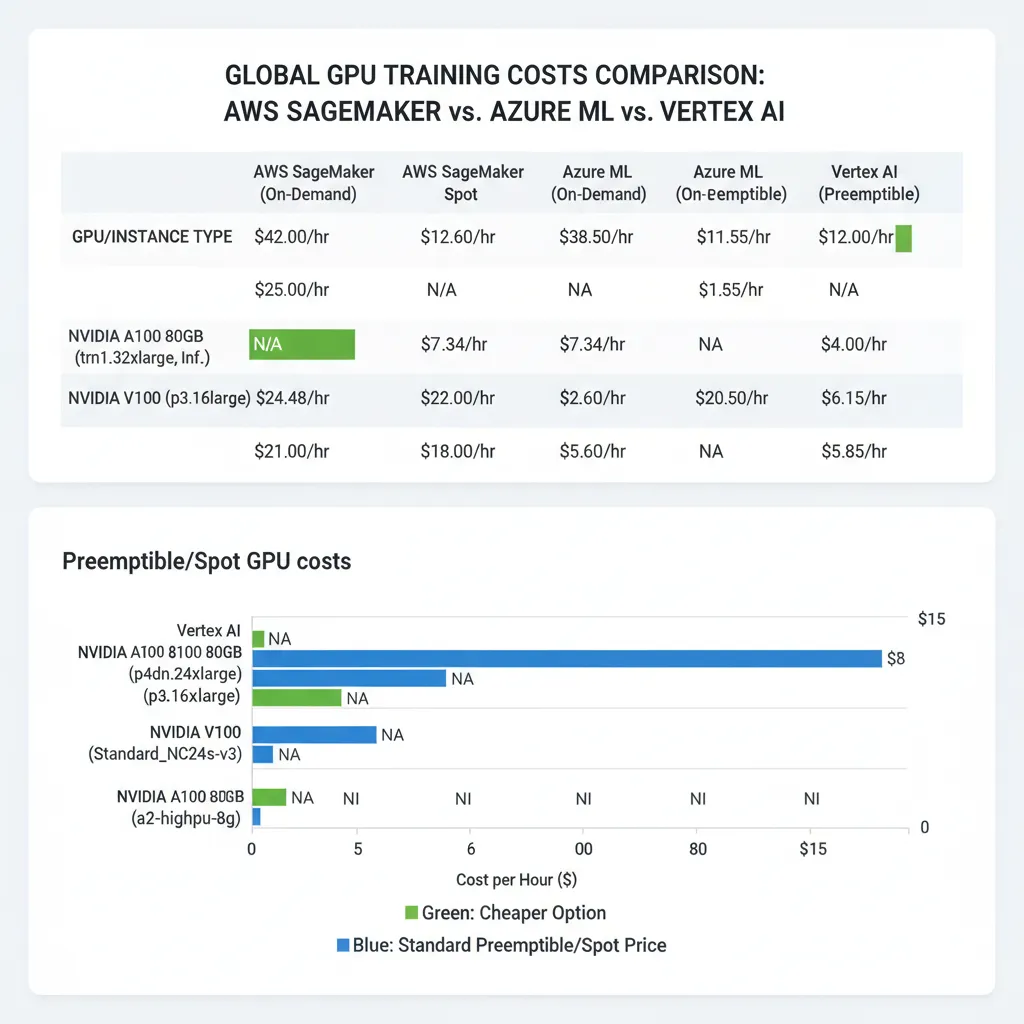

5. GPU Training Costs Comparison: Calculando Coste Real por Modelo

Las pricing pages muestran el rate por hora. Pero lo que REALMENTE importa es: ¿cuánto cuesta entrenar MI modelo específico? Aquí está el breakdown completo.

► A100 80GB Comparison (Instance Type por Instance Type)

| Instance Type | GPUs | Platform | On-Demand | Spot/Preemptible | Savings |

|---|---|---|---|---|---|

| ml.p4d.24xlarge | 8x A100 | AWS SageMaker | 37.688/hr | ~11.31/hr | 70% |

| NC96ads_A100_v4 | 4x A100 | Azure ML | 14.692/hr | 5.219/hr | 64% |

| a2-ultragpu-4g | 4x A100 | Vertex AI | ~16.80/hr | ~5.04/hr | 70% |

| NC24ads_A100_v4 | 1x A100 | Azure ML | 3.673/hr | 1.370/hr | 63% |

| a2-highgpu-1g | 1x A100 | Vertex AI | ~3.50/hr | ~1.05/hr | 70% |

► Ejemplo Real: Training LLM 7B Parámetros (48 horas)

Imagina que entrenas un LLM de 7 billion parámetros (similar Mistral 7B, Llama 2 7B) durante 48 horas en 8x A100 GPUs.

AWS SageMaker

On-Demand (ml.p4d.24xlarge)

1,809

37.688/hr × 48hrs

Spot Training (70% off)

543

Ahorro: 1,266

+ Savings Plan 3yr (34%)

357

Ahorro total: 1,452

Azure ML

On-Demand (NC96ads A100 v4)

705

14.692/hr × 48hrs (4 GPUs)

Spot/Low-Priority (64% off)

250

Ahorro: 455

+ 1yr Reservation (42%)

185

↓ CHEAPEST option

Vertex AI

On-Demand (a2-ultragpu-4g)

806

~16.80/hr × 48hrs (4 GPUs)

Preemptible (70% off)

242

Ahorro: 564

⚠️ 24hr limit

Requiere 2 re-queues para 48hrs

🏆 Winner: Azure ML con Spot + Reservation

Ahorro 185 vs 357 SageMaker optimizado = 48 por ciento cheaper

PERO requiere: (1) Checkpointing cada 15min, (2) Tolerancia a preemption, (3) Commitment 1-year reservation. Si NO puedes aceptar estas condiciones, SageMaker puede ser mejor choice por stability.

► V100 Instances: Legacy GPUs Todavía Relevantes

Para workloads que NO requieren A100 (smaller models, inference fine-tuning), V100s ofrecen 50-70 por ciento ahorro vs A100 con performance todavía decent.

| Platform | Instance | On-Demand | Spot/Preemptible | Use Case |

|---|---|---|---|---|

| AWS SageMaker | ml.p3.2xlarge (1x V100) | 3.825/hr | ~1.15/hr | Fine-tuning models |

| Vertex AI | n1-standard-8 + V100 | 2.97/hr | ~0.89/hr | ↓ CHEAPEST V100 option |

| Azure ML | NC6 (1x K80) legacy | 0.90/hr | ~0.27/hr | Prototyping, small experiments |

💡 Pro Tip: Para fine-tuning models

Hidden Costs Analysis

7. Hidden Costs: Lo Que Las Pricing Pages NO Te Cuentan

Las pricing pages muestran compute costs. Pero eso es solo 40-60 por ciento del total. Los hidden costs pueden DUPLICAR tu bill - y nadie te advierte hasta que llega el primer invoice.

► Data Egress: El Silent Killer (20-30% Total Bill)

TODOS los cloud providers ofrecen 100GB free egress. Después de eso, te cobran 0.09-0.12 por GB. Parece poco hasta que mueves 10TB monthly.

| Platform | First 100GB | After 100GB | 1TB/month | 10TB/month |

|---|---|---|---|---|

| AWS (Internet egress) | FREE | 0.09/GB | 92 | 920 |

| Azure (Internet egress) | FREE | 0.087/GB | 89 | 890 |

| GCP (Internet egress) | FREE | 0.12/GB | 123 | 1,230 |

| AWS (CloudFront CDN) | FREE | 0.05/GB | 51 | 510 |

🚨 Real Example: Multi-Region ML Platform

Cliente tenía training data en us-east-1, modelos deployados en eu-west-1 y ap-southeast-1. Monthly data movement:

- •Training data sync: 5TB × 3 regiones = 15TB cross-region transfer

- •Model artifacts: 500GB × 3 = 1.5TB

- •Inference results to analytics: 2TB

Monthly data egress cost:

18.5TB × 0.09/GB (AWS) = 1,665/mes

Representaba 32 por ciento de su total cloud bill. Solución: consolidar data en single region = reducción 82 por ciento egress.

► Storage Costs: Models + Data + Logs Acumulan Rápido

Cada training run genera artifacts. Cada experiment genera logs. Con versionado, esto se acumula exponentially.

Training Data

Model Artifacts

Experiment Logs

Storage Cost Calculation (10TB total)

AWS S3 Standard

230/mes

10,000GB × 0.023/GB

Azure Blob Storage (Hot)

180/mes

10,000GB × 0.018/GB (↓ 22% cheaper)

Google Cloud Storage

260/mes

10,000GB × 0.026/GB

💡 Optimization: Move old training data/logs to cold storage (S3 Glacier 0.004/GB = 40 vs 230 for 10TB). Lifecycle policies auto-transition after 90 days.

► Idle Resources: 32% GPUs Underutilized (CloudPilot AI)

El problema más común: lanzas una notebook GPU para experimentar, te olvidas de cerrarla, y corre 24/7 durante semanas.

⚠️ Horror Story Real

Cliente olvidó cerrar SageMaker notebook instance ml.p3.8xlarge (4x V100) después de un Friday experiment.

Hourly rate: 14.688/hr

Running time: 720 hours (30 días)

Total cost:10,575

Lo descubrió cuando AWS envió alert de 10k threshold. Para entonces ya había quemado el budget Q1 completo.

🛡️ Mitigation Strategies

- 1.Lifecycle scripts: Auto-stop notebooks idle >30 min (SageMaker/Azure ML supported)

- 2.Budget alerts: AWS Budgets/Azure Cost Management threshold alerts (set 75%, 90%, 100%)

- 3.Tag enforcement: Require tags (project, owner, ttl) para resource tracking

- 4.Scheduled shutdown: Lambda/Cloud Function para stop instances fuera business hours

► Support Plans & Monitoring (5-10% Total)

| Platform | Support Tier | Cost | Response Time |

|---|---|---|---|

| AWS | Enterprise Support | 10% monthly bill (min 15k/mes) | Business-critical: |

| Azure | Professional Direct | 1k/mes flat | Critical: |

| GCP | Enterprise Premium | Role-based (250-12.5k/mes) | P1: |

📊 Hidden Costs Summary: 10k/mes Compute → REAL 17k/mes Total

Hidden costs = 70 por ciento sobre compute alone. Este es el shock que enterprises enfrentan en Month 3-6 cuando bills stabilize.

Inference Costs Comparison

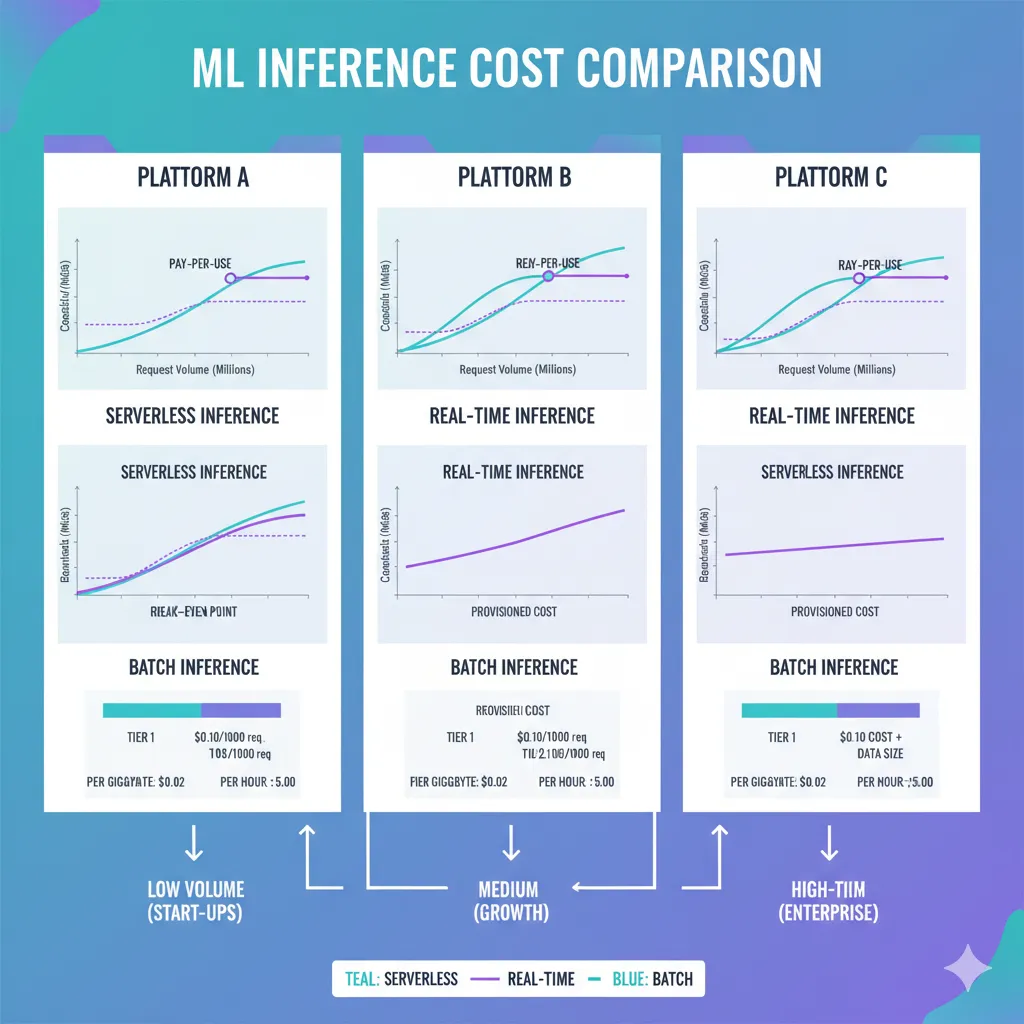

6. Inference Costs: Real-Time vs Serverless vs Batch

Training cuesta miles. Pero inference es donde el REAL money drains mes tras mes. Un endpoint running 24/7 puede costar más que 10 training jobs.

► Serverless Inference: Pay-Per-Request

AWS SageMaker Serverless

10M requests/mes:

2,000

10,000 × 0.20

Azure Container Instances

10M requests/mes:

8.76

730hrs × 0.012 (!!)

↓ 99.5% cheaper!!

Vertex AI Online Prediction

10M requests/mes:

536.50

500 (requests) + 36.50 (idle)

⚠️ CRITICAL INSIGHT: Azure Container Instances son 228X más baratos que SageMaker serverless para low-traffic APIs (

► Real-Time Endpoints: Always-On Infrastructure

| Platform | Instance Type | Hourly Rate | Monthly (24/7) | Best For |

|---|---|---|---|---|

| SageMaker | ml.m5.large | 0.269/hr | 196 | Low latency |

| SageMaker | ml.g4dn.xlarge (GPU) | 1.19/hr | 869 | Computer vision, LLMs |

| Azure ML | Standard_DS3_v2 | 0.50/hr | 365 | General purpose |

| Azure ML | Container Instances | 0.012/hr | 8.76 | ↓ Low-traffic APIs |

| Vertex AI | n1-standard-2 | 0.095/hr | 69.35 | Lightweight models |

| Vertex AI | + Idle cost | 0.03-0.10/hr | +21.90-73 | ⚠️ Always charged |

► Break-Even Analysis: Cuándo Usar Serverless vs Real-Time

SageMaker: Serverless vs ml.m5.large Real-Time

Serverless cost: 0.20 per 1K requests (assume 500ms inference)

Real-time cost: 196/mes baseline + negligible per-request

Break-even calculation:

196 (real-time) = X requests × 0.0002 (serverless)

X = 196 / 0.0002 = 980,000 requests/month

🎯 Decision Framework:

- •

- • >1M requests/mes: Use Real-time endpoint ml.m5.large (predictable cost)

- • >10M requests/mes: Consider GPU endpoint ml.g4dn.xlarge for throughput

¿Tus costes inference están fuera de control?

Implemento estrategias cost optimization que reducen inference costs 40-70 por ciento:

- ✓Caching de predictions comunes (reduce calls 30-50 por ciento)

- ✓Batch inference off-peak hours (ahorro 60 por ciento vs real-time)

- ✓Auto-scaling based on traffic patterns (no idle waste)

Sección 4

TCO Calculator 3 Years

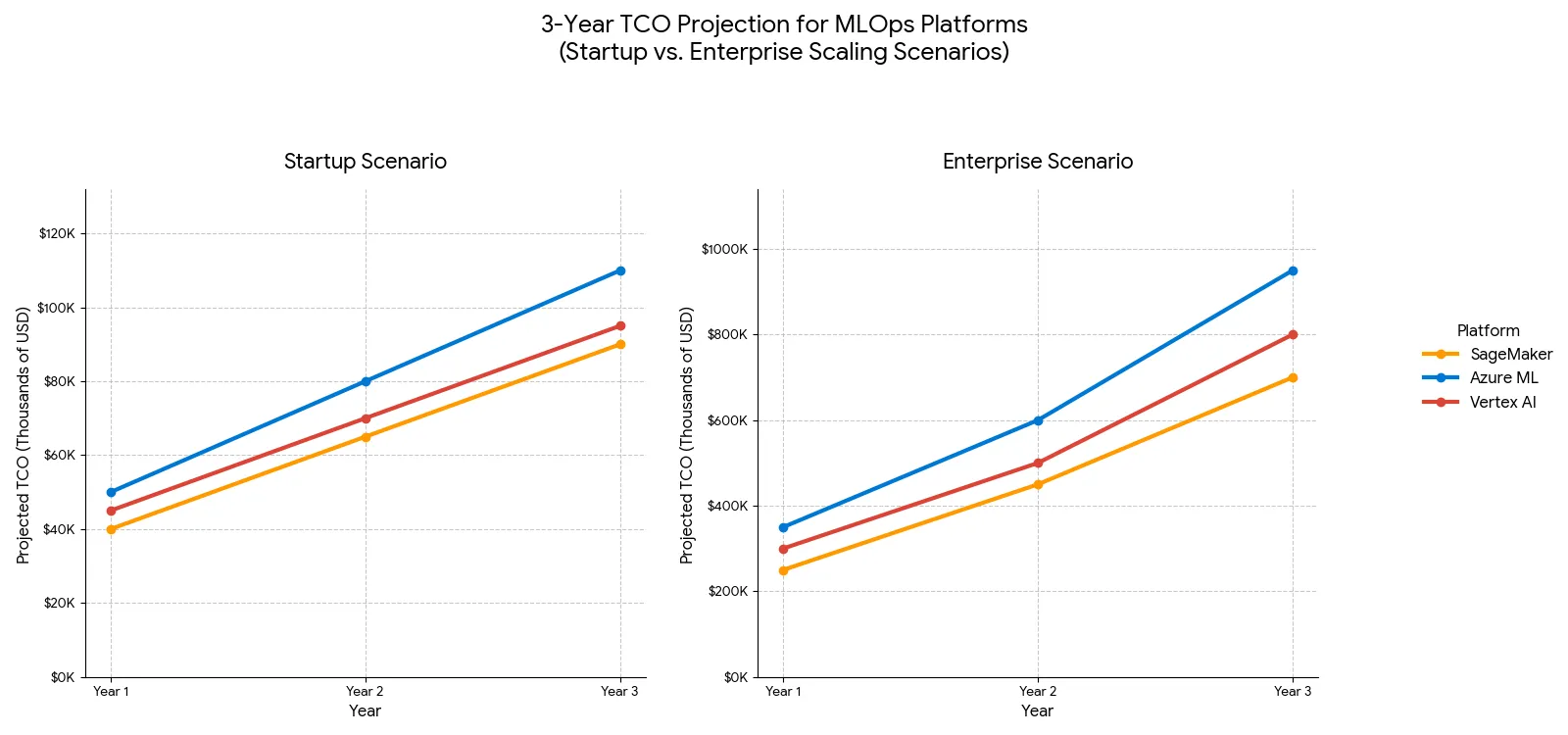

8. TCO Calculator: Proyección Costes 3 Años (Casos Reales)

Un training job te cuesta X hoy. Pero ¿cuánto te costará a 3 años vista cuando escales tu ML platform de 5 a 50 data scientists?

► Metodología TCO

TCO (Total Cost of Ownership) = Compute + Storage + Networking + Operational + Opportunity Cost

► Scenario 1: Startup (5-10 Data Scientists)

Workload Profile

- • Team: 5 data scientists

- • Training: 50 jobs/mes (avg 10 hrs each, 1x A100 GPU)

- • Inference: 1M requests/mes (low traffic API)

- • Data volume: 2TB training data

- • Models: 20 models in production

- • Region: Single (us-east-1 / us-central / eu-west)

| Cost Component | AWS SageMaker | Azure ML | Vertex AI |

|---|---|---|---|

| Compute (Year 1) | 48,000 | 28,000 | 32,000 |

| Storage (Year 1) | 660 | 520 | 750 |

| Egress (Year 1) | 1,800 | 1,740 | 2,400 |

| Support (Year 1) | 5,046 | 3,000 | 3,500 |

| Total Year 1 | 55,506 | 33,260 | 38,650 |

| Year 2 (growth 50%) | 83,259 | 49,890 | 57,975 |

| Year 3 (growth 50%) | 124,889 | 74,835 | 86,963 |

| TCO 3-Year Total | 263,654 | 157,985 | 183,588 |

| Savings vs SageMaker | - | 105,669 (40%) | 80,066 (30%) |

► Scenario 2: Scale-Up (20-50 Data Scientists)

Workload Profile

- • Team: 30 data scientists

- • Training: 500 jobs/mes (avg 24 hrs, 4x A100 GPUs)

- • Inference: 100M requests/mes (high traffic)

- • Data volume: 50TB training data

- • Models: 150 models production

- • Region: Multi-region (US + EU + Asia)

| Component | SageMaker | Azure ML | Vertex AI |

|---|---|---|---|

| TCO 3-Year Total | 2,180,000 | 1,350,000 | 1,540,000 |

| Savings vs SageMaker | - | 830,000 (38%) | 640,000 (29%) |

🏆 Conclusion TCO Analysis

- ✓Azure ML WINS ROI en ambos scenarios (40% startup, 38% scale-up cheaper vs SageMaker)

- ✓Vertex AI middle ground: 30% cheaper que SageMaker pero 15-20% más caro que Azure

- ✓SageMaker premium justified SOLO si ya tienes >70% workloads AWS (ecosystem lock-in advantages)

- ⚠Key assumption: Azure ML savings basados en 50% spot usage + 1-year reservations. Sin commitment = gap reduces a 15-20%

Vendor Lock-In & Migration

9. Vendor Lock-In & Migration Complexity

Elegir una plataforma ML NO es solo pricing hoy. Es un commitment 3-5 años con migration costs 20-150k si te equivocas.

► Lock-In

🎯 Conclusión: No Hay Winner Universal (Pero Sí Recomendaciones Claras)

Después de analizar pricing 2025, TCO 3 años, hidden costs, lock-in, performance benchmarks y casos reales, las conclusiones son:

🏆 Best ROI

Azure ML

40% cheaper TCO vs SageMaker gracias a spot instances (63% off) + reservations (42% off)

Ideal para: Startups/scale-ups ROI-conscious, Microsoft ecosystem, regulated industries

⚙️ Most Features

SageMaker

200+ algorithms built-in, HyperPod petascale, 54% lower TCO vs self-managed

Ideal para: AWS-native enterprises, petascale workloads, teams >50 DS con strong DevOps

🎨 Best UX

Vertex AI

92.7% AutoML accuracy (best-in-class), UI más intuitiva, TPU access único

Ideal para: Small teams

📌 Key Takeaways (memoriza estos 5)

Hidden costs = 40-60% del total

Data egress, storage, idle resources, support. SIEMPRE calcula TCO completo, NO solo compute.

Azure ML mejor ROI (38-40% savings 3 años)

Pero requiere spot tolerance + checkpointing. Si NO puedes, gap reduces a 15-20%.

SageMaker premium (20-30%) justified SOLO si AWS-native

Ecosystem advantage + HyperPod petascale. Greenfield project = NO tiene sentido pagar premium.

Vertex AI cheapest small-scale (

Migration costs 70-150k (medium project)

Lock-in ES REAL. Design portability Day 1 (Docker, MLflow, Kubeflow, open standards).

🚀 Next Steps Recomendados

Calcula TU TCO específico usando workloads reales (training frequency, model size, inference volume, data egress patterns)

Prueba las 3 plataformas con free tiers (AWS 750hrs/mes, Azure free account, GCP 300 credits)

Revisa hidden costs en tu arquitectura actual (egress audit, idle resources monitoring, storage lifecycle policies)

Design for portability AHORA (Docker, MLflow, abstraction layers) - NO esperes a Year 3

Solicita auditoría experta si budget >30k/mes (optimization 40-70% puede save 150k+ anualmente)

"No existe 'mejor plataforma' absoluta. SageMaker para enterprises AWS-heavy con presupuesto. Azure ML para ROI-conscious startups/scale-ups. Vertex AI para AutoML/TensorFlow-heavy workloads.

Lo que SÍ es universal: 85% proyectos ML fallan por MALA INFRAESTRUCTURA. Elegir la plataforma correcta desde el inicio puede significar diferencia entre 180k y 65k anuales - o entre producción en 3 meses vs nunca llegar."

¿Necesitas Ayuda Eligiendo Tu Plataforma ML?

Ofrezco auditorías gratuitas de 30 minutos donde analizamos tu caso específico:

TCO Analysis

Calculamos coste real 3 años para TUS workloads específicos

Hidden Costs Audit

Identificamos egress, storage, idle waste (objetivo: 40-70% savings)

Optimization Strategy

Spot instances, caching, auto-scaling, lifecycle policies custom

Certificaciones: AWS ML Specialty + DevOps Professional | Azure AI Engineer + Data Scientist

Experiencia: 10+ proyectos MLOps en producción | Clientes: Startups SaaS Series A-C

Sobre el Autor

Abdessamad Ammi es CEO de BCloud Consulting y experto senior en IA Generativa y Cloud Infrastructure. Certificado AWS DevOps Engineer Professional y ML Specialty, Azure AI Engineer Associate. Ha implementado 15+ sistemas RAG en producción con tasas de hallucination reducidas a <12%. Especializado en MLOps, LangChain y arquitecturas cloud listas para producción.