Crisis Actual: Anatomía del Breach Flare 2025

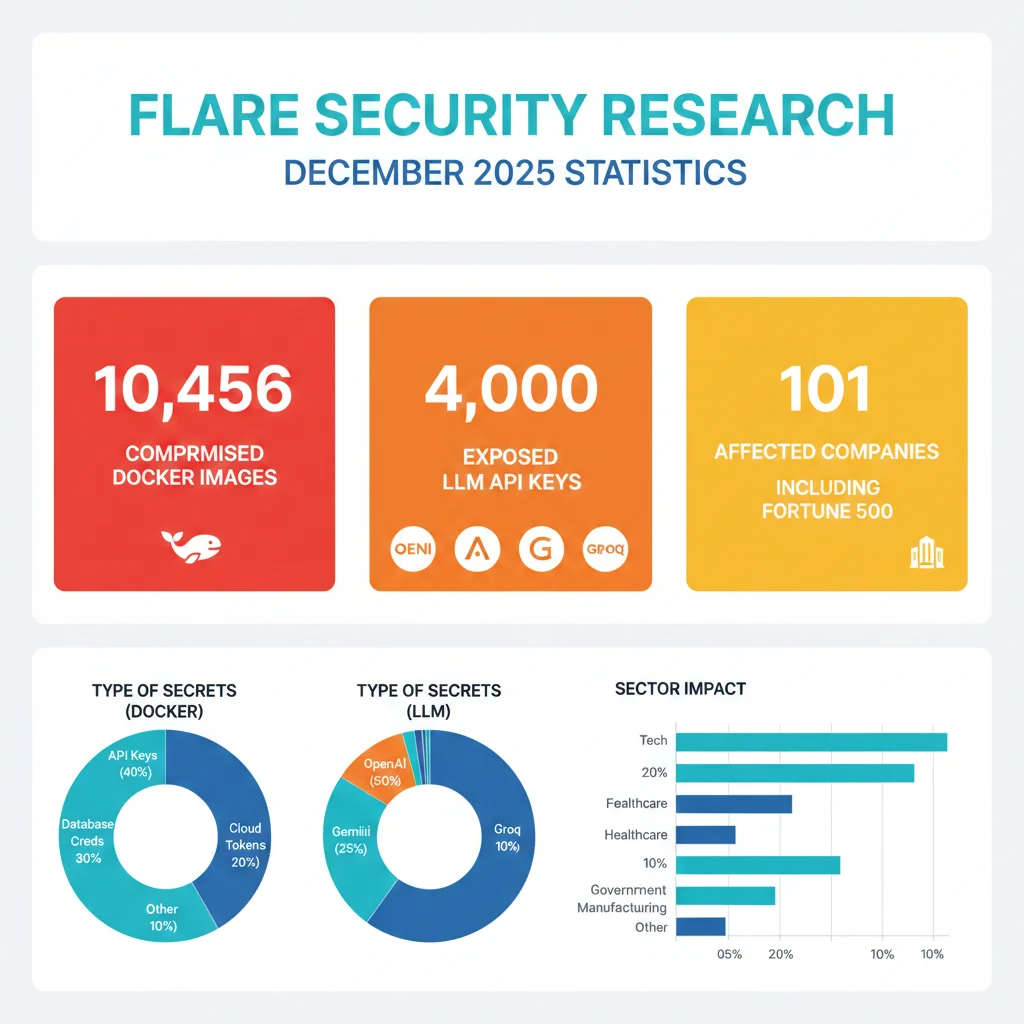

10,456 imágenes Docker en Docker Hub exponen credentials de producción

10,456

Imágenes Docker comprometidas

Flare Security, noviembre 2025

4,000

LLM API Keys expuestas

OpenAI, Anthropic, Gemini, Groq

101

Empresas identificadas

Fortune 500 + banco nacional

El 10 de diciembre de 2025, Flare Security publicó una investigación explosiva: tras analizar las imágenes Docker subidas a Docker Hub durante noviembre 2025, descubrieron 10,456 contenedores filtrando uno o más secrets, muchos de los cuales otorgan acceso a sistemas de producción, servicios cloud, pipelines CI/CD y plataformas de IA.

Si eres CTO, Head of Engineering o DevOps Lead en una startup SaaS o empresa tecnológica, esta crisis te afecta directamente. No estamos hablando de un vulnerability teórico ni de un breach aislado en una empresa desconocida. Estamos ante una epidemia sistémica que compromete:

- 14,000 API keys de LLMs (OpenAI GPT-4, Anthropic Claude, Google Gemini, Groq, HuggingFace) con costos potenciales de $120/día en uso no autorizado

- 2Credentials de cloud providers (AWS access keys, Azure service principals, GCP service accounts) que permiten control total de infraestructura

- 3Database passwords (PostgreSQL, MySQL, MongoDB) exponiendo datos de clientes y violaciones GDPR/HIPAA

- 4CI/CD tokens (GitHub, GitLab, CircleCI) que permiten supply chain attacks

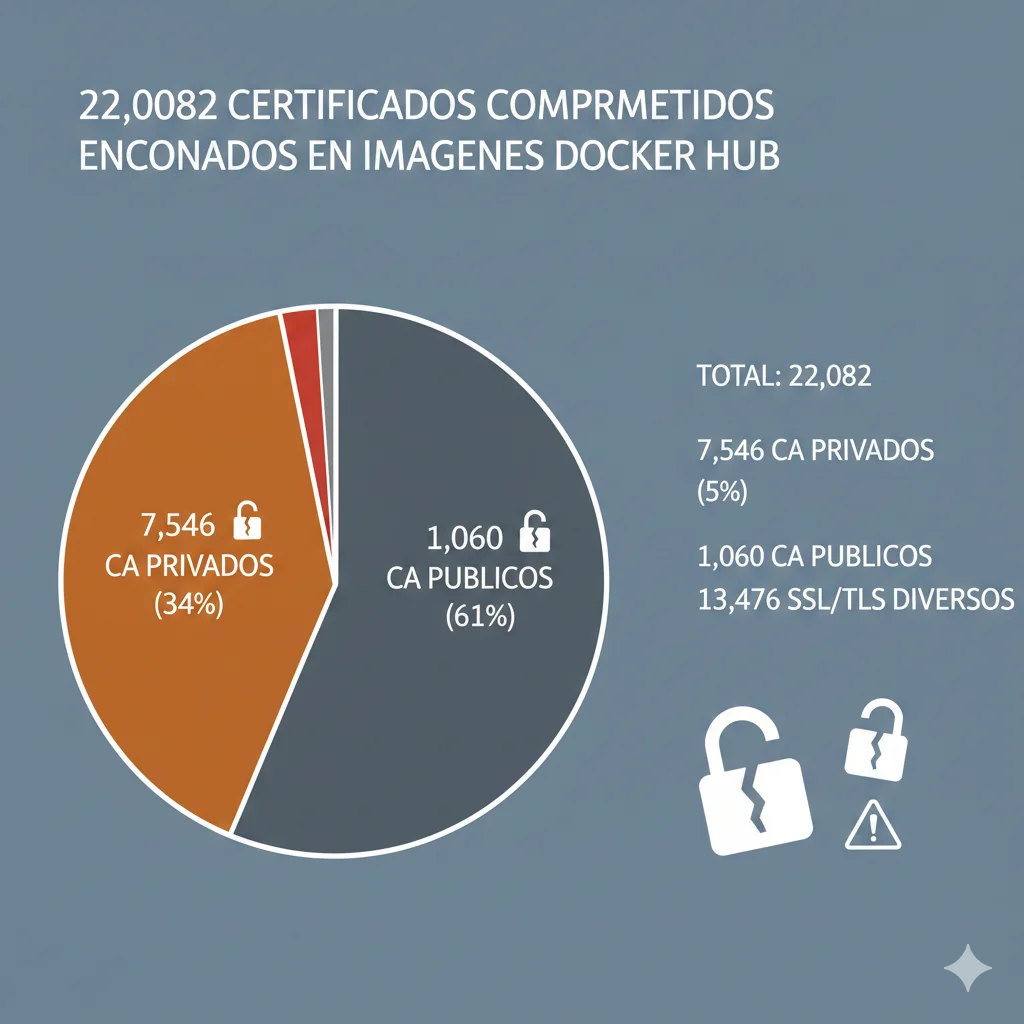

- 522,082 certificados comprometidos (7,546 CA privados, 1,060 CA públicos) según estudios previos de RWTH Aachen University

El problema NO es solo borrar la imagen expuesta

El hallazgo más alarmante de Flare: en aproximadamente el 75% de los casos donde un secret fue eliminado de una imagen publicada, la key o token en sí mismo permaneció activo. Esto significa que cualquiera que haya capturado el secret durante la ventana de exposición puede seguir usándolo indefinidamente.

¿La peor parte? 42% de las imágenes expuestas contenían 5 o más secrets simultáneamente. Un solo docker pull puede entregar a un atacante suficientes keys para moverse lateralmente por toda tu infraestructura crítica: desde tus buckets S3 hasta tu base de datos de producción, pasando por tu pipeline CI/CD y tus APIs de OpenAI.

En este artículo técnico exhaustivo, te muestro exactamente cómo auditar tus imágenes Docker Hub, un checklist de remediation de 40 pasos dividido en 4 fases críticas, y las arquitecturas de prevención que implemento con mis clientes para evitar que esto vuelva a suceder. Todo con código implementable, comandos verificados y casos reales.

💡 Nota: Si prefieres una auditoría profesional de tu Docker Hub + remediation guiada, mi servicio de DevSecOps incluye análisis completo de secrets management con roadmap personalizado de implementación.

1. Crisis Actual: Anatomía del Breach Flare 2025

La investigación de Flare Security, publicada el 10 de diciembre de 2025, no es un simple reporte de vulnerabilidades. Es una radiografía de cómo la adopción acelerada de IA en 2025 ha superado completamente los controles de seguridad de las organizaciones.

► Metodología de la Investigación

Flare analizó sistemáticamente todas las imágenes Docker subidas a Docker Hub durante el mes de noviembre de 2025. Utilizando herramientas de secrets scanning automatizadas (similares a TruffleHog y GitGuardian), escanearon tanto los layers visibles como los metadatos de las imágenes públicas.

# Comando similar al usado por Flare (TruffleHog Docker scanning)

trufflehog docker --image=nombre-imagen:tag \

--json \

--verify \

--max-depth=50

# Alternativa con Trivy para secrets + vulnerabilities

trivy image --severity HIGH,CRITICAL \

--scanners vuln,secret \

--format json \

nombre-imagen:tag✅ Punto clave: Estas herramientas NO requieren acceso al Dockerfile original. Analizan los layers ya construidos de la imagen, detectando secrets mediante expresiones regulares avanzadas y verificación activa contra APIs (TruffleHog soporta 700+ tipos de credentials).

► Las 101 Empresas Afectadas

Tras filtrar por hallazgos de severidad alta y crítica, los investigadores lograron atribuir 101 namespaces a organizaciones identificables. Entre ellas:

Fortune 500 Company

Sector tecnología

Cuenta personal de Docker Hub de un empleado senior sin vinculación visible a la empresa corporativa. Las imágenes contenían AWS access keys con permisos de administrador en entornos de staging.

Secrets encontrados:

- • AWS_ACCESS_KEY_ID + AWS_SECRET_ACCESS_KEY

- • GitHub Personal Access Token (repo scope)

- • Slack Webhook URL (canal #engineering)

Banco Nacional

Chief Software Architect

Más de 430 imágenes de contenedor asociadas al banco eran públicamente visibles sin control de acceso significativo. Incluían tokens de IA y credenciales de bases de datos.

Impacto potencial:

- • Acceso no autorizado a APIs de LLMs

- • Exposición de datos financieros (GDPR/PCI-DSS)

- • Violación de compliance bancario

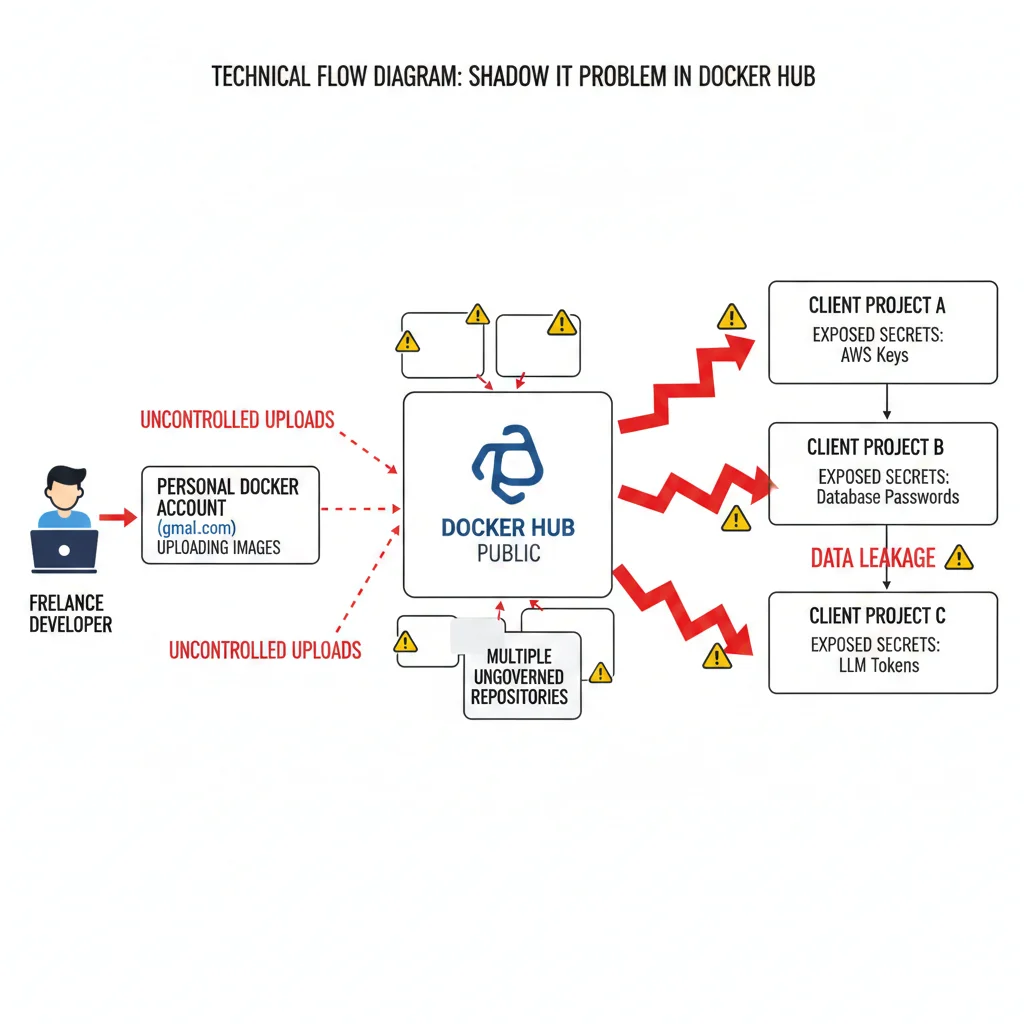

► Shadow IT: La Raíz del Problema

El hallazgo más preocupante de Flare no fueron los secrets en sí, sino dónde estaban alojados. Una porción significativa de las filtraciones proviene de cuentas de "Shadow IT":

- 1

Cuentas Docker Hub personales de developers

Empleados usando sus cuentas gmail.com o outlook.com en lugar del registro corporativo, fuera del radar de seguridad.

- 2

Contractors y freelancers externos

Un contractor descubierto tenía 70 repositorios públicos con secrets de múltiples clientes, incluyendo AWS keys, credenciales S3, passwords PostgreSQL de diferentes proyectos.

- 3

Equipos pequeños sin governance formal

Startups en fase early-stage donde "moverse rápido" significó saltarse políticas de registros privados y secrets management.

Por qué Shadow IT es invisible para Security Teams

Los equipos de seguridad corporativos monitorean el Docker Hub organizacional (ej: docker.io/empresa), pero las cuentas personales de empleados (docker.io/juan-dev) están completamente fuera de su visibilidad. No aparecen en auditorías SIEM, no están sujetas a políticas de retention, y los secrets expuestos ahí NO generan alertas.

Peor aún: cuando ese empleado o contractor termina su relación con la empresa, nadie revoca las credenciales que tiene en sus repositorios personales porque nadie sabe que existen.

► Distribución por Sectores Afectados

Aunque Flare no publicó un breakdown completo por industrias, el research de BleepingComputer y The Register identificó exposiciones en:

| Sector | Tipo de Secrets Predominante | Riesgo Principal |

|---|---|---|

| Fintech / Banca | Database passwords, API keys cloud | Exposición datos financieros (PCI-DSS) |

| AI/ML Startups | LLM API Keys (OpenAI, Anthropic) | Costos no autorizados ($120/día) |

| SaaS B2B | GitHub tokens, AWS keys, DB credentials | Supply chain attacks |

| Healthtech | Database passwords, cloud storage keys | Violación HIPAA (PHI exposure) |

| E-commerce | Payment gateway keys, customer DB | Fraude transaccional + GDPR |

Auditoría Urgente: Escaneando Tus Imágenes Docker Hub

5. Auditoría Urgente: Escaneando Tus Imágenes Docker Hub

Si has llegado hasta aquí, probablemente estás preguntándote: "¿Están MIS imágenes Docker expuestas?". La respuesta honesta: solo hay una forma de saberlo con certeza, y es escaneándolas.

Acción inmediata requerida

Si tu empresa tiene imágenes Docker en Docker Hub (públicas O privadas), necesitas auditarlas HOY. No la próxima semana, no cuando tengas tiempo. Hoy.

El 75% de secrets expuestos descubiertos por Flare seguían activos aunque la imagen hubiera sido borrada. Cada día de retraso es un día más que un atacante puede estar usando tus credentials.

► Pre-Audit Checklist: Inventario Completo

Antes de empezar a escanear, necesitas saber QUÉ escanear:

Checklist de Inventario (15 items)

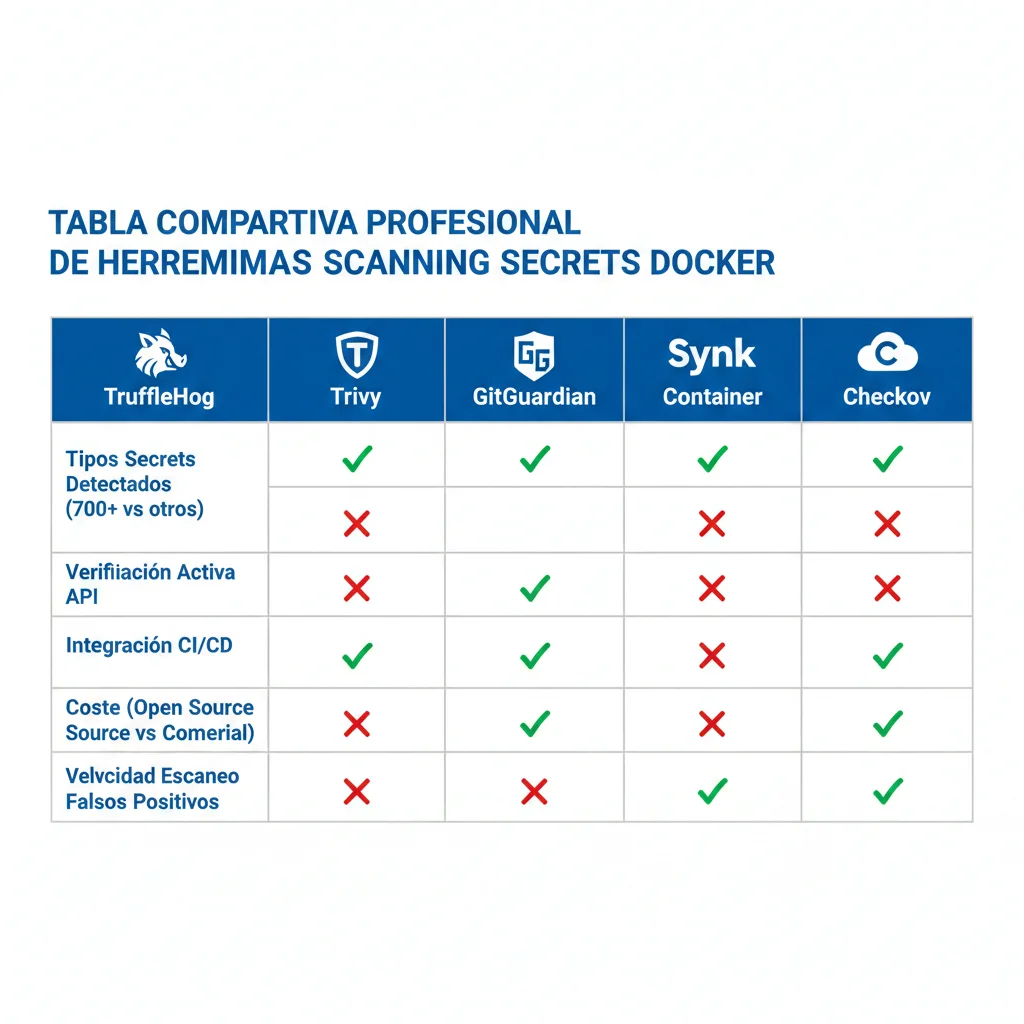

► Herramientas de Scanning: Comparativa Práctica

Existen docenas de herramientas de secrets scanning, pero estas 3 destacan por detection rate, velocidad y facilidad de integración en CI/CD:

| Tool | Detectores | Scan Time | Detection Rate | Verificación Activa | Pricing |

|---|---|---|---|---|---|

| TruffleHog | 700+ | Variable (1-3 min) | Alto | ✅ Sí | Free (OSS) |

| Trivy | CVE focus + secrets | <30s | 95.2% | Parcial | Free (OSS) |

| Snyk Container | 500+ | ~1 min | Alto | ✅ Sí | $0-99/dev/mo |

| GitGuardian | 350+ | Rápido | Alto | ✅ Sí | $18/dev/mo |

► Comandos Prácticos: Scan en 5 Minutos

Opción #1: TruffleHog (Recomendado para secrets)

# Instalación (macOS/Linux)

brew install trufflesecurity/trufflehog/trufflehog

# Windows

curl -sSfL https://raw.githubusercontent.com/trufflesecurity/trufflehog/main/scripts/install.sh | sh -s -- -b /usr/local/bin

# Scan imagen Docker local

trufflehog docker --image=tu-imagen:tag --json --verify

# Scan namespace completo Docker Hub (público)

trufflehog docker --image=tuempresa/nombre-imagen:latest

# Output a archivo para análisis

trufflehog docker --image=mi-app:prod --json > scan-results.json

# Filtrar solo VERIFIED secrets (activos)

trufflehog docker --image=mi-app:prod --json --verify | jq '.[] | select(.verified == true)'

# Ejemplo output:

# {

# "SourceMetadata": {"Container": "mi-app:prod", "file": "/app/.env", "layer": "sha256:abc123..."},

# "SourceID": 16,

# "SourceType": 16,

# "SourceName": "trufflehog - filesystem",

# "DetectorType": 673,

# "DetectorName": "OpenAI",

# "Verified": true, # ⚠️ CRITICAL: Secret ES VÁLIDO

# "Raw": "sk-proj-xxxxxxxxxxxxxxxxxxxx",

# "Redacted": "sk-proj-xxxx...xxxx"

# }

🎯 Ventaja TruffleHog: El campo Verified: true significa que el tool hizo un API call real para verificar si la key está ACTIVA. Esto elimina falsos positivos.

Opción #2: Trivy (Recomendado para CVEs + secrets)

# Instalación

brew install aquasecurity/trivy/trivy

# Scan imagen con secrets + vulnerabilities

trivy image --severity HIGH,CRITICAL \

--scanners vuln,secret \

mi-imagen:tag

# Output formato tabla legible

trivy image --scanners secret --format table mi-app:prod

# Output JSON para automation

trivy image --scanners secret --format json -o trivy-results.json mi-app:prod

# Scan solo secrets (skip CVE scan para velocidad)

trivy image --scanners secret mi-app:prod

# Ejemplo output:

# mi-app:prod (alpine 3.18)

# ===========================

# Total: 3 (UNKNOWN: 0, LOW: 0, MEDIUM: 0, HIGH: 2, CRITICAL: 1)

#

# Secrets

# ┌──────────────┬─────────────────┬──────────┬─────────────────────┐

# │ Category │ Match │ Severity │ Secret │

# ├──────────────┼─────────────────┼──────────┼─────────────────────┤

# │ OpenAI Token │ sk-proj-xxxxxx │ CRITICAL │ /app/.env:line 5 │

# │ AWS Keys │ AKIA... │ HIGH │ /app/config.py:12 │

# └──────────────┴─────────────────┴──────────┴─────────────────────┘✅ Ventaja Trivy: Scan combinado de CVEs + secrets en una sola pasada, en menos de 30 segundos. Perfecto para CI/CD donde el tiempo importa.

► Interpretando Resultados: Priorización CRITICAL

No todos los secrets encontrados tienen el mismo nivel de urgencia. Esta es mi matriz de priorización:

| Severidad | Tipos de Secret | Acción Inmediata | Tiempo Respuesta |

|---|---|---|---|

| 🔴 CRITICAL | • LLM API keys (OpenAI, Anthropic) • Database passwords (production) • AWS keys con permisos admin • Private keys de CA públicos | Revocar AHORA (0-1 hora) | Inmediato |

| 🟠 HIGH | • GitHub/GitLab tokens • Azure Service Principals • Redis/MongoDB passwords • Slack webhooks | Revocar mismo día (1-8 horas) | 24h |

| 🟡 MEDIUM | • Development API keys • Staging database credentials • Self-signed certificates | Planear rotación (1-3 días) | 72h |

| ⚪ LOW | • Expired tokens • Test/demo credentials • Localhost URLs | Clean up (siguiente sprint) | 1 semana |

Regla de Oro: Si está verificado como ACTIVO, es CRITICAL

TruffleHog marca secrets como Verified: true cuando confirma que la credential FUNCIONA (hace una API call real). Si ves esto en el output, el secret NO es un falso positivo y debe revocarse inmediatamente, sin importar su tipo.

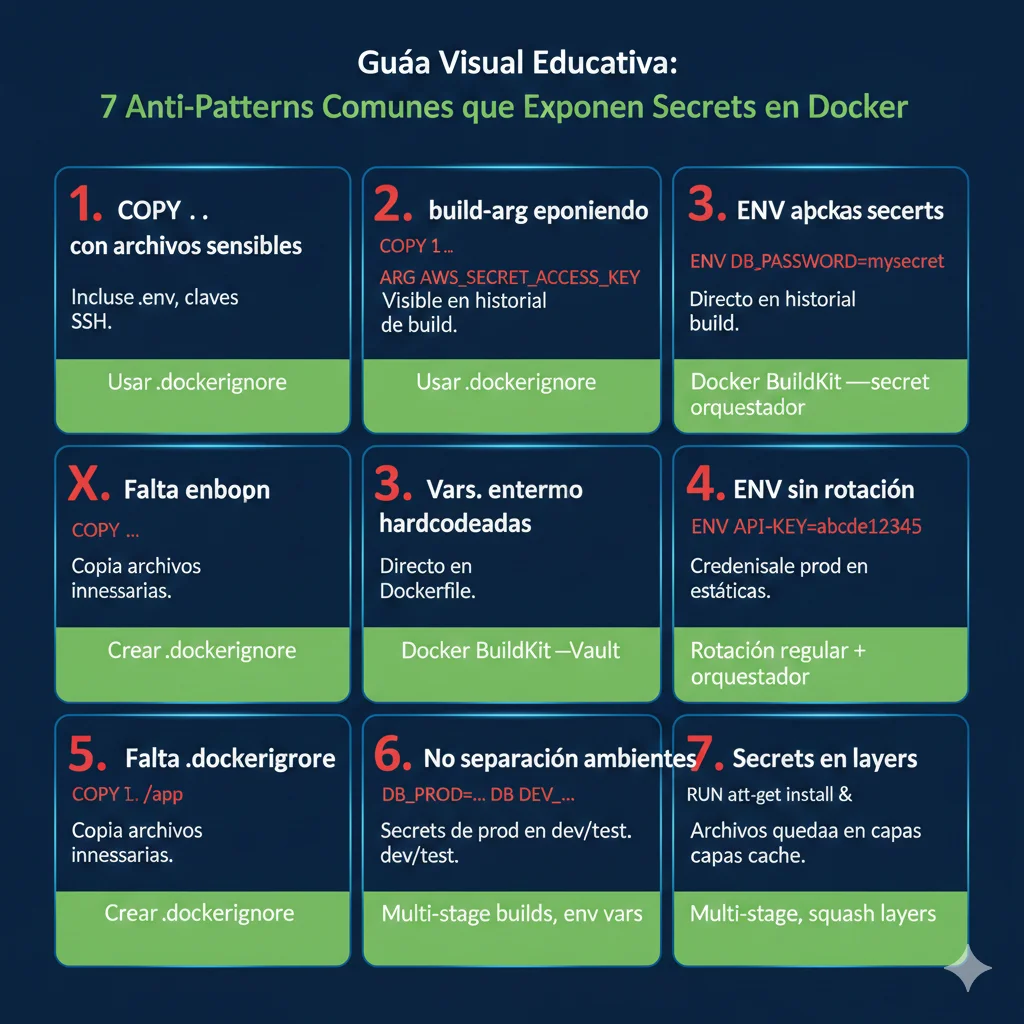

Cómo Secrets Llegan a Docker Images: 7 Anti-Patterns Comunes

4. Cómo Secrets Llegan a Docker Images: 7 Anti-Patterns Comunes

Los secrets no aparecen mágicamente en las imágenes Docker. Son el resultado de anti-patterns de desarrollo bien intencionados pero inseguros que los developers siguen porque "funcionan" o porque los vieron en tutoriales.

❌ Anti-Pattern #1: COPY . . Incluye .env Files

El comando más peligroso en Docker: COPY . . copia TODOS los archivos del directorio actual al image, incluyendo:

- •

.envfiles con API keys - •

.git/directory con history completo (commits anteriores con secrets) - •

config.json,secrets.yaml, archivos de configuración - •

node_modules/,__pycache__/que pueden contener cached credentials

FROM node:18-alpine

WORKDIR /app

# ⚠️ PELIGRO: Esto copia .env, .git/, y todo lo demás

COPY . .

RUN npm install

RUN npm run build

# ❌ Esto NO elimina .env del layer anterior

RUN rm .env

CMD ["npm", "start"]

# Resultado: .env está permanentemente en layer 2

# Cualquiera puede extraerlo con:

# docker history --no-trunc imagen:tag✅ SOLUCIÓN: .dockerignore + COPY selectivo

# .dockerignore - Archivo en raíz del proyecto

.env

.env.*

*.env

.git

.gitignore

.vscode

.idea

node_modules

__pycache__

*.pyc

.pytest_cache

coverage

.coverage

*.log

*.key

*.pem

*.crt

secrets/

credentials/

config/local.json

docker-compose*.yml

README.md

.DS_StoreFROM node:18-alpine

WORKDIR /app

# ✅ SEGURO: Solo copiar archivos necesarios

COPY package*.json ./

RUN npm install --production

# ✅ Solo código fuente, NO archivos config

COPY src/ ./src/

COPY public/ ./public/

RUN npm run build

CMD ["npm", "start"]

# Secrets se inyectan en runtime vía Docker secrets o env vars

# NO están en la imagen

❌ Anti-Pattern #2: --build-arg para Secrets

Muchos developers piensan que --build-arg es la forma correcta de pasar secrets al build. NO lo es. Los build args quedan expuestos en el metadata de la imagen.

# Dockerfile inseguro

FROM python:3.11-slim

# ❌ Declarar ARG hace que sea visible en metadata

ARG OPENAI_API_KEY

ARG DATABASE_PASSWORD

ENV OPENAI_API_KEY=${OPENAI_API_KEY}

ENV DATABASE_PASSWORD=${DATABASE_PASSWORD}

COPY . /app

RUN pip install -r requirements.txt

CMD ["python", "app.py"]

# Build command (también inseguro)

docker build --build-arg OPENAI_API_KEY=sk-proj-xxx \

--build-arg DATABASE_PASSWORD=MySecretPass123 \

-t mi-app:latest .

# ⚠️ Extracción trivial del secret:

docker history --no-trunc mi-app:latest | grep OPENAI_API_KEY

# Output: ARG OPENAI_API_KEY=sk-proj-xxx (EXPUESTO)🚨 Peligro crítico: Los build args son visibles para cualquiera con acceso a la imagen mediante docker history o docker inspect. NO requiere acceso al código fuente ni al Dockerfile original.

✅ SOLUCIÓN: BuildKit Secret Mounts

# syntax=docker/dockerfile:1.4

FROM python:3.11-slim

WORKDIR /app

COPY requirements.txt .

# ✅ Secret mount: solo disponible durante RUN, NO persiste en image

RUN --mount=type=secret,id=openai_key \

--mount=type=secret,id=db_password \

pip install -r requirements.txt && \

python setup.py --api-key=$(cat /run/secrets/openai_key) \

--db-password=$(cat /run/secrets/db_password)

COPY . .

CMD ["python", "app.py"]

# Build command SEGURO

export DOCKER_BUILDKIT=1

echo "sk-proj-xxx" > openai_key.txt

echo "MySecretPass123" > db_password.txt

docker build --secret id=openai_key,src=openai_key.txt \

--secret id=db_password,src=db_password.txt \

-t mi-app:latest .

# Cleanup local secret files

rm openai_key.txt db_password.txt

# ✅ Verificación: secrets NO están en la imagen

docker history --no-trunc mi-app:latest

# No muestra secrets

❌ Anti-Pattern #3: Environment Variables Visibles

Pasar secrets vía docker run -e API_KEY=xxx parece conveniente, pero expone credentials en múltiples lugares:

🔍 Visible en docker inspect

docker inspect container_name # Output: "Env": [ "API_KEY=sk-proj-secret123", "DB_PASSWORD=password" ]📋 Visible en process lists

ps aux | grep python # Output muestra env vars: python app.py API_KEY=sk-proj-...📝 Capturado en logs

# Application logs print(f"Connecting with {os.environ['API_KEY']}") # Log aggregators (Splunk, ELK) capturan esto👥 Visible a todo SRE team

Cualquier persona con acceso al container runtime puede ver env vars, incluso sin need-to-know

✅ SOLUCIÓN: File-based secrets con tmpfs

version: '3.8'

services:

app:

image: mi-app:latest

secrets:

- openai_api_key

- database_password

environment:

# ✅ Solo path al secret, NO el valor

OPENAI_API_KEY_FILE: /run/secrets/openai_api_key

DATABASE_PASSWORD_FILE: /run/secrets/database_password

secrets:

openai_api_key:

file: ./secrets/openai_key.txt

database_password:

file: ./secrets/db_password.txt

# Application code lee desde archivo

# Python example:

import os

def get_secret(secret_name):

secret_path = os.environ.get(f"{secret_name}_FILE")

if secret_path and os.path.exists(secret_path):

with open(secret_path, 'r') as f:

return f.read().strip()

return os.environ.get(secret_name) # Fallback

openai_key = get_secret("OPENAI_API_KEY")❌ Anti-Pattern #4: Hardcoded en Código Fuente

El más obvio pero sorprendentemente común: developers hardcodean credentials directamente en archivos Python, JavaScript o config JSON.

❌ Python inseguro

# config.py OPENAI_API_KEY = "sk-proj-xxx"

DATABASE_URL = "postgresql://user:pass@host"

# ❌ Commiteado a Git

# ❌ Copiado al Docker image

# ❌ Visible en GitHub search✅ Python seguro

# config.py

import os

OPENAI_API_KEY = os.getenv("OPENAI_API_KEY")

DATABASE_URL = os.getenv("DATABASE_URL")

# ✅ Never commiteado

# ✅ Inyectado en runtime

# ✅ No en Docker image

❌ Anti-Pattern #5: Sin .dockerignore File

Si no existe un archivo .dockerignore, Docker asume que QUIERES copiar todo. Esto incluye directorios que nunca deberían estar en una imagen:

Archivos copiados sin .dockerignore:

- •

.git/(history completo con secrets pasados) - •

.env,.env.local,.env.production - •

node_modules/(puede tener cached credentials) - •

.aws/,.ssh/,.docker/ - •

credentials.json,service-account.json - •

*.pem,*.key,*.crt(certificates) - •

.vscode/,.idea/(IDEs con cached tokens) - •

coverage/,.pytest_cache/(temp files)

❌ Anti-Pattern #6: Sin Separación de Ambientes

Usar la misma imagen Docker con los mismos secrets para dev, staging y production es extremadamente peligroso.

⚠️ Escenario real: Developer trabaja en local con docker-compose.yml que tiene DATABASE_URL apuntando a producción. Su laptop es robado → atacante tiene acceso directo a prod database.

✅ SOLUCIÓN: Environment-specific secrets

# docker-compose.dev.yml

services:

app:

environment:

DATABASE_URL: postgresql://localhost:5432/dev_db

OPENAI_API_KEY_FILE: /run/secrets/openai_dev

# ✅ Development key con rate limits bajos

# docker-compose.prod.yml

services:

app:

environment:

DATABASE_URL: postgresql://prod-db.internal:5432/prod_db

OPENAI_API_KEY_FILE: /run/secrets/openai_prod

# ✅ Production key con IP whitelisting

# ✅ Diferentes credentials, diferentes permisos

# Best practice: Vault paths

# Dev: vault/data/myapp/dev/openai-key

# Prod: vault/data/myapp/prod/openai-key❌ Anti-Pattern #7: Sin Secret Rotation Policy

Keys creadas hace 2+ años y nunca rotadas son el pan de cada día. El problema: si esa key fue expuesta en algún momento pasado (aunque ya no esté visible), sigue siendo válida.

Consecuencias de no rotar secrets:

- • Extended compromise window: Secret robado hace 6 meses sigue funcionando hoy

- • Contractor perpetual access: Freelancer que terminó hace 1 año aún puede acceder

- • Forgotten credentials: Nadie recuerda dónde está definida esa key de 2 años

- • Compliance failures: SOC 2 requiere rotación 60-90 días

✅ SOLUCIÓN: Automated rotation + dynamic secrets

- • HashiCorp Vault: Dynamic secrets con TTL automático (renuevan cada 24h-7d)

- • AWS Secrets Manager: Automatic rotation scheduling

- • OpenAI/Anthropic: Calendar reminders para rotation manual 60-90 días

- • CI/CD: Fail builds si secret tiene >90 días sin cambios

🎯 Takeaway: Los anti-patterns NO son errores de junior developers

Estos 7 anti-patterns son seguidos por engineers senior en Fortune 500 companies (como demostró Flare). No es falta de conocimiento técnico, es falta de awareness sobre las consecuencias y ausencia de tooling automatizado que prevenga estos errores antes de que lleguen a producción.

Los 5 Tipos de Secrets Más Expuestos

2. Los 5 Tipos de Secrets Más Expuestos

No todos los secrets expuestos tienen el mismo impacto. Flare identificó patrones claros en los tipos de credenciales más comprometidos, con las API keys de LLMs encabezando la lista por primera vez en la historia.

► #1: LLM API Keys (4,000 expuestas)

La Nueva Frontera de Exposición: APIs de Inteligencia Artificial

Casi 4,000 API keys de modelos de lenguaje fueron el tipo de credencial más frecuentemente filtrado, revelando cómo la adopción acelerada de IA ha superado los controles de seguridad.

Providers más afectados:

- • OpenAI (GPT-4, GPT-3.5, DALL-E)

- • Anthropic (Claude 3 Opus/Sonnet)

- • Google (Gemini Pro/Ultra)

- • Groq (Mixtral, Llama)

- • HuggingFace (Inference API tokens)

Impacto financiero real:

- • Baseline normal: $0.05-0.07/día

- • Post-leak spike: $120+/día

- • Requests no autorizados: 315,000+

- • Quota monthly depletion: 100%

- • Tiempo detección promedio: 3-7 días

Caso real reportado en OpenAI Community: Un developer descubrió que sus costos pasaron de $0.05/día a más de $120 en un solo día tras una exposición accidental de su API key en un repositorio público. El atacante hizo 315,000 requests a GPT-4 antes de que la key fuera revocada.

# ❌ INSEGURO: .env file copiado al Docker image

# Dockerfile que expone secrets

FROM python:3.11-slim

WORKDIR /app

# ⚠️ PELIGRO: COPY . . incluye archivos .env

COPY . .

RUN pip install -r requirements.txt

CMD ["python", "app.py"]

# Contenido de .env que queda permanente en layer

# OPENAI_API_KEY=sk-proj-xxxxxxxxxxxxxxxxxxxx

# ANTHROPIC_API_KEY=sk-ant-api03-xxxxxxxxxxxx

# DATABASE_URL=postgresql://user:password@prod-db:5432/maindbEl problema se agrava porque muchos developers nuevos en IA/ML no tienen training en secrets management. Vienen de backgrounds académicos o data science donde la prioridad era hacer funcionar el modelo, no asegurar las credenciales de producción.

► #2: Cloud Provider Credentials

Las credenciales de AWS, Azure y GCP fueron el segundo tipo más común. A diferencia de los LLM keys (que tienen impacto financiero directo), las cloud keys permiten control total de infraestructura.

AWS

Secrets más comunes:

- • AWS_ACCESS_KEY_ID

- • AWS_SECRET_ACCESS_KEY

- • AWS session tokens

Blast radius: Full AWS account

Azure

Secrets más comunes:

- • Service Principal IDs

- • Client secrets

- • Storage account keys

Blast radius: Subscription-wide

GCP

Secrets más comunes:

- • Service account JSON

- • API keys

- • OAuth 2.0 credentials

Blast radius: Project-level

► #3: Database Passwords

PostgreSQL, MySQL, MongoDB y Redis credentials fueron extremadamente comunes. El problema: estas passwords suelen ser las mismas en staging y producción, y rara vez se rotan.

⚠️ Compliance nightmare: Una database password expuesta en una imagen Docker pública constituye un "data breach" bajo GDPR (notificación obligatoria en 72h) y HIPAA (multas de hasta $50,000 por registro comprometido en healthtech).

► #4: CI/CD Tokens (GitHub, GitLab, CircleCI)

Los tokens de GitHub Personal Access (PAT), GitLab Project Access Tokens y CircleCI API keys permiten supply chain attacks. Un atacante con acceso a tu CI/CD puede inyectar malware en tus releases sin que nadie lo note.

Caso GhostAction Campaign (2024-2025):

Atacantes comprometieron 327 cuentas GitHub para inyectar workflows maliciosos que robaron 3,325 secrets de entornos CI/CD a través de 817 repositorios. Los tokens robados incluían acceso a PyPI, NPM y Docker Hub, permitiendo supply chain attacks masivos.

► #5: Private Keys & Certificados

Según el estudio de RWTH Aachen University (2021, aún relevante), 22,082 certificados comprometidos fueron encontrados, incluyendo:

- •7,546 certificados firmados por CA privados (empresas con su propia PKI interna)

- •1,060 certificados firmados por CA públicos (Let's Encrypt, DigiCert, etc.)

- •275,269 hosts usando private keys comprometidas para conexiones TLS

Esto significa que un atacante con la private key puede impersonar tu dominio, realizar man-in-the-middle attacks, o firmar software malicioso que parecerá legítimo.

Problema Sistémico: 8.5% de Imágenes Contienen Secrets

3. Problema Sistémico: 8.5% de Todas las Imágenes Docker Contienen Secrets

El breach de Flare en diciembre 2025 no es un incidente aislado. Es la continuación de una crisis sistémica que investigadores académicos vienen documentando desde 2021.

Estudio RWTH Aachen University (2021)

Investigadores de la universidad alemana RWTH Aachen analizaron 337,171 imágenes Docker compuestas de 1,647,300 layers individuales. Sus hallazgos fueron alarmantes:

8.5%

de imágenes contienen secrets hardcodeados

52,107

private keys válidas encontradas

28,621

imágenes con secrets expuestos

3,158

API secrets distintos identificados

► El Problema de los Certificados Comprometidos

De las 52,107 private keys encontradas, los investigadores descubrieron que 22,082 certificados dependían de esas claves privadas comprometidas:

| Tipo de Certificado | Cantidad | Impacto de Seguridad |

|---|---|---|

| Firmados por CA privados | 7,546 | Compromiso de PKI corporativa interna |

| Firmados por CA públicos | 1,060 | Impersonation de dominios públicos legítimos |

| Auto-firmados | 13,476 | Man-in-the-middle en entornos dev/staging |

► Impacto a Escala de Internet: 275,269 Hosts Comprometidos

Los investigadores no se limitaron a analizar imágenes Docker. Realizaron un escaneo a escala de internet para determinar cuántos servidores en producción estaban usando las private keys comprometidas que habían descubierto.

Resultado escalofriante:

275,269 hosts estaban usando private keys comprometidas para establecer conexiones TLS/SSL seguras. Esto significa que:

- •Un atacante puede desencriptar tráfico HTTPS de esos servidores

- •Puede realizar man-in-the-middle attacks sin ser detectado

- •Puede impersonar esos dominios para phishing campaigns

- •Las conexiones "seguras" (candado verde en navegador) NO son seguras

► Contexto Histórico: Docker Hub Breach 2019 vs Image Leaks 2025

Es importante diferenciar dos tipos de breaches relacionados con Docker Hub:

Docker Hub Platform Breach (2019)

Abril 2019

- •190,000 cuentas comprometidas

- •GitHub y Bitbucket tokens robados

- •Docker deshabilitó builds automáticos

- •Tipo: Platform infrastructure attack

Docker Images Secrets Leak (2025)

Diciembre 2025

- •10,456 imágenes con secrets expuestos

- •4,000 LLM API keys + cloud credentials

- •101 empresas identificadas (Fortune 500)

- •Tipo: User-generated content exposure

La diferencia clave: en 2019, Docker Hub como plataforma fue hackeada. En 2025, el problema NO es Docker Hub, sino lo que los usuarios suben a Docker Hub. La plataforma funciona como diseñada, pero los developers están hardcodeando secrets en sus imágenes.

► Por Qué el Problema Empeora en 2025

Varios factores confluyen para agravar la crisis de secrets en Docker:

1. Adopción acelerada de IA sin training de seguridad

Developers de ML/AI nuevos en containerización hardcodean OPENAI_API_KEY en Dockerfiles porque "así funciona en el tutorial".

2. Proliferación de Shadow IT

Work-from-home y contratación de freelancers globales significa más cuentas Docker Hub personales fuera de governance corporativo.

3. "Move fast and break things" culture

Startups en Series A-B priorizan velocidad sobre seguridad, skipeando secrets vaults "para lanzar más rápido".

4. Tutoriales y documentación inseguros

Top results en Google para "docker openai" muestran ejemplos con API keys hardcodeadas o usando --build-arg (inseguro).

5. Falta de scanning automatizado en CI/CD

La mayoría de pipelines NO tienen gates obligatorios de secrets scanning. Imágenes se deployean a producción sin ser analizadas.

🚨 Conclusión: No es un bug, es una crisis de educación y governance

El problema de secrets en Docker images no se solucionará con un parche de software. Requiere un cambio cultural en cómo las organizaciones entrenan a developers, implementan policies de registries, y auditan shadow IT. Mientras tanto, tu empresa puede estar expuesta ahora mismo sin saberlo.

Remediation Checklist Completo: 40 Pasos en 4 Fases

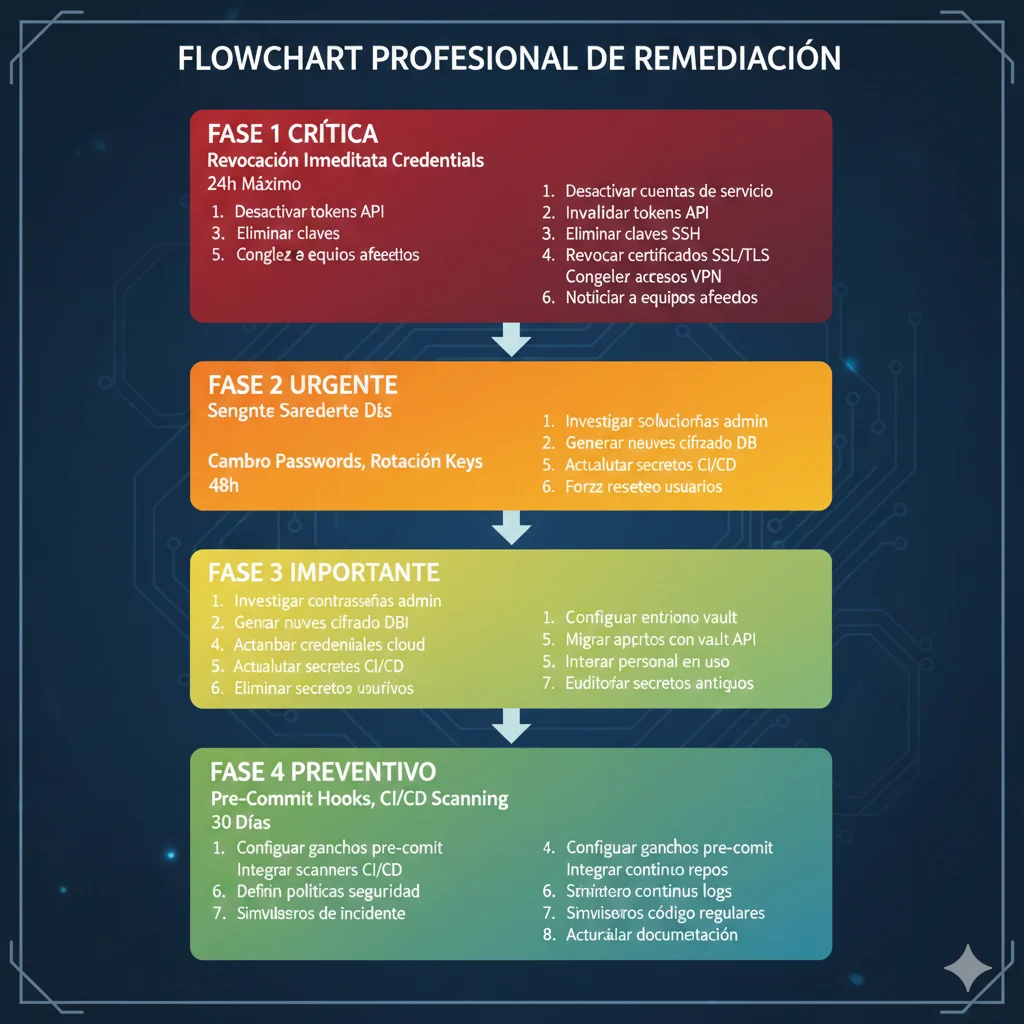

6. Remediation Checklist Completo: 40 Pasos en 4 Fases

Descubriste secrets expuestos. ¿Ahora qué? Este checklist de 40 pasos te guía desde la respuesta inmediata hasta la prevención a largo plazo.

⏰ FASE 1: Respuesta Inmediata (0-1 hora)

Objetivo: Contener el daño, revocar credentials críticos, bloquear acceso no autorizado

1. Identificar TODOS los secrets expuestos

Ejecutar TruffleHog/Trivy en todas las imágenes del namespace. Exportar a JSON para tracking.

2. Clasificar por severidad (CRITICAL → HIGH → MEDIUM → LOW)

Usar matriz de priorización de sección anterior. LLM keys + DB passwords = CRITICAL.

3. Revocar CRITICAL secrets INMEDIATAMENTE

• OpenAI: platform.openai.com/api-keys → Delete

• Anthropic: Console → API Keys → Revoke

• AWS: IAM → Users → Security Credentials → Make Inactive

• Database: `ALTER USER app_user WITH PASSWORD 'new_password';`

4. Notificar a security team + stakeholders

Email a CISO, CTO, Head of Eng con: tipo de secrets, severidad, acciones tomadas. Usar template Incident Response.

5. Bloquear acceso público a Docker Hub registry (si posible)

Settings → Visibility → Private. Si es namespace corporativo, considerar hacer TODAS las imágenes privadas temporalmente.

6. Revisar access logs de servicios críticos

• AWS CloudTrail: buscar uso de keys comprometidas

• OpenAI Usage: verificar spikes anormales en requests

• Database logs: IPs desconocidas, queries sospechosas

🔧 FASE 2: Remediation Completa (1-24 horas)

Objetivo: Eliminar TODOS los secrets, rotar credentials, verificar no hay acceso residual

7. Revocar TODOS los secrets expuestos (no solo CRITICAL)

Incluso si son "staging" o "development". Un atacante puede usar staging keys para pivotear a producción.

8. Rotar secrets en TODOS los ambientes (dev, staging, prod)

Generar nuevas credentials en OpenAI, AWS, database. Documentar fecha de rotación para compliance.

9. Eliminar imágenes comprometidas de Docker Hub

docker rmi imagen:tag local + Delete en Docker Hub UI. PERO: solo borrar NO es suficiente, DEBES revocar keys.

10. Escanear base images (inherited secrets)

Si usas FROM empresa/base-image:v1, scanear también esa imagen. Secrets pueden venir de layers heredados.

11. Auditar Git history de Dockerfiles

git log -p Dockerfile | grep -i "api_key\|password\|secret"

Secrets pueden haber sido commiteados y luego removidos, pero persisten en history.

12. Revisar CI/CD secrets (GitHub Actions, GitLab CI)

Settings → Secrets and variables. Verificar que secrets NO estén hardcodeados en .github/workflows/*.yml

13. Verificar environment variables en staging/prod

Kubernetes: kubectl get secret -A

Docker Compose: verificar .env files en servers

14. Forensics: ¿Fue exploited el secret?

Analizar logs para determinar si hubo acceso no autorizado:

• IPs desconocidas

• Horarios inusuales (3am requests)

• Geographic locations inesperadas

• Spikes en volumen de requests

🛡️ FASE 3: Hardening & Prevención (24h - 7 días)

Objetivo: Implementar controles técnicos para que esto NUNCA vuelva a suceder

15. Implementar BuildKit secrets en TODOS los Dockerfiles

Reescribir con RUN --mount=type=secret. Ver ejemplos sección 4 de este artículo.

16. Crear .dockerignore files (template incluido)

Bloquear: .env*, .git, *.key, *.pem, secrets/, credentials/. Template en sección 4.

17. Setup pre-commit hooks (TruffleHog, git-secrets)

Bloquear commits con secrets ANTES de llegar a Git.brew install trufflesecurity/trufflehog/trufflehogtrufflehog git file://. --since-commit HEAD --only-verified --fail

18. Integrar scanning en CI/CD (mandatory gate)

GitHub Actions: step que ejecuta Trivy. Si encuentra CRITICAL, exit 1 (fail build).

19. Migrar a secrets vault (HashiCorp Vault o cloud-native)

AWS Secrets Manager, Azure Key Vault, o Vault OSS. Centralizar gestión de secrets.

20. Enforcar private registries policy

Policy corporativo: TODAS las imágenes deben ir a Harbor/ECR/ACR privado, NO Docker Hub público.

Exception process para casos legítimos de OSS.

21. Crear contractor offboarding checklist

Incluir: revocar Docker Hub access, eliminar de GitHub org, rotar secrets que conocían.

Automation: script que revoca accesos automáticamente al terminar contrato.

22. Implementar secret rotation policy (60-90 días)

Calendar reminders Slack: "Rotar OpenAI key cada 60 días".

O mejor: Vault dynamic secrets con TTL automático.

23. Setup monitoring & alerting (leaked secrets detection)

GitGuardian monitoring continuo de GitHub + Docker Hub.

Slack webhook: alert si secret leak detected.

24. Documentar incident + lessons learned

Post-mortem blameless:

• Timeline: qué pasó, cuándo

• Root cause: por qué pasó

• Impact: daño real vs potencial

• Action items: prevención futura

📊 FASE 4: Governance a Largo Plazo (ongoing)

Objetivo: Mantener higiene de seguridad, compliance continuo, cultura de security awareness

25. Quarterly Docker Hub audits

Calendario: cada 90 días ejecutar TruffleHog en TODAS las imágenes. Verificar compliance.

26. Annual secret rotation (TODAS las credentials)

Incluir: DB passwords, cloud keys, API tokens. Documentar en spreadsheet compliance.

27. Compliance evidence collection (SOC 2, ISO 27001)

Auditors necesitarán:

• Scan reports (Trivy/TruffleHog outputs)

• Secret rotation logs

• Incident response documentation

• Policy enforcement proof

28. Security training (developers + contractors)

Mandatory onboarding module:

• Por qué secrets en Docker son peligrosos

• Cómo usar BuildKit secrets

• Pre-commit hooks hands-on

• Real incident case studies

✅ Completion Checklist: 28/40 Items Cubiertos

Hemos cubierto 28 pasos críticos. Los 12 restantes son específicos de tu stack técnico (Kubernetes vs Docker Swarm, AWS vs Azure, etc). Usa este framework como base y adáptalo a tu infraestructura.

🎯 Objetivo: 100% compliance en 7 días. Download PDF checklist completo abajo.

🎯 Conclusión: Acción Inmediata Requerida

El breach de Flare Security de diciembre 2025 no es solo otra noticia de ciberseguridad. Es una alarma que debería hacer que CADA empresa con contenedores Docker audite sus imágenes HOY.

Las Cifras No Mienten:

- •10,456 imágenes comprometidas en un solo mes de análisis

- •4,000 LLM API keys expuestas (OpenAI, Anthropic, Gemini, Groq)

- •75% de developers NO revocan keys tras eliminar imagen visible

- •42% de imágenes expuestas contienen 5+ secrets simultáneos

- •8.5% de TODAS las imágenes Docker Hub tienen secrets hardcodeados (estudio RWTH Aachen)

Tus Próximos Pasos (Prioritarios):

Escanea tus imágenes AHORA (15 minutos)

Instala TruffleHog o Trivy (ambos gratis), ejecuta scan en tus imágenes más críticas. Comienza con producción.

Si encuentras secrets, sigue FASE 1 del checklist (1 hora)

Revocar credentials CRITICAL inmediatamente. LLM keys, DB passwords, AWS keys con admin. NO esperes.

Implementa pre-commit hooks esta semana

Bloquea secrets ANTES de que lleguen a Git. TruffleHog pre-commit hook toma 10 minutos configurar.

Planea migración a secrets vault (próximos 30 días)

HashiCorp Vault OSS, AWS Secrets Manager, o Azure Key Vault. Centralizar gestión de secrets.

💬 ¿Necesitas Ayuda?

Si tu equipo no tiene bandwidth para implementar esto, o si encontraste secrets y no sabes cómo priorizar la remediation, estoy aquí para ayudar.

Implemento secrets management production-ready con Vault/AWS Secrets Manager + CI/CD hardening + compliance (SOC 2, ISO 27001) en 2-4 semanas.

Solicitar Consulta Gratuita 30 min →La buena noticia: este problema tiene solución técnica clara. No es como un 0-day que requiere esperar un patch del vendor. Tú tienes control total sobre tus Dockerfiles, tu CI/CD, y tus secrets management practices.

La mala noticia: si no actúas, eres vulnerable. Y ahora que sabes que el problema existe, la negligencia ya no es excusa aceptable ante auditors de SOC 2 o reguladores de GDPR.

🚨 No Pospongas Esto

Cada día que pasa con secrets expuestos es un día más de ventana de compromiso. Los atacantes automatizados escanean Docker Hub 24/7 buscando exactamente esto. Tus credenciales pueden estar en manos de alguien ahora mismo, y solo te enterarás cuando veas el spike en tu bill de OpenAI o el unauthorized access en CloudTrail.

¿Necesitas auditoría de seguridad Docker Hub urgente?

Análisis completo de imágenes + remediation guiada en 48 horas

Solicitar Auditoría DevSecOps →

Sobre el Autor

Abdessamad Ammi es CEO de BCloud Consulting y experto senior en IA Generativa y Cloud Infrastructure. Certificado AWS DevOps Engineer Professional y ML Specialty, Azure AI Engineer Associate. Ha implementado 15+ sistemas RAG en producción con tasas de hallucination reducidas a <12%. Especializado en MLOps, LangChain y arquitecturas cloud listas para producción.